Beginnen wir mit einer kleinen Vorgeschichte:

- 2016: Bau eines Low-Power-PCs auf Skylake – 10 Watt im Leerlauf

- 2019: 9 Watt im Leerlauf: Erstellen eines energiesparenden Heim-NAS-/Dateiservers mit 4 Speicherlaufwerken

- 2021: (kein Eintrag) – 11 Watt mit einem Intel i3-10320 auf einem Gigabyte H470M DS3H

Nicht alle meine Systeme waren so erfolgreich. Im Jahr 2022 habe ich im Rahmen des Projekts Eindämmung der „Gas-Guzzling“-Tendenzen von AMD Radeon mit Multi-Monitorein paar andere Systeme mit 19 Watt und 27 Watt gemessen. Obwohl ich es einige Zeit später geschafft habe, den Stromverbrauch des 27-Watt-AMD-Systems zu senken, ist nicht jede CPU/Motherboard-Kombination für die 10-Watt-Grenze geeignet.

—

Bevor wir weitermachen, möchte ich darauf hinweisen, dass die 7 Watt für dieses System vor dem Einbau eines Speichers angegeben wurden. Die 7 Watt (gemessen an der Wand) beinhalten:

- Hauptplatine (Intel H770)

- CPU (Intel i5-12400)

- 64GB RAM

- SSD (Ubuntu Server 23.04 wird gebootet)

- Netzteil (Corsair)

- C-States im BIOS so eingestellt, dass es C8 erreicht

- powertop mit Auto-Tune (was die USB-Tastatur deaktiviert, wenn der Port in den Ruhezustand ge

Beachten Sie, dass ich, wenn ich nicht zulasse, dass powertop die Tastatur deaktiviert, 8 Watt an der Wand gemessen bekomme.

—

Kommen wir zu den detaillierten Spezifikationen und der Auswahl der Komponenten. Dieses Mal hatte ich die folgenden Ziele:

- geringer Stromverbrauch im Leerlauf

- angemessene CPU-Leistung für die Komprimierung

- in der Lage, 12 Festplatten + mindestens 1 NVMe zu verwalten

- Kapazität, um diese 12 Festplatten (eventuell) in 6 NVMe + 6 SSD SATA zu konvertieren

- die Kosten unter Kontrolle zu halten – da der Kauf eines Motherboards erforderlich wäre, versuche ich, bei DDR4 zu bleiben und eine CPU zu verwenden, die ich bereits habe.

Die Zusammenstellung eines neuen Systems mit der Hoffnung, in den Bereich von 10 Watt zu kommen *von der Wand aus gemessen*, ist oft nicht nur eine Herausforderung, sondern auch ein bisschen ein Glücksspiel. Manchmal muss man einfach seine besten Vermutungen in Bezug auf die Komponenten anstellen, sein System bauen, tunen, was man kann, und die Dinge laufen lassen, wie sie fallen.

Hauptplatine – ASUS Prime H770-Plus D4

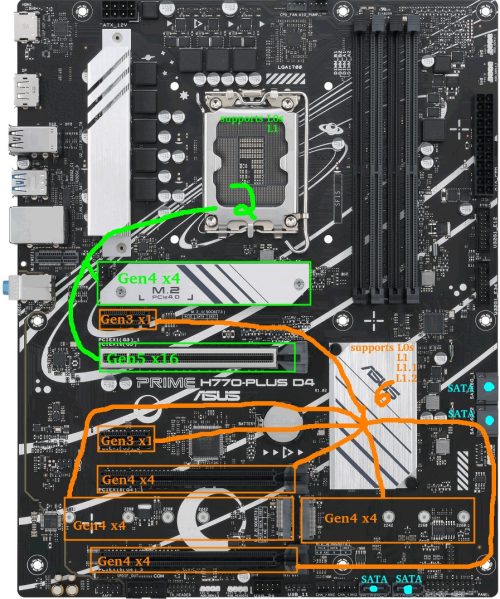

Bevor ich beginne, hier ein kurzer Blick auf das Motherboard-Layout. Die GRÜNEN Steckplätze, die mit der CPU verbunden sind, und die ORANGEfarbenen, die mit dem Chipsatz verbunden sind, werden im Laufe dieses Berichts relevant werden.

Zum Zeitpunkt des Verfassens dieses Artikels waren Mainboards der Intel 600/700-Serie und der AMD 500/600-Serie weithin verfügbar.

Eines meiner oben genannten Ziele war die Kapazität für eventuelle 6 NVMe-Laufwerke.

Ich gehe näher darauf ein, warum dies eine Herausforderung sein kann (Sie können diesen Abschnitt gerne überspringen)…

Problem: Es gibt 0 Consumer-Motherboards mit 6x M.2-Steckplätzen, die alle gleichzeitig im PCIe-Modus genutzt werden können. Bei AMD sieht das MEG X570S Unify-X Max so aus, aber ein Blick ins Handbuch verrät, dass der letzte Steckplatz eine SATA-Variante sein muss, wenn man alle 6 Steckplätze nutzen will. Das ASRock Z790 PG Sonic hat ebenfalls 6 Steckplätze, aber man kann nur 5 davon nutzen (mit einer legitimen Ausrede: Sie bieten einen Gen5-NVMe-Steckplatz an, aber der kommt mit einem Entweder-Oder-Vorbehalt).

Warum es dieses Problem gibt: Es gibt Chipsatz-Lane-Beschränkungen auf Consumer-Boards. Angenommen, ich möchte alle M.2-Steckplätze in Gen4x4 nutzen und ein Hersteller wäre bereit, alle Lanes für M.2-NVMe-Steckplätze zur Verfügung zu stellen (was nicht der Fall ist), würden AMD X570 und Intel B760 maximal drei M.2-Steckplätze bieten, während AMD B650 und Intel H670/Q670/Z690/W680 vier Steckplätze zur Verfügung stellen. Fünf M.2-Steckplätze sind auf AMD X670- und Intel H770-Boards möglich. Sechs auf einem Z790-Board. Darüber hinaus wären außergewöhnliche Maßnahmen erforderlich, wie z. B. das Entfernen von Lanes aus dem Haupt-PCIE-Steckplatz. Wenn die Anzahl der M.2-Steckplätze erhöht werden soll, könnten die Hersteller theoretisch Lanes in Gen4x2 ausführen oder einige Gen3-M.2-Steckplätze hinzufügen, aber dann haben sie ein *sehr* großes Nischenprodukt geschaffen.

Die Lösung: PCI-E-zu-M.2-Adapter wurden notwendig. Bei der Suche nach einem Motherboard ging es nun darum, die vorhandenen M.2-Steckplätze mit allen verfügbaren PCI-E-Steckplätzen, die x4 oder mehr unterstützen, zu kombinieren. Meine Optionen waren nun auf AMD X570-, Intel H770- und Intel Z790-Motherboards beschränkt. Beachten Sie, dass die Verwendung von Bifurkation auf einigen Motherboards zwar eine Möglichkeit ist, mehr als 1 NVMe aus dem Haupt-PCIe-Steckplatz herauszuholen, ich habe mich jedoch entschieden, mich nicht darauf zu verlassen.

Ich habe mich aus mehreren Gründen für die Intel-Route entschieden:

- Chipsatz-TDP: Die Chipsätze der 600/700er-Serie von Intel haben alle einen TDP von 6 W, während der TDP des AMD X670-Chipsatzes ziemlich hoch ist (7 W + 7 W). Der Stromverbrauch der AMD-Chipsätze macht mir seit einiger Zeit Sorgen, da frühere X570-Chipsätze einen TDP von 11 W hatten und einen Lüfter benötigten.

- Chipsatzgeschwindigkeit: Intel H670/Q670/W680/Z690/H770/Z790 Chipsätze haben eine DMI 4.0 x8 Verbindung zur CPU. AMD X570/B650/X670 haben eine PCIe 4.0 x4-Verbindung zur CPU. Theoretisch sollte der Durchsatz bei Intel doppelt so hoch sein wie bei AMD (16 GB/s gegenüber 8 GB/s).

- Ich hatte bereits 64 GB DDR4, die das Intel-System nutzen konnte. AMD-Chipsätze der 600er-Serie sind alle nur für DDR5 geeignet.

- Ich hatte bereits eine Intel-CPU der 12ten Generation.

- Ich habe noch keine positive Diskussion über den Stromverbrauch von AM5 gesehen. Überhaupt nicht. Update: Während ich dies schrieb, gab es Neuigkeiten über AMD-CPUs der 7000er-Serie, die an der Stelle, an der die Pins des Motherboard-Sockels auf die CPU treffen, durchbrennen/beulen. Ja, tut mir leid, AMD, dieses Mal nicht.

Also war es Intel. Nachdem ich mir die auf dem Markt erhältlichen DDR4-Motherboards angesehen hatte, konnte ich die Auswahl schnell auf 2 Hersteller eingrenzen: MSI und ASUS.

Interessieren Sie sich nicht für die Brettvergleiche? Dann können Sie das hier überspringen.

Die verlockenden MSI-Boards waren das PRO Z790-P WIFI DDR4 und das Z790-A WIFI DDR4. Oberflächlich betrachtet sind sie fast identisch, außer dass das „A“ ein wenig hochwertiger ist (Audio, rückwärtige Anschlüsse, Kühlkörper, Leistungsphasen usw.). Vor- und Nachteile:

- Pro: 4x M.2 (Gen4x4) + 1x PCIE Gen5x16 + 1x PCIE Gen4x4 unterstützt insgesamt 6 Gen4 NVMe

- Pro: 2x PCIE Gen3x1 zusätzlich

- Pro: 6 SATA-Anschlüsse

- Nachteil: Intel 2.5G LAN (bekanntermaßen problematisch und fehleranfällig)

- Nachteil: Ich bin kein Fan des MSI-BIOS

- Nachteil: Mein aktuelles B660-Board, das einen höheren Idle-Verbrauch als erwartet aufweist, ist ein MSI.

Attraktive ASUS-Optionen waren das Prime H770-Plus D4 und das Prime Z790-P D4 (optionale WIFI-Edition). Die TUF, Strix oder ProArt waren einfach zu teuer.

Ich beginne mit einer Auflistung der Vor- und Nachteile des H770-Plus:

- Pro: 3x M.2 (Gen4x4) + 1x PCIE Gen5x16 + 2x PCIE Gen4x4 unterstützt insgesamt 6 Gen4 NVMe

- Pro: 2x PCIE Gen3x1 zusätzlich

- Nachteil: Nur 4 SATA-Anschlüsse

Pro: 2.5G Realtek Netzwerkadapter (heutzutage dem Intel 2.5G LAN vorzuziehen)(siehe Kommentare)Das Z790-P D4 ist ähnlich, hat aber mehr Leistungsphasen, bessere Kühlung, mehr USB-Anschlüsse, einen zusätzlichen Lüfteranschluss und für unsere Zwecke…:

- +1 PCIE Gen4x4

- -1 PCIE Gen3x1

Letztendlich war das ASUS Prime H770-Plus D4 zu diesem Zeitpunkt etwa 100 Dollar günstiger und ich habe mich dafür entschieden.

Ein Vorteil, den ich bei „billigeren“ Boards festgestellt habe, ist, dass sie in der Regel weniger Komponenten haben und daher im Leerlauf weniger Strom verbrauchen, obwohl das nicht immer eine Gewissheit ist.

CPU – Intel i5-12400 (H0 stepping) – Alder Lake

Ich hatte diese CPU bereits als Teil eines früheren Desktop-Builds. Damals wurde sie für das Desktop-System ausgewählt, weil:

- sie AV1-Hardware-Dekodierung hatte

- sie die höchste verfügbare Leistung aus der Intel-Produktpalette der 12. Generation hatte, die den E-Core-Silizium-Overhead vermeidet

- in diesem Build wollte ich sowieso ein neues Motherboard mit 2xDP kaufen, und eine ältere Generation zu verwenden, machte für mich keinen Sinn.

Dieses Desktop-Build erwies sich als Enttäuschung und zählt zu meinen unbeliebtesten Builds.

Einige Details…

Ich hatte Probleme, bei denen manchmal nur einer von zwei DP-angeschlossenen Monitoren in Linux aufwachte, was bedeutete, dass ich entweder den anderen DP-Anschluss ziehen/umstecken oder das System manuell in den Ruhezustand versetzen/fortsetzen musste, damit es erneut versucht werden konnte.

Ein weiteres Problem war, dass ein Neustart zwischen Windows/Linux manchmal seltsame Probleme verursachte, die ein vollständiges Ausschalten/Neustarten erforderten.

Die Hardware-Dekodierung unter Ubuntu mit Wayland ist immer noch problematisch, und wenn Programme versuchten, damit Videos abzuspielen, traten Probleme auf.

Im Gegensatz zu meinen vorherigen Intel-Systemen, die alle unter die 10-Watt-Marke gebracht werden konnten, lief dieses System mit 19 Watt im Leerlauf, obwohl ich vermutete, dass das von mir verwendete MSI-Motherboard ein Faktor sein könnte.

Die meisten Kopfschmerzen, die ich hatte, betrafen die GPU und den Bildschirm. Da ich im Begriff war, etwas Serverorientiertes zu bauen, war das kein Faktor mehr.

SPEICHER – 64GB DDR4-3200

Das habe ich verwendet:

- 2x16GB Kingston HyperX dual-rank (Hynix DJR)

- 2x16GB Kingston HyperX single-rank (Hynix CJR)

Das war Speicher, den ich bereits hatte. Ich habe die 4 Speichersticks mit dem XMP-Profil des Dual-Rank-Kits betrieben, das 16-18-18-36 betrug. Alles andere habe ich im Wesentlichen auf den Standardwerten belassen, außer dass ich den RAM mit 1,25 Volt betrieben habe (höher als die Standardwerte von 1,20, aber niedriger als die XMP-Einstellung von 1,35 Volt). TestMem5 und Memtest86 zeigten Stabilität bei 1,22V, obwohl Tests dieses Speichers auf früheren Motherboards gezeigt hatten, dass 1,22V instabil waren, also erhöhte ich die Spannung auf 1,25V, um einen kleinen zusätzlichen Puffer in Sachen Stabilität zu haben.

Boot-Laufwerk – Sandisk Ultra 3D 1TB SSD

Diese Komponente wurde nicht absichtlich gewählt. Als ich eine frische Ubuntu-Server-Installation zum Testen durchführen wollte, war dies die einzige SSD, die ich noch herumliegen hatte und die gerade nicht benutzt wurde. Ich wollte viele A/B-Tests mit PCIE- und NVMe-Geräten durchführen, so dass die Installation von Ubuntu 23.04 auf einer SATA-SSD sinnvoll war, um PCIE-Steckplätze frei zu halten.

Beachten Sie, dass das Hauptbetriebssystem nach den Tests auf einer Samsung SSD 970 EVO Plus 500GB NVMe ausgeführt werden sollte. Dazu gibt es nicht viel zu sagen, außer, dass die Samsung-Laufwerke dazu neigen, zuverlässig in den Energiesparmodus zu wechseln.

Da ich beide Laufwerke verwendet habe, kann ich bei meinen Tests keinen Leistungsunterschied zwischen ihnen messen. Tom’s Hardware testete die Samsung im Leerlauf mit 0,072 Watt (über ASPM/APST), und Anandtech testete die Sandisk Ultra 3D im Leerlauf mit 0,056 Watt (über ALPM). Beide liegen deutlich unter der 1-W-Auflösung meines Kill-A-Watt-Meters.

Netzteil – Corsair RM750

So sehr dieses 750-W-Netzteil für ein System, das auf 10 Watt ausgelegt ist, als Overkill erscheinen mag – wenn 12 Laufwerksmotoren gleichzeitig laufen, ist die momentane Last wahrscheinlich ziemlich hoch. Seagate gibt 2A/3A DC/AC-Spitzenströme auf der 12-V-Schiene für eines seiner 10 TB 3,5-Zoll-Laufwerke an. Selbst die Spitzenwerte für zufällige Lese-/Schreibvorgänge können über 2 A betragen.

Dieser stoßweise Strombedarf kann problematisch werden, wenn das Netzteil der Aufgabe nicht gewachsen ist. Wenn ein Array aus 6 Laufwerken zusammen 150-200 Watt zieht, während die CPU in der Spitze 120 Watt zieht, ist das ein Sprung von etwa 10 Watt im Leerlauf auf etwa 400 Watt. Dies kann leicht zu einem sofortigen Spannungseinbruch führen – wenn der Einbruch groß genug ist, um einen sofortigen Absturz/Neustart zu verursachen, ist das wahrscheinlich keine große Sache, aber wenn der Einbruch gerade groß genug ist, dass Daten während einer Speicheraktualisierung oder wenn ein anderes Laufwerk mitten im Schreibvorgang ist, beschädigt werden… ist das ein schmerzhafteres Problem. Eine gewisse Überdimensionierung des Netzteils (oder das Hinzufügen von Kondensatoren zu den Stromschienen) ist sinnvoll.

Glücklicherweise ist ein Großteil der Corsair RM-Serie trotz des Betriebs außerhalb des Spitzenwirkungsgrads in einem weiten Bereich ziemlich effizient.

Leistungsmessungen – Initial

Ein paar wichtige Informationen:

- Die Leistung wurde an der Wand gemessen

- Intel PowerTOP wurde zur automatischen Anpassung der Einstellungen verwendet

- Ubuntu Server 23.04

Ein paar potenziell wichtige BIOS-Bits:

- CPU C-States wurden im BIOS aktiviert (C10)

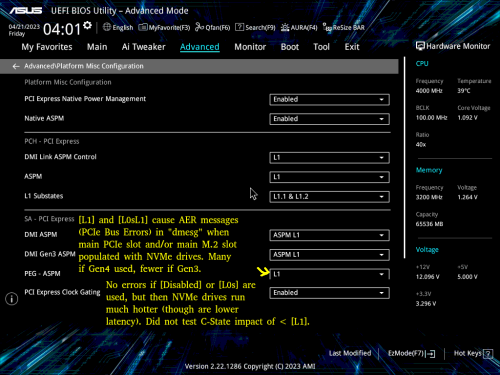

- ASPM wurde aktiviert und alles auf L1 gesetzt

- RC6 (Render Standby) aktiviert

- Aggressive LPM-Unterstützung aktiviert (ALPM)

- DEAKTIVIERT: HD-Audio, Konnektivitätsmodus, LEDs, GNA-Gerät, serieller Anschluss

9-10 Watt war der Verbrauch, wenn die Bildschirmausgabe eingeschaltet war.

7 Watt war der Verbrauch, wenn das Display ausgeschaltet war (Kernel-Boot-Parameter consoleblank=600 für einen 600-Sekunden-Timer), was bei diesem System die meiste Zeit der Woche der Fall ist.

8 Watt war der Verbrauch, wenn die Energieverwaltung der USB-Tastatur deaktiviert war. Wenn man sich nicht per SSH in den Server einwählt, kann es notwendig sein, das zusätzliche Watt für die Tastatur zu verwenden.

Problematische Leistungsmessungen – Belastet mit sich drehendem Rost (nicht drehend)

Wie eingangs erwähnt, habe ich mit 12 Festplatten begonnen. Die Hälfte waren 2,5″ und die andere Hälfte 3,5″. Da das Motherboard nur 4 SATA-Anschlüsse hat, wurden ein SATA-Controller und ein Port-Multiplier verwendet, um die restlichen Laufwerke zu verwalten. Zusätzlich wurden anfangs 4 NVMe-Laufwerke verwendet: eines davon, ein Western Digital SN770, neigte dazu, selbst im Leerlauf ziemlich heiß zu werden, was darauf hindeutet, dass es wahrscheinlich nicht in den Energiesparmodus ging.

Mit allen angeschlossenen Geräten, im Leerlauf, mit ausgeschaltetem Bildschirm und mit den 12 Laufwerken im Standby-Modus war ich schockiert, als ich feststellte, dass mein Stromverbrauch im Leerlauf von 7 Watt auf satte 24-25 Watt gestiegen war. Viel zu viel! Irgendetwas stimmte nicht.

Rätsel des Stromverbrauchs – Untersuchung und Diagnose bei hohem Stromverbrauch

Ich trennte die Festplatten und begann, die Komponenten einzeln zu testen. Das waren ziemlich grobe Tests, um eine ungefähre Vorstellung von dem Übeltäter zu bekommen, daher sind die Zahlen hier nicht präzise.

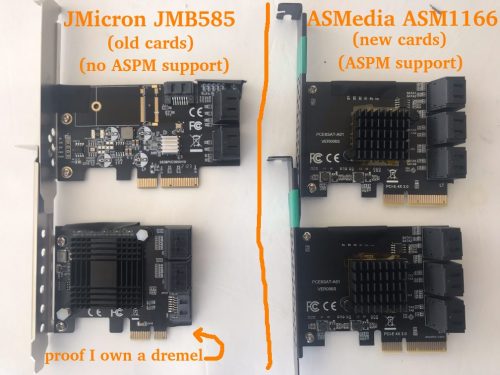

Ich fand schnell heraus, dass der von mir verwendete JMB585-SATA-Controller den Stromverbrauch um etwa 6-10 Watt erhöhte (genaue Messungen in einem späteren Abschnitt). Der Controller selbst sollte nur ein paar Watt verbrauchen, und der winzige Kühlkörper blieb kühl, also war da offensichtlich mehr los. Wohin ging der Strom?

Ich beschloss, die C-Zustände des CPU-Pakets zu beobachten. Ohne den JMB585-SATA-Controller erreichte das System C6. Als der JMB585 wieder angeschlossen wurde, erreichte das System höchstens C3. Aha! Aber warum? Es stellte sich heraus, dass die CPU nicht in den Tiefschlaf geht, wenn ein über PCIE angeschlossenes Gerät nicht in den ASPM L1-Modus wechselt. Die JMB585-Controllerkarten scheinen keine ASPM-Unterstützung zu haben.

Bei weiteren Experimenten fand ich noch etwas anderes heraus, das ich nicht kannte, und das hat mit C6 vs. C8 zu tun. Das System erreicht nur dann C8, wenn nichts an die an die CPU angeschlossenen PCIE-Lanes angeschlossen ist. Mit anderen Worten: Wenn irgendetwas an den oberen PCIE-Steckplatz oder den oberen NVMe-Steckplatz angeschlossen ist, ist C6 das Maximum. Der Unterschied in der Leistungsaufnahme zwischen C6 und C8 schien in einem einfachen Test weniger als ein Watt zu betragen.

Während C8 also ein Luxus wäre, war C6 ein Muss. C3 verbraucht zu viel Strom. Wenn SATA-Controller die CPU daran hindern, die besten Stromsparzustände zu erreichen, begann ich mich zu fragen, ob ich nach einem Motherboard mit 6-8 SATA-Anschlüssen hätte suchen sollen, damit ich nicht auf zusätzliche Controller angewiesen wäre…

Eine kleine Suche nach SATA-HBAs ergab, dass es hier zwar nicht viele Optionen gibt, aber der ASM1166 SATA-Controller sollte ASPM L1 unterstützen, obwohl die Firmware geflasht werden muss, damit er richtig funktioniert (und auf neueren Intel-Boards überhaupt funktioniert). Das mußte ich bestellen: Ich habe Marvel- und JMicron-Ersatzteile, aber die unterstützen kein ASPM. Eigentlich hatte ich ASMedia seit Jahren gemieden, aber aus der Not heraus bekamen sie jetzt eine neue Chance: Ich bestellte ein paar ASM1166 6-Port-SATA-Controller.

Nebenbei: BadTLP, Bad! AER-Bus-Fehler aus dem pcieport

Eine Erwähnung wert… Während der anfänglichen Tests mit einer WD Black SN770 (Gen4 NVMe) fand ich ein Problem, wenn die primären (oben an die CPU angeschlossenen) PCIE- und NVMe-Ports verwendet wurden. Das Ausführen von dmesg führte zu einer Ausgabe, die mit Dingen wie diesen übersät war:

pcieport 0000:00:06.0: AER: Corrected error received: 0000:02:00.0

nvme 0000:02:00.0: PCIe Bus Error: severity=Corrected, type=Physical Layer, (Receiver ID)

pcieport 0000:00:06.0: PCIe Bus Error: severity=Corrected, type=Data Link Layer, (Transmitter ID)

pcieport 0000:00:06.0: AER: Error of this Agent is reported first

nvme 0000:02:00.0: [ 6] BadTLP

…nach vielem Ausprobieren fand ich heraus, dass keine Fehler auftraten, wenn die BIOS-Einstellung „PEG – ASPM“ auf [Disabled] oder [L0s] gesetzt war.

Natürlich war dies eine schlechte Option, da [L1] für die Energieeinsparung entscheidend ist. Wenn [L1] oder [L0sL1] verwendet wurde, bestand die einzige Möglichkeit darin, die Link-Geschwindigkeit dieser Ports auf [Gen3] zu setzen, was die Fehler zwar nicht beendete, aber erheblich reduzierte.

Einige Nachforschungen ergaben, dass die Grundursache eine Vielzahl von Dingen sein kann. Da der Austausch des Motherboards oder der CPU kein angenehmer Gedanke war, bestand meine beste Hoffnung darin, auf eine andere NVMe-Marke umzusteigen.

Ich bestellte einige Crucial P3 NVMe-Laufwerke. Dies erwies sich als erfolgreiches Unterfangen: Nachdem ich die WD-Laufwerke durch die Crucial-Laufwerke ersetzt hatte, traten keine Fehler mehr auf, obwohl es sich um Gen3-Laufwerke handelt.

Rätsel des Stromverbrauchs – L1.1 und L1.2 sind nur bei mit dem Chipsatz verbundenen Anschlüssen aktiviert

Als ich die beiden Crucial P3 NVMe-Laufwerke in dem mit der CPU verbundenen PCIEx16-Steckplatz und dem oberen M2-Steckplatz installiert hatte, bemerkte ich höhere Leerlauftemperaturen als erwartet. Während der NAND bei etwa 27-29 °C lag, meldeten die Controller 49-50 °C – viel mehr als ich für diese speziellen Laufwerke erwartet hatte.

Ich wechselte die Festplatte vom PCIEx16-Steckplatz in einen mit dem Chipsatz verbundenen PCIEx4-Steckplatz. Ein interessanter Unterschied zwischen diesen Laufwerken zeigte sich über lspci -vvv:

CPU-verbundener M2-Steckplatz: L1SubCtl1: PCI-PM_L1.2- PCI-PM_L1.1- ASPM_L1.2- ASPM_L1.1-

Chipsatz-verbundener PCIE-Steckplatz: L1SubCtl1: PCI-PM_L1.2+ PCI-PM_L1.1+ ASPM_L1.2+ ASPM_L1.1+

L1-Sub-States scheinen nur auf den Chipsatz-verbundenen Steckplätzen aktiviert zu werden. Das ist bedauerlich, aber es scheint mit den verfügbaren BIOS-Einstellungen im obigen Screenshot übereinzustimmen.

Schauen wir uns noch einmal das Bild des Motherboards an, um die Situation zu verdeutlichen:

Ich habe beide NVMe-Laufwerke an die mit dem Chipsatz verbundenen PCIE-Steckplätze angeschlossen. Jetzt zeigten beide L1.1+/L1.2+ an und die Temperatur des Controllers sank von 49-50C auf 38-41C.

Leider konnte ich bei verschiedenen A/B-Tests mit diesen beiden Crucial NVMe-Laufwerken mit unterschiedlichen Steckplatzkonfigurationen und verschiedenen BIOS-Einstellungen ein sehr inkonsistentes Temperaturverhalten feststellen, obwohl das JMB585 und ein NVMe-Boot-Laufwerk während dieser Tests ebenfalls angeschlossen waren. Zum Beispiel konnten beide Laufwerke im Leerlauf bei etwa 40 °C liegen, bis ein Soft-Neustart durchgeführt wurde, woraufhin 1 (oder beide) nun im Leerlauf im Bereich von 50 °C liegen konnten. Manchmal schien es möglich zu sein, ein Laufwerk an der mit der CPU verbundenen M.2-Festplatte zu belassen und die Temperatur von 40 °C auf beiden Laufwerken beizubehalten, solange der x16-Steckplatz nicht belegt war. Vermutlich habe ich eine Art Fehler entdeckt. Die Samsung Boot-NVMe-Laufwerke schienen eine konstante Idle-Temperatur zu halten, unabhängig davon, was mit den Crucial NVMe-Laufwerken geschah, also vermutete ich, dass die Crucial-Laufwerke selbst zumindest teilweise schuld daran waren.

Interessanterweise sank die Temperatur eines (oder beider) Controller manchmal bis in den Bereich von 29 °C, wenn die mit dem Chipsatz verbundenen Steckplätze verwendet wurden. Da die Suche nach einem stromsparenden 4TB-NVMe-Ersatz für die Crucial P3 kein realistisches Ziel war, bestand meine größte Hoffnung zu diesem Zeitpunkt darin, dass die ASPM-inkompatible JMicron JMB 585 irgendwie daran schuld war, da sie bald durch die ASPM-kompatible ASMedia ASM 1166 ersetzt werden sollte.

Verspätetes Update: Leider habe ich die Temperaturen während des restlichen Tests nicht im Auge behalten, und die Kühlkörper/Luftströme zwischen den Laufwerken sind alle durcheinander geraten. Aber was auch immer es wert ist, im endgültigen Build liegen die Temperaturen meines Crucial P3-Controllers bei 31-34°C und die NAND-Temperaturen bei 23-24°C.

Rätsel des Stromverbrauchs – Umstieg vom JMB585 auf den ASM1166.

Nach ein paar Wochen kam die ASM1166 an. Zunächst ein paar Informationen über die Karte, die Sie vielleicht hilfreich finden, wenn Sie sie in Betracht ziehen…

Ich begann mit einem Firmware-Flash – ASM1166-Karten haben oft eine alte Firmware, die nicht mit Intel-Motherboards der 600er-Serie funktioniert und, soweit ich weiß, Probleme mit der Energieverwaltung haben kann. Neuere Firmware kann an verschiedenen Stellen gefunden werden, aber ich entschied mich für eine Kopie von SilverStone („fix compatibility issue“ im Download-Bereich von https://www.silverstonetek.com/en/product/info/expansion-cards/ECS06/) und folgte den Anweisungen auf https://docs.phil-barker.com/posts/upgrading-ASM1166-firmware-for-unraid/. Beachten Sie, dass die SilverStone-Dateien einen identischen MD5-Wert hatten wie die Firmware, die ich in dem Thread auf https://forums.unraid.net/topic/102010-recommended-controllers-for-unraid/page/8/#comment-1185707 gefunden habe.

Für alle, die vorhaben, eine dieser ASMedia-Karten zu kaufen, sollte ich anmerken, dass die Qualität wie bei den meisten SATA-Controllern und HBAs da draußen sehr unterschiedlich ist. Eine meiner Karten hatte einen Kühlkörper, der ein wenig schief saß: Das Wärmeleitpad war dick genug, um zu verhindern, dass er nahe gelegene Komponenten kurzschließt, aber seien Sie sich darüber im Klaren, dass diese Produkte sehr fehleranfällig sein können. Dies ist eine der Situationen, in denen es sinnvoll sein kann, etwas mehr zu bezahlen, um bei einem Anbieter mit guten Rückgaberechten zu kaufen.

Ich habe eine ganze Reihe von A/B-Tests durchgeführt, daher hier ein schneller Vergleich „JMicron JMB585 vs. ASMedia ASM1166“ in Bezug auf den Gesamtstromverbrauch des Systems, auch wenn er vielleicht nur für diese Plattform (oder vielleicht sogar nur für dieses spezielle Motherboard) gilt.

ANTRIEBSLOS

Zunächst wird der Stromverbrauch ohne angeschlossene Laufwerke gemessen (das SATA-SSD-Boot-Laufwerk ist an das Motherboard angeschlossen), um eine Basislinie zu erhalten. PowerTOP wurde für alle Geräte außer der Tastatur verwendet (+1 Watt hinzugefügt). Messungen, nachdem der Display-Ausgang in den Ruhezustand überging.

- 8 Watt – Kein SATA-Controller – C8-Stromversorgungszustand

- 9 Watt – ASM1166 auf einem mit dem Chipsatz verbundenen x4-Steckplatz – Leistungszustand C8

- 12 Watt – JMB585 auf dem mit der CPU verbundenen x16-Steckplatz – Leistungsstatus C3

- 15 Watt – JMB585 auf einem mit dem Chipsatz verbundenen x4-Steckplatz – Leistungszustand C3

- 22 Watt – ASM1166 auf dem CPU-verbundenen x16-Steckplatz – Leistungszustand C2

Das ASM1166 schneidet hier gut ab, wenn es in einen mit dem Chipsatz verbundenen Steckplatz eingesteckt wird (nur +1 Watt), aber es schneidet schrecklich ab, wenn es an den Haupt-PCI-E-Steckplatz angeschlossen wird (+14 Watt), wo der Leistungsstatus des CPU-Pakets auf C2 sinkt. Schockierenderweise verhält sich der JMB585 genau andersherum, sein Verbrauch ist auf dem mit der CPU verbundenen Steckplatz geringer (und er verursacht kein C2) – Sie werden jedoch bald sehen, dass sich die Dinge ändern, wenn die Laufwerke tatsächlich angeschlossen sind…

Ich habe zusätzliche Tests mit den Controllern durchgeführt, einschließlich „Reise nach Jerusalem“ mit ein paar NVMe-Laufwerken, um zu sehen, ob mehrere Geräte einen Schraubenschlüssel in die Dinge werfen würde, aber nichts Unerwartetes stattgefunden hat, so dass ich diese Details überspringen werde.

WENN FESTPLATTEN INSTALLIERT SIND

Nachdem die Basismessungen abgeschlossen waren, war es an der Zeit, einige Laufwerke an diese Controller anzuschließen. Das SATA-SSD-Boot-Laufwerk blieb auf der Hauptplatine, 2 NVMe-Laufwerke wurden der Mischung hinzugefügt (mit dem Chipsatz verbunden, sofern nicht anders angegeben), und 4 der 2,5-Zoll-SATA-Festplatten wurden auf dem Controller platziert. Ich werde den Verbrauch im „heruntergefahrenen Zustand“ auflisten, nachdem die Festplatten in den Standby-Modus gegangen sind – im „hochgefahrenen Zustand“ war er in jedem Test genau 2 Watt höher, während die Festplatten im Leerlauf waren.

- 10 Watt – ASM1166 auf einem mit dem Chipsatz verbundenen x4-Steckplatz – Leistungsstatus C8

- 11 Watt – ASM1166 in einem mit dem Chipsatz verbundenen x4-Steckplatz mit 1 NVMe, das in den mit der CPU verbundenen x16-Steckplatz verschoben wurde – Leistungszustand C6

- 11 Watt – 2x ASM1166 auf mit dem Chipsatz verbundenen x4-Steckplätzen, mit nur 1 NVMe-Laufwerk – Leistungszustand C8

- 16 Watt – JMB585 auf einem Chipsatz-verbundenen x4-Steckplatz – Leistungszustand C3

- 24 Watt – JMB585 auf einem CPU-verbundenen x16-Steckplatz – Leistungszustand C2

Bei 4 über einen mit dem Chipsatz verbundenen Steckplatz angeschlossenen Laufwerken erhöht der ASM1166 den Stromverbrauch des Systems um +2 Watt, während der JMB585 +8 Watt verbraucht. Unbestritten.

Ein zusätzlicher Vorteil ist, dass ich beide ASM1166-Karten im System verwenden konnte, während der Versuch, beide JMB575-Karten gleichzeitig zu verwenden, dazu führte, dass sich das System weigerte zu booten, obwohl das ein plattform- oder mainboardspezifisches Problem sein könnte.

Es gibt jedoch einen Kompromiss – ich habe die JMB585 immer als grundsolide und zuverlässig empfunden, auch in Verbindung mit einem JMB575-Portmultiplier. Meine bisherigen Erfahrungen mit ASMedia-SATA-Controllern waren weniger gut: Die Zuverlässigkeit des ASM1166 bleibt abzuwarten, aber zumindest ist er ein schlechter Kandidat für einen Port-Multiplier, da er kein FBS unterstützt (nur CBS).

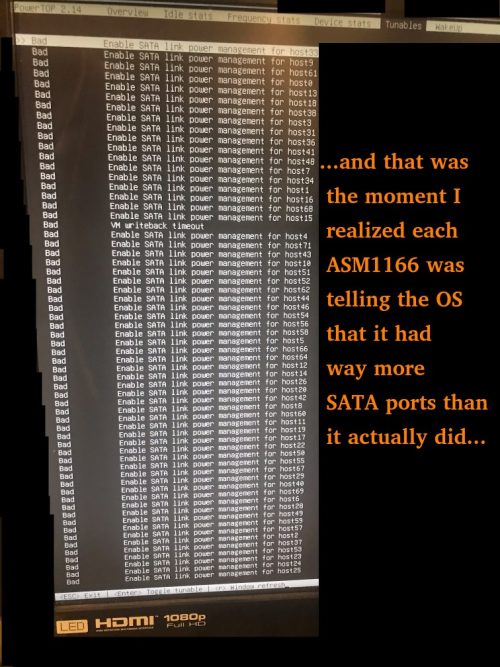

Ein paar andere kleinere Probleme, die mit dem ASM1166 auftraten:

- Beim Entfernen/Wiedereinsetzen des NVMe-Boot-Laufwerks erschien eine BIOS-Meldung, die besagte, dass aufgrund einer GPT-Beschädigung nicht gebootet werden konnte. Die ASM1166-Karten mussten vorübergehend entfernt werden, damit das BIOS das NVMe-Boot-Laufwerk wieder „finden“ konnte (danach konnten sie wieder installiert werden).

- Die ASM1166-Karten geben an, über *viele* Ports zu verfügen – dies verursacht zusätzliche Boot-Zeit, da Linux alle Ports durchlaufen muss.

Update: SATA und SSD-Marken

In einem der Kommentare wurde erwähnt, dass eine ältere Samsung 840 PRO SSD auf C3 begrenzt ist, während eine Crucial Force GT SSD C8 erlaubt. Obwohl es sich um ältere Laufwerke handelt, fand ich dies dennoch etwas überraschend. Es war eine Untersuchung wert.

Ich habe das H770 als Testumgebung mit einem Samsung 850 EVO SATA SSD-Boot-Laufwerk zusammen mit einem Crucial P3 NVMe verwendet und einen benutzerdefinierten Kernel erstellt, damit der Realtek-Netzwerkadapter L1.2 erreichen kann. Kein ASM1166, nur die Intel onboard SATA. Ich erreichte C10, nachdem ich powertop mit auto-tune laufen ließ und den Bildschirm in den Ruhezustand versetzte. Ich habe verschiedene Laufwerke ausprobiert, die ich zur Hand habe, und das System jedes Mal ausgeschaltet, um die Laufwerke zu wechseln und den Vorgang zu wiederholen. Hier sind die Ergebnisse.

Laufwerke, die dazu führten, dass das System bei C6 hängen blieb:

- 1TB Patriot P210 SATA SSD

Laufwerke, die C10 ermöglichten:

- 500GB Samsung 850 EVO SATA SSD

- 4TB 2,5-Zoll-Seagate-SATA-Festplatte

- 8TB 3,5-Zoll-SATA-Festplatte von Seagate

- 14TB Toshiba SATA HDD

- 1TB Sandisk Ultra 3D SATA SSD

- 4TB Sandisk Ultra 3D SATA SSD (Hinweis: langsamer Abgleich)

- 4TB Crucial MX500

Ich empfehle, bei der Auswahl von SATA-SSDs vorsichtig zu sein. Ich werde versuchen, diese Liste im Laufe der Zeit mit Laufwerken zu aktualisieren, die ich getestet habe, aber denken Sie daran, dass bestimmte Hersteller im Speicherbereich dazu neigen, die Hauptprodukte stillschweigend gegen minderwertige Komponenten auszutauschen. Sie sollten also immer die Leistung aller Speichergeräte überprüfen, die Sie innerhalb Ihres Rückgabefensters kaufen. Sie können gerne einen Kommentar hinterlassen, wenn Sie auf gute oder schlechte Produkte stoßen.

Stromverbrauchsrätsel – Fazit

Ein paar wichtige Punkte, wenn man einen niedrigen Verbrauch anstrebt:

1) Motherboard-Unterstützung und BIOS-Konfiguration sind entscheidend – ich hatte schon Motherboards mit sehr unflexiblen BIOSen. Auf diesem hier müssen „Native ASPM“ und die entsprechenden L1-Zustände aktiviert sein (um OS-gesteuert statt BIOS-gesteuert zu ermöglichen), damit der niedrige Stromverbrauch funktioniert.

2) Alle Geräte müssen ASPM L1 unterstützen. Andernfalls müssen Sie wirklich würfeln. Am schwierigsten ist es, SATA-Controller zu finden, die dies unterstützen – wenn möglich, sollten Sie sich ein Motherboard mit genügend SATA-Anschlüssen mit Intel-Chipsatz besorgen, um keine separate Karte zu benötigen. Ich sollte anmerken, dass es nicht immer selbstverständlich ist, NVMe-Laufwerke zu finden, die unter ASPM den stromsparenden APST-Energiezustand unterstützen, und dass Sie auch hier einige Nachforschungen anstellen sollten.

3) Wenn Sie den Energiestatus C8 erreichen können, vermeiden Sie die Verwendung von an die CPU angeschlossenen PCIe-Lanes (oberer PCIe- und M2-Steckplatz). Bei diesem speziellen Motherboard würde ich Ihnen raten, sie nach Möglichkeit ganz zu vermeiden, es sei denn, Sie benötigen entweder den Low-Latency-Pfad mit voller Bandbreite zur CPU oder Ihre Geräte sind so aktiv, dass sie ohnehin nie schlafen. Es sei daran erinnert, dass sowohl meine JMicron- als auch meine ASMedia-SATA-Karten den C-Status des CPU-Pakets auf C2 sinken ließen, wenn sie in den x16-PCI-E-Steckplatz eingesteckt wurden.

4) Das Messen des Stroms aus der Steckdose ist der einzige Weg, um sicher zu gehen, dass das, was man *denkt*, auch wirklich passiert. Ein Kill-A-Watt-Gerät wird sich im Laufe der Zeit bezahlt machen, wenn Sie es benutzen – bedenken Sie, dass ich mein Gerät 2006 gekauft habe (damals $16USD + $14USD Versand über eBay). Damals stellte ich fest, dass unser selten genutztes Faxgerät, das immer eingeschaltet war, 7 Watt verbrauchte… allein dadurch, dass ich dieses eine Gerät ausschaltete, wenn es in den nächsten 10 Jahren nicht benutzt wurde, hat sich das Kill-A-Watt-Gerät mehr als bezahlt gemacht.

Stromverbrauch bei einer Reihe von HDDs

Nachdem im Laufe dieses Prozesses verschiedene Teile in das System ein- und ausgewechselt wurden, sieht die aktuelle Konfiguration wie folgt aus:

- 1x Samsung 970 EVO Plus NVMe (500GB Boot-Laufwerk)

- 2x Crucial P3 NVMe (jeweils 4TB)

- 5x Seagate 2.5″ HDD (jewiels 5TB – 4TB genutzt)

- 6x Seagate 3,5″-HDD (jeweils 10TB – 8TB genutzt)

- 2x ASM1166-Karten mit SATA-Anschlüssen

Von der Wand gemessene Gesamtleistung (Bildschirm eingeschaltet, Tastatur aktiviert):

- 50 Watt mit allen 11 Festplatten im aktiven Leerlauf

- 38 Watt mit den 6x 3,5″ HDD im Idle_B

- 34 Watt mit den 6x 3,5″ HDD im Idle_C

- 21 Watt mit der 6x 3,5″-Festplatte im Standby_Z (heruntergedreht)

- 18 Watt mit der 5x 2,5″ HDD ALSO im Standby

- 16 Watt bei ausgeschaltetem Displayausgang ALSO

- 15 Watt, wenn PowerTOP die USB-Tastatur deaktivieren kann

Seagate gibt den Standby-Verbrauch dieser 3,5″-Laufwerke mit jeweils etwa 0,8 W und der 2,5″-Laufwerke mit jeweils etwa 0,18 W an. Dies stimmt mit meinen obigen Angaben überein. Meine Zahlen für die aktive Leerlaufzeit stimmen auch ziemlich gut mit den Angaben von Seagate überein.

Die offensichtliche Beobachtung: Im Vergleich zu den übrigen Systemkomponenten sind die 3,5″-Laufwerke stromhungrige Monster.

Die HDDs werden irgendwann durch SSDs ersetzt werden. Da der Stromverbrauch im Leerlauf so niedrig ist wie im HDD-Standby-Modus, besteht keine große Eile, und dieser Prozess wird nach und nach stattfinden, wenn meine HDD-Laufwerke/Ersatzteile sterben und die SSD-Preise sinken.

Der Plan für das „Endspiel“ ist ein reiner SSD-Bau. Ursprünglich war der Plan für 1 Boot-Laufwerk, 6xNVMe (wahrscheinlich Crucial P3 4TB) für ein RAIDZ2-Array und 6xSATA (wahrscheinlich Samsung 870 QVO 8TB) für das zweite RAIDZ2-Array. Da die Verwendung der mit der CPU verbundenen M2/PCIe-Steckplätze nicht nur Unvorhersehbarkeit mit sich bringt, sondern auch leichte Kosten für C-State/Strom/Temperatur mit sich bringt, könnte ich diesen Plan ändern und ein paar NVMe im ersten Array aufgeben und stattdessen SATA verwenden, damit ich die mit der CPU verbundenen Lanes nicht anfassen muss. Die Zeit wird es zeigen.

Unnötige Details zur Lagerung

Dieser Teil ist nur lesenswert, wenn Sie sich für akribische Details über die Lagerung interessieren. Andernfalls können Sie mit dem letzten Abschnitt fortfahren.

NVMe-Boot-Laufwerk

Wie bereits angedeutet, handelt es sich um eine Samsung 970 EVO Plus. Derzeit werden weniger als 4 GB des 500-GB-Speicherplatzes genutzt (eine 64-GB-Swap-Partition ist vorhanden, wird aber immer auf 0 genutzt). Die Wahl fiel ursprünglich auf diese Festplatte, weil Samsung einen guten Ruf für seine Zuverlässigkeit hat (die in letzter Zeit etwas nachgelassen hat), und weil Samsung in Tests immer dann gut abschnitt, wenn es um den Stromverbrauch im Leerlauf ging. Dieses Laufwerk befindet sich fast immer im Leerlauf, und die Temperaturen von Controller und NAND blieben während aller Tests niedrig (20-24 °C). Möglicherweise wird sie irgendwann gegen eine SATA-SSD ausgetauscht, um einen NVMe-Anschluss freizugeben.

2,5″-HDD

Diese Laufwerke werden für das primäre ZFS RAIDZ2-Array mit 6 Laufwerken verwendet – das am meisten genutzte. An einem Tag in der Woche ist sie mit einer Aufgabe beschäftigt, die das Lesen von einigen TB im Laufe von 24 Stunden beinhaltet. Der Rest der Woche wird nur sporadisch genutzt, und die Laufwerke werden die meiste Zeit der Woche heruntergefahren. Wenn Sie sich fragen, warum 2,5-Zoll-Laufwerke anstelle von 3,5-Zoll-Laufwerken verwendet werden, gibt es einen Grund: den Stromverbrauch.

Der Stromverbrauch der 2,5-Zoll-Festplatten von Seagate ist wirklich beeindruckend. Im Leerlauf liegt der Wert bei 0,18 W, im Leerlauf bei 0,85 W, und die durchschnittlichen Lese-/Schreibwerte liegen bei etwa 2 W. Es gibt viele SSDs mit schlechteren Stromverbrauchswerten als diese Spinning Rust. 5 TB Kapazität bedeuten eine Menge Speicherplatz pro Watt.

Die größten Nachteile dieser 2,5-Zoll-Festplatten von Seagate sind:

- Keine großartige Leistung. 80-120 MB/s Spitzenwerte beim Lesen/Schreiben. Fairerweise muss man jedoch sagen, dass viele TLC/QLC-SSDs auf diese Schreibgeschwindigkeiten fallen, wenn ihr SLC-Cache erschöpft ist.

- SMR (Shingled Magnetic Recording). Die Leseleistung ist in Ordnung, aber die Schreibleistung stürzt bei zufälligen Schreibvorgängen absolut ab – sie verhält sich wie eine QLC-SSD ohne SLC-Cache, die auch nicht über TRIM verfügt.

- Geringe Nennauslastung (55 TB/Jahr gegenüber 550 TB/Jahr bei 3,5″-Laufwerken von Exos).

- Keine konfigurierbare Fehlerbehebungszeit (SCT ERC), und diese Laufwerke können bei einem Fehler minutenlang hängen bleiben, während sie unermüdlich versuchen, den problematischen Sektor neu zu lesen. Ubuntu muss so konfiguriert werden, dass es wartet, anstatt zu versuchen, das Laufwerk nach 30 Sekunden zurückzusetzen.

- Höhere Fehlerraten, wenn sie heiß werden (ich musste schon einige austauschen und habe festgestellt, dass sie es nicht mögen, wenn sie heiß laufen).

- Typische HDD-Probleme (langsames Hochdrehen usw.).

Um gegenüber Seagate absolut fair zu sein, werden diese Festplatten als externe USB-Backup-Laufwerke verkauft. Diese 15 mm großen Festplatten aus dem Gehäuse zu nehmen und sie als RAID-Mitglieder in einem NAS zu verwenden, ist nicht gerade eine bestimmungsgemäße Verwendung. Der extrem niedrige Stromverbrauch ist enorm, aber es gibt offensichtliche Kompromisse.

Langfristig werden diese 2,5-Zoll-Laufwerke mit 4/5 TB langsam durch 4-TB-SSD-Laufwerke (möglicherweise alle NVMe) ersetzt werden. SSDs mit einer Kapazität von 4 TB sind seit 2021/2022 für den Endverbraucher verfügbar und kosten etwa das 4-5fache der Spinner. Weniger als 2 Jahre später sind sie auf etwa den doppelten Preis gesunken, und ich erwarte, dass anständige Marken mehr als doppelt so lange halten wie die Spinner von Seagate.

Wenn das Crucial P3 (Gen3)-Modell weiterhin verfügbar ist, werde ich wahrscheinlich bei diesem Modell bleiben, obwohl es auf Gen3-Geschwindigkeiten beschränkt ist. Ich habe die Crucial P3 Plus (Gen4) in Erwägung gezogen, aber der Stromverbrauch war in den Testberichten höher, obwohl es nur sehr wenige Situationen gab, in denen auch die Leistung deutlich höher war. Meine größte Sorge bei der P3 Plus (Gen4) war, dass sie bei Problemen mit ASPM/APST laut Tom’s Hardware im Leerlauf 0,3 W mehr Strom verbraucht als die P3 (Gen3) für das 2-TB-Modell. Ich ziehe es vor, dass der Stromverbrauch im schlimmsten Fall so niedrig wie möglich ist.

3,5″-FESTPLATTE

Wird im sekundären RAIDZ2-Array mit 6 Laufwerken verwendet – ein Backup-Array, das etwa 2 Stunden pro Woche hochgefahren wird und auf das konstant viele Daten geschrieben werden.

Der Stromverbrauch der 3,5-Zoll-Festplatten von Seagate entspricht in etwa dem, was man erwarten würde. Diese 10-TB-Laufwerke verbrauchen im Standby-Modus jeweils 0,8 W, im Leerlauf 2-5 W und beim Lesen und Schreiben 6-9 W.

Hier gibt es zwei Bedenken:

- Diese Laufwerke sind so ausgelegt, dass sie beim Schreiben zusammen etwa 45-50 Watt verbrauchen. Das ist ein bisschen zusätzliche USV-Last, die ich nicht wirklich haben möchte, wenn es während der Backups zu einem längeren Stromausfall kommt (ich bleibe bei 1500-Watt-USVs).

- Diese sind so ausgelegt, dass sie im Standby-Modus zusammen etwa 4,8 Watt ziehen. Auch hier würde es mir nichts ausmachen, etwas USV-Last einzusparen.

Langfristig werden diese Laufwerke wahrscheinlich durch Samsung 870 QVO 8TB SATA-Laufwerke ersetzt. Die 870 QVO verbraucht 0,041 W/0,046 W im Leerlauf mit ALPM, 0,224 W/0,229 W im Leerlauf ohne ALPM und 2,0-2,7 W während einer Kopie (laut Toms/Anandtech).

Preislich gesehen ist die 8TB-SATA-SSD von Samsung derzeit ein gutes Stück teurer als 8TB-Spinner (fast das Dreifache). Wenn diese Laufwerke also nicht aus irgendeinem Grund häufiger verwendet werden, wird der Austausch gegen die SSDs mit ziemlicher Sicherheit warten, bis ich keine Ersatzteile mehr habe.

NVMe-Cache-Laufwerk

Das Ersetzen meines Spinning Rust durch SSDs ist ein Prozess, der wahrscheinlich eine Weile dauern wird.

In der Zwischenzeit hat ZFS einige Optionen, um Hochgeschwindigkeitsspeicher (typischerweise SSD) vor langsamerem Speicher zu nutzen:

- „Special“ Allocation Class – erlaubt es Ihnen, ein vdev speziell für Metadaten und für „kleine“ Blöcke zu erstellen, falls gewünscht.

- Ein Cache-Laufwerk, allgemein bekannt als L2ARC.

Wenn Sie bei der Pool-Erstellung ein „spezielles“ vdev erstellen, werden alle Metadaten (und optional kleine Blöcke einer von Ihnen gewählten Größe) auf dem „speziellen“ vdev statt auf dem rotierenden Rost abgelegt. Sehr schnelle Dateilisten und Verzeichnisdurchläufe, während der Spinning Rust für die Dateien selbst verwendet wird. Ja, Sie können eine Reihe von Verzeichnissen „ls“, ohne Ihre Festplatten aus dem Schlaf zu wecken. Der größte Nachteil ist, dass alle Metadaten auf dieser Festplatte liegen, und wenn sie jemals stirbt, ist der Zugriff auf alle Daten im Grunde genommen weg. Sie sollte also zumindest gespiegelt werden. Vielleicht sogar eine 3-Wege-Spiegelung. Verabschieden Sie sich von ein paar Ports.

Der L2ARC ist ein wenig anders. Es handelt sich im Wesentlichen um einen Level-2-Cache. Wenn der Cache im RAM voll ist, kopiert ZFS einige der Blöcke in den L2ARC, bevor es den Inhalt aus dem RAM entfernt. Wenn das nächste Mal auf diese Daten zugegriffen werden muss, werden sie von der L2ARC anstatt von der Festplatte gelesen. Ein Vorteil gegenüber dem „speziellen“ vdev ist, dass man mit nur einer SSD auskommt – wenn es ein Problem mit den Daten in der L2ARC gibt (schlechte Prüfsumme, Laufwerk stirbt, etc.), liest ZFS den Inhalt einfach von der Originalplatte. Wenn die L2ARC voll ist, fängt ZFS einfach wieder am Anfang der SSD an und überschreibt die Daten, die es vorher geschrieben hat, was einige Vorteile (alte Daten, auf die nie mehr zugegriffen wird) und Nachteile (Daten, auf die häufig zugegriffen wurde und die erneut auf die L2ARC geschrieben werden müssen) hat. Sie können auch nach Belieben L2ARC-Geräte zum Pool hinzufügen/entfernen – wollen Sie eine 64GB SSD, 500GB SSD und 2TB SSD hinzufügen? Nur zu – ZFS wird die Blöcke auf sie verteilen. Möchten Sie die 500-GB-SSD ein paar Tage später aus dem Pool entfernen und anderweitig verwenden? Kein Problem. Der größte Nachteil des L2ARC ist, dass Sie wahrscheinlich Ihren Pool vermasselt haben, wenn Sie beim Hinzufügen des Geräts vergessen haben, „Cache“ anzugeben. Außerdem ist er unvollkommen: selbst bei sorgfältiger Einstellung ist es schwer, ZFS dazu zu bringen, ALLES, was man will, auf den L2ARC zu schreiben, bevor er aus dem Speicher entfernt wird. Gleichzeitig kann die L2ARC, abhängig von Ihren Daten, eine Menge Schreibvorgänge sehen, und Sie müssen den Zustand Ihrer SSD sorgfältig überwachen.

In der Vergangenheit habe ich die „Spezial“-Vdev und die L2ARC benutzt, und ich habe beide gleichzeitig benutzt (man kann die L2ARC sogar anweisen, Dinge, die bereits auf der „Spezial“-Vdev enthalten sind, nicht zu cachen).

Dieses Mal habe ich mich einfach für einen L2ARC auf einer 4TB NVMe entschieden: sobald alle anderen 2,5″-Laufwerke durch SSD ersetzt wurden und die Geschwindigkeitsvorteile eines SSD-Caches nicht mehr gelten, kann ich dieses Cache-Gerät einfach entfernen (obwohl theoretisch ein L2ARC-Cache-Laufwerk, das den Großteil der Lesevorgänge abwickelt, es den anderen NVMe-Laufwerken ermöglichen würde, länger im Energiesparmodus zu bleiben…).

Fazit – Bedauern? Zweifeln? Was hätte anders laufen können?

Im Gegensatz zum ASRock J4005, bei dem ich nach einiger Zeit merkte, dass ich mich in vielerlei Hinsicht selbst in die Knie gezwungen hatte, habe ich hier nicht das gleiche Gefühl. Diesmal hatte ich eine niedrige Leerlaufleistung UND ein ziemlich leistungsfähiges System, das auch dann noch flexibel sein sollte, wenn es in Zukunft wiederverwendet wird.

Ich bin mit der Wahl meiner Komponenten recht zufrieden, obwohl ich neugierig wäre, wie das MSI PRO Z790-P DDR4 (eines der anderen Mainboards, die ich in Betracht gezogen habe) im Vergleich abschneiden würde. Was die Funktionalität angeht, hat das MSI den Vorteil von 6xSATA-Anschlüssen, aber es hat den offensichtlichen Nachteil des berüchtigten Intel 2.5G-Netzwerkchips. Das MSI hat auch einen PS/2-Anschluss, und ich habe noch nie überprüft, ob der Stromverbrauch der PS/2-Tastatur niedriger ist als der des USB-Anschlusses (ich erinnere mich, dass ich 1 Watt einspare, wenn ich zulasse, dass Powertop den USB-Tastaturanschluss abschaltet). Und natürlich wäre es interessant, die ASPM- und ALPM-Einstellungen zu vergleichen und zu sehen, ob die Probleme, auf die ich mit CPU-gebundenen PCIe/M.2-Steckplätzen gestoßen bin, in gleicher Weise bestehen.

Während dieses System derzeit im Leerlauf mit Laufwerken im Standby im Bereich von 15-16 Watt liegt, würde ich, sobald alle HDDs durch SSDs ersetzt sind, einen Leerlaufverbrauch von etwa 10-11 Watt erwarten, was für 72 TB an Laufwerken, 64 GB RAM und einen ziemlich guten Prozessor nicht schlecht ist.

Aktualisierung: Aktuelle Linux-Kernel deaktivieren die L1-Energiesparmodi der meisten Realtek-NICs, was die CPU daran hindert, in vernünftige C-Zustände zu gelangen, was den Stromverbrauch um einiges erhöht. Es gibt zwar Workarounds, aber in Zukunft werde ich mich wahrscheinlich auf Motherboards mit Intel 1-Gigabit-Netzwerkadaptern beschränken (und vielleicht zu Intel 2,5-Gigabit wechseln, wenn klar ist, dass sie alle Probleme gelöst haben). Weitere Details über die Realtek NIC-Situation finden Sie in den Kommentaren unten. Das Skript, das ich tief in den Kommentaren erwähne, finden Sie unter: RTL8125-ASPM.sh.txt .

Ich schätze, eine Menge Kopfschmerzen hätten vermieden werden können, wenn du ein Board mit mehr SATA-Anschlüssen gefunden hättest!

Bei mir ist es mir nie gelungen, meinen Chip über C3 hinaus zu bringen. Ich habe absichtlich versucht, die Anzahl der überflüssigen Komponenten zu reduzieren (wie diese SATA-Controller, von denen ich gelesen hatte, wie fehleranfällig sie sein können).

Ich werde meine BIOS-Einstellungen noch einmal überprüfen, um sicherzustellen, dass ich alle relevanten Dinge, die Sie in Ihrem Artikel erwähnt haben, aktiviert habe.

Sehr interessanter Artikel, vielen Dank.

Also ist Ihnen ECC egal, manche sagen, es sei ein Muss für einen Always-on-Server, besonders mit ZFS.

Außerdem scheinen NVMEs mehr Treibstoff zu verbrauchen als SSDs.

Ich bin auf der Suche nach einem sparsamen ECC-Motherboard, habe aber noch nichts gefunden, W680-Boards sind schwer zu bekommen.

In der Zwischenzeit betreibe ich Unraid auf einem J5040 Asrock Board mit zwei 1TB SSDs im Mirror und 3 mechanischen WDs, die die meiste Zeit schlafen.

Das System verbraucht 19 Watt im Leerlauf, vor dem Hinzufügen eines Asmedia Controllers (4) waren es 16-17 Watt (C6). Ich werde das alte Seasonic-Netzteil bald durch ein Corsair-Netzteil ersetzen.

Viele Grüße

Geert

Denken Sie daran, dass, wenn der zweite M.2-Steckplatz belegt ist, nur 5 der 6 SATA-Anschlüsse funktionieren. Wenn ich mich richtig erinnere, hat das BIOS des H470M DS3H auch einige Optionen versteckt (z.B. IGPU oder dedizierte GPU erzwingen), wenn es nicht in den CSM-Modus versetzt wurde. Außerdem blieb das System auf dem Startbildschirm mit einer Fehlermeldung hängen, wenn ich einen LSI SAS HBA installiert hatte, was einen weiteren Neustartversuch erforderte - normale SATA-Controller funktionierten jedoch problemlos. Abgesehen von diesen seltsamen kleinen Nuancen fand ich es zuverlässig und funktionierte großartig und ich mag das Board sehr.

Haben Sie vor, einen ähnlichen Artikel zu veröffentlichen, aber für ein System mit ECC-Unterstützung und niedrigem Stromverbrauch im Leerlauf, das immer noch mit Linux kompatibel wäre (ich denke, der niedrige Stromverbrauch von AMD im Leerlauf ist nicht das Beste für Linux als Beispiel).

Ich plane, selbst bald ein solches System zu bauen, und würde gerne wissen, ob ich in den nächsten ein oder zwei Monaten mit dem Bau beginnen oder vielleicht noch ein wenig warten sollte, um Ihre Veröffentlichungen zu lesen, die mir einige nützliche Informationen liefern, die mir helfen können, eine fundiertere Entscheidung bei der Auswahl der Komponenten zu treffen.

Nichtsdestotrotz, vielen Dank für den gründlich geschriebenen Artikel. Sie haben hier eine beeindruckende Arbeit geleistet, indem Sie die wichtigen Teile des Aufbaus eines sehr effizienten stromsparenden NAS hervorgehoben haben.

Auf jeden Fall wünsche ich Ihnen viel Erfolg mit Ihrem Bau!

Danke für deine Artikel über NAS, die sehr detailliert und informativ sind!

Ich bin gerade dabei, mein eigenes mit einem i3-10500T, 16GB und 4xHDD aufzubauen.

Als Netzteil habe ich ein Antec EarthWatts 380W EA-380D (80+ Bronze) als Refurbished für 25€ gefunden, ist es das wert? oder ist es zu alt?

Wenn du noch andere Modelle hast, die du mir empfehlen kannst, würde ich mich freuen. Vielen Dank im Voraus.

Ich habe auch eine 970 Evo Plus (2TB) als Boot-Laufwerk und kann bestätigen, dass sie mit dem Chipsatz verbunden sein muss, um niedrige Paket-C-Zustände (C8) zu erreichen. Was ich interessant fand, war, dass der Unterschied zwischen Paket C3 und C8 viel größer war, wenn die SSD mit dem Chipsatz verbunden ist. Ich glaube, das liegt daran, dass der Chipsatz selbst nur dann in den tiefen Ruhezustand geht, wenn alle angeschlossenen Geräte ASPM unterstützen und das SATA Link Power Management aktiv ist.

Der Anschluss der SSD an den CPU-PCIe erhöht den Stromverbrauch nur um ~2W (Paket C3 vs. C8), während ein Gerät ohne ASPM, das an den Chipsatz angeschlossen ist, zusätzliche 5W nur für den Chipsatz zu verbrauchen scheint, aber den gleichen Effekt (C3) auf den Paket-C-Status hat.

Eine interessante Sache ist, dass ich eine PCIe 1.1 DVB-C Capture Karte an den Chipsatz angeschlossen habe. Obwohl ASPM in lspci als Fähigkeit für die Karte aufgeführt ist und ich den Kernel mit pcie_aspm=force gebootet habe, wurde es für diese Karte nicht aktiviert. Ich musste ASPM über setpci erzwingen, siehe https://wireless.wiki.kernel.org/en/users/documentation/aspm - scheint ohne Probleme zu funktionieren. Das half mir, die 15W Leerlaufleistung zu erreichen. Leider verbraucht die Capture-Karte immer noch ~5W, ansonsten habe ich derzeit nur 2x4TB HDD von Toshiba angeschlossen, die im Leerlauf herunterdrehen.

Übrigens muss Sata Hot Plug für alle Ports deaktiviert sein, sonst erreicht das Paket nur C6.

1) Es sieht so aus, dass es besser ist, eine CPU mit integrierter GPU zu verwenden, es sei denn, das Motherboard unterstützt das Booten ohne GPU. Ich hatte vor, den Stromverbrauch zu reduzieren, indem ich die diskrete GPU-Karte (nach der Systeminstallation) entferne, aber dieses Motherboard hängt sich beim Booten auf, wenn keine GPU angeschlossen ist! Beim Herumgoogeln fand ich heraus, dass dieser Zustand für Consumer-Motherboards ziemlich typisch ist. Wenn ich mir die Zahlen von xblax ansehe, kann er im Leerlauf bessere Stromverbrauchswerte erreichen (ok, das Motherboard ist nicht genau dasselbe...).

2) Ich kann den C10-Zustand für alle Kerne erreichen (ganz rechte Spalten im Powertop), aber der im Leerlauf erreichte Paket-C-Zustand hängt davon ab, welcher PCIe-Steckplatz für die diskrete GPU verwendet wird. Wenn ich den ersten PCI-Steckplatz verwende, der von den CPU-Lanes bedient wird, komme ich in 99 % der Zeit nicht über den Paket-C-Zustand hinaus: In dieser Konfiguration liegt die durchschnittliche Netzleistung konstant unter 26 W. Wenn ich die GPU in einen der anderen Steckplätze verschiebe, die von den B760-Chipsatz-Lanes bedient werden, erreicht der Paket-C-Zustand etwa 7 % (C2) und 91 % (C3), die durchschnittliche Leistung fällt unter 22 W, ist aber weniger stabil.

Gibt es irgendeine Möglichkeit, das Ergebnis zu verbessern, oder ist es besser, die 12100 CPU (mit GPU) zu kaufen?

sh -c "echo 1 > /sys/bus/pci/devices/0000:01:00.0/link/l1_aspm"

(Sie müssen 0000:01:00.0 durch den Wert ersetzen, der Ihrer Realtek-Karte entspricht, siehe lspci -vv)

Wenn Sie es ausprobieren, können Sie uns bitte mitteilen, auf welchen C-Status und welche Wattleistung Sie kommen :)

Haben Sie außerdem auf eine iGPU umgestellt und die alte GPU entfernt?

Ich habe gesehen, dass auch jemand mit einem MSI PRO B760M-A WIFI DDR4 (der mit dem ASUS-Prozessor identisch zu sein scheint) das gleiche Problem hat, auch mit dem Asrock B760M Pro RS/D4

ich konnte mit diesem Board etwa 13-14W erreichen, indem ich ASPM L1 auf dem 2.5Gbit-Port, alle BIOS-Einstellungen und "powertop --auto-tune" verwendete.

Kein USB / Bildschirm angeschlossen, nur CPU (12600) und 1 Samsung 980 Pro Nvme in einem Chipsatz-Slot, proxmox läuft im Leerlauf.

Allerdings benutze ich ein Be quiet! Dark Power Pro 11, das bei diesen niedrigen Lasten wohl nicht sehr stromsparend ist. Ich denke darüber nach, nach einer gebrauchten Corsair RM750(/x)/RM650(/x) zu suchen.

Einen guten Test können Sie auf tweakpc.de nachlesen

Super toller Artikel, danke für all diese Informationen.

Ich plane gerade den Bau meines nas. Da der Stromverbrauch das Hauptthema ist, was haltet ihr von folgendem Aufbau (ich bin aber ein ziemlicher Noob, was das System und die Möglichkeiten bzw. Einschränkungen eines solchen Low-TDP-Chips angeht) ?

Asrock N100M micro ATX (mit dem neuen Intel® Quad-Core Prozessor N100 (bis zu 3,4 GHz) mit einem 6W tdp. Da es nur 2 SATA-Ports gibt, ist die Idee, eine SAS-HBA-Karte mit 8 zusätzlichen SATA-Ports auf dem 1 x PCIe 3.0 x16 Slot zu installieren. Für den Speicher wäre es 1 M2 (der vom Motherboard) für TrueNas OS, 2 SSD Mirroring Sata für VM, Docker, ... und 8 HDD Seagate EXO 7200 rpm Laufwerke als letzter Schritt (2 am Anfang und dann entwickelnd basierend auf dem Bedarf).

Für die Stromversorgung, ein Seasonic Focus PX 550W - Modular 80+ Platinum ATX und schließlich eine einzigartige Stick von 32GB Ram (non ECC).

Vielen Dank im Voraus

Was die SAS-HBA-Karte angeht, würde ich vorschlagen, sich umzuschauen, um zu sehen, welchen Stromverbrauch im Leerlauf andere auf der spezifischen Karte, die du in Betracht ziehst, sehen: die populären Karten ziehen oft ein paar Watt, während sie absolut nichts tun. Ich bin mir nicht sicher, wie *BSD mit den Karten umgeht, aber von den wenigen, die ASPM standardmäßig aktiviert haben, scheint Linux es irgendwann im Kernel aufgrund von Problemen zu deaktivieren. Abgesehen davon ist dies eine Situation, in der das ASRock N100 besser abschneiden könnte als eine separate CPU/Motherboard-Kombination, da ich davon ausgehe, dass es weniger empfindlich auf die C-State-Implikationen einer Erweiterungskarte reagiert, obwohl dies nur eine Vermutung ist, basierend auf dem, was ich mit meinen ASRock J4x05-Boards gesehen habe, und möglicherweise nicht auf das N100 zutrifft.

Das Seasonic PX 550W sieht wie eine gute Wahl aus.

Insgesamt sieht es nach einer soliden Konstruktion aus!

Haben Sie irgendwelche Tipps für die Identifizierung von Motherboards, die einen niedrigen Stromverbrauch erreichen können? Manchmal werden ITX-Motherboards empfohlen, aber ich habe keine Messungen darüber gefunden, wie viel Watt ITX im Vergleich zu ATX normalerweise einspart. Nun, ITX wäre für diesen Aufbau nicht geeignet gewesen, aber ATX scheint ohnehin keine signifikante Quelle für den Stromverbrauch gewesen zu sein. Im Allgemeinen scheint es sehr schwierig zu sein, herauszufinden, welche Motherboards stromsparend sind und welche nicht.

Was meinen Sie mit dem "E-Core-Silizium-Overhead" und warum haben Sie versucht, ihn zu vermeiden? Mir ist klar, dass die CPUs mit E-Kernen wahrscheinlich komplexer sind, aber ich hätte gedacht, dass die E-Kerne zu einem geringeren Stromverbrauch führen könnten, wenn die CPU nicht-intensive Aufgaben bei geringer Last ausführt.

Nochmals vielen Dank für die tollen Informationen. Ich hoffe, dass ich in der Lage sein werde, ein System mit einer ähnlichen Energieeffizienz zu bauen. Im Moment habe ich ein Gigabyte Z790 UD AX-Motherboard und ein i5-13500-System, das ich nicht unter 28 W bekommen kann.

Der Vorteil von ITX ist, dass es die Anzahl der Komponenten einschränkt, aber das ist nicht unbedingt notwendig - letzte Woche habe ich das "Intel i3-10320 auf einem Gigabyte H470M DS3H", das ich am Anfang erwähnt habe, wiederverwendet und es auf 6 Watt im Leerlauf heruntergebracht (Headless, keine Tastatur, nur Onboard Intel i219V 1GbE Netzwerk, c-states im BIOS, 3 Samsung SATA SSDs 840/860/870, Corsair RM850 Netzteil, Ubuntu Server mit powertop). Es ist ein sehr utilitaristisches Motherboard. Ich werde keinen separaten Bericht verfassen, da das Board nicht mehr erhältlich ist, aber 6 Watt auf dem MicroATX Gibabyte H470 Board und 7 Watt auf dem ATX ASUS H770 Board in diesem Bericht sind meine besten beiden Ergebnisse bisher, und beide waren nicht ITX. Und noch etwas ist mir aufgefallen: Beide Boards haben nur 6 Leistungsphasen.

Was den "E-core Silizium-Overhead" betrifft, so können viele Details unter https://www.hwcooling.net/en/the-same-and-yet-different-intel-core-i5-12400-duel-h0-vs-c0/ gefunden werden, aber ich werde versuchen, sie zusammenzufassen. Der i5-12400 wird mit 6 P-Kernen und 0 aktivierten E-Kernen ausgeliefert, allgemein als 6+0 bezeichnet. Es gab jedoch 2 Varianten: ein "C0"-Stepping, das ursprünglich ein 8+8 war, bei dem die Kerne zu einem 6+0 verschmolzen wurden, und ein "H0"-Stepping, das direkt als 6+0 hergestellt wurde und von Anfang an keine E-Kern-Hardware enthielt. In den Tests (Seite 5 des Artikels) verbrauchte der C0 je nach Benchmark bis zu 16 Watt mehr Strom als der H0, einschließlich fast 11 Watt mehr im Leerlauf. Es ist natürlich möglich, dass die C0-Probe andere Probleme hatte, die zu Leistungsverlusten führten, oder dass eine andere Variable im Spiel war, aber so oder so haben die beiden Chips mit physischer E-Core-Hardware im Leerlauftest nicht gut abgeschnitten.

Da ich mich bei den meisten meiner Systeme auf einen extrem niedrigen Idle-Verbrauch konzentriere, kann ich den Kauf eines der kombinierten P/E-Core-Chips nicht rechtfertigen, bis ich Daten sehe, die zeigen, dass Chips mit E-Cores im Idle-Betrieb unter 10 Watt liegen. Und das habe ich einfach noch nicht. Dies ist ein Bereich, in dem Intel derzeit sehr bedroht ist: Die AMD Mini-PCs gehen jetzt auf einen Idle-Stromverbrauch von etwa 6-7 Watt für einen Ryzen 9 7940HS ( https://youtu.be/l3Vaz7S3HmQ?t=610 ) herunter und wenn AMD diese Art von APU-Design auf die Desktop-Seite bringt oder jemand wie ASRock anfängt, einige dieser beeindruckenden HS-Chips in ein kundenspezifisches Motherboard zu verpacken, könnte Intel den Markt für niedrigen Idle-Strom schnell verlieren.

Ich kann sehen, dass die Hauptplatine, die ich gekauft habe, wahrscheinlich nicht ideal ist (es wirbt eine Menge von Phasen).

Aber selbst wenn Ihr Board viele ineffiziente MOSFETs hätte, scheint der von Ihnen angegebene Stromverbrauch von 28 Watt etwas hoch zu sein, es sei denn, Sie haben einen sich drehenden Rost oder eine PCIe-Karte, die Strom schluckt. Haben Sie überprüft, ob Sie C6 oder einen besseren Leistungszustand erreichen? Ich erinnere mich, dass ich, als ich den ASM1166 in den Haupt-PCIe-Steckplatz eingesetzt habe, auf C2 beschränkt war und 22 Watt verbraucht habe.

Sie haben in der Tat Recht, dass die 28 W, die ich angegeben habe, nicht optimal waren. Ich habe den Fehler gemacht, zu denken, dass die SATA-Kabel meiner Festplatten ausgeschaltet bleiben, wenn ich sie abziehe. Wie sich im Nachhinein herausstellte, muss man sie auch vom Netzteil abziehen. Außerdem hatte ich eine Reihe von Peripheriegeräten an den PC angeschlossen, von denen ich nicht wusste, dass sie Strom verbrauchen würden (insbesondere ein angeschlossener Monitor macht einen großen Unterschied). Nachdem ich alle Festplatten und Peripheriegeräte abgeklemmt habe, erhalte ich Messwerte im Bereich von 8-10 W.

Um diese Daten hoffentlich für andere nützlich zu machen, werde ich einige weitere Details mitteilen. Die CPU ist ein i5-13500 in einem Gigabyte Z790 UD AX-Motherboard. Das einzige, was angeschlossen ist, ist eine SATA-SSD und ein einzelner Speicherstick. Das Netzteil ist ein 850W Corsair RM850x. Das System erreicht C8 und sogar C10. Man könnte noch ein paar Dinge tun, um die Leistungsaufnahme zu reduzieren. Ich habe gemessen, während GNOME im Leerlauf lief (ich nehme an, wenn kein DE läuft, spart das ein bisschen CPU), ich habe zwei CPU-Lüfter, die selbst bei niedrigen Temperaturen langsam laufen, das System ist auf WiFi (ich nehme an, dass Ethernet weniger Strom verbraucht), und ich habe weder die Gehäuse-LEDs noch HD Audio deaktiviert.

Ich bin jetzt sehr zufrieden mit dem Stromverbrauch. Vielleicht ist eine Erkenntnis, dass die Intel E-Cores die Leistungsaufnahme im Leerlauf nicht sehr beeinflussen, zumindest bei dieser CPU. Das einzige Problem, das ich jetzt habe, ist, dass das System instabil ist und sporadisch neu startet 😭. Ich denke, ich habe das Problem auf eine fehlerhafte CPU oder ein fehlerhaftes Motherboard eingegrenzt (ich habe versucht, das Netzteil zu ersetzen, und memtest86+ sagt, dass der Speicher in Ordnung ist). Die Firma, bei der ich die Teile gekauft habe, behauptet, dass beides in Ordnung ist, aber wenn ich keine andere Lösung finde, werde ich versuchen, die CPU und das Motherboard durch einige Low-End-Teile zu ersetzen: einen i3 der 13. Wenn das Problem damit behoben ist, kann ich die anderen Teile hoffentlich zurückgeben. Im schlimmsten Fall werde ich die günstigen Teile für einen Server und die höherwertigen Teile für eine Workstation verwenden.

ich habe genau das gleiche Setup (i5-13500 + Z790 UD AX), mein Boot-Laufwerk ist Samsung 990 pro 4TB

und ich habe genau das gleiche Problem - sporadische Reboots. Konnten Sie herausfinden, was die Ursache dafür ist?

Ich habe sowohl das neueste BIOS F9b als auch F5 ausprobiert und mehrere BIOS-Einstellungen geändert, aber bis jetzt hat nichts geholfen. Mein Verdacht ist, dass das Boot-Laufwerk in einen Energiesparmodus geht und sich davon nicht erholen kann, aber ich weiß nicht, wie ich das beweisen kann.

es gibt keine Ereignisse vor dem Absturz, ich habe auch netconsole konfiguriert - immer noch nichts protokolliert.

Mit aktuellem BIOS, Standardeinstellungen und 970 evo plus als Bootgerät (keine andere Platte angeschlossen) scheint das System stabil zu sein, aber leider zieht es im Leerlauf durchschnittlich 32W, was nicht akzeptabel ist.

Im Moment ändere ich eine Einstellung nach der anderen und warte 12h+, um herauszufinden, was wirklich die Ursache ist, und das dauert eine Menge Zeit.

Ich habe alle Einstellungen ausprobiert, sobald ich c8/10 aktiviere, wird das System instabil und schaltet sich irgendwann ab. Ich habe alle Laufwerke und Kabel überprüft, die PSU zweimal ersetzt und warte derzeit auf eine CPU-RMA von Intel. Nach diesem Thread hier zu urteilen, scheint es ein Gigabyte-Problem zu sein. Ich habe auch verschiedene BIOS-Firmwares ausprobiert, ohne Erfolg, also scheint es, wenn eine CPU-RMA das Problem nicht behebt, wäre es ein Problem mit Gigabyte z790-Motherboards.

Enttäuschend für sicher, wie ich bin aus der Rückkehr Fenster und wirklich nicht wollen, um mit Gigabyte RMA, so dass, wenn CPU RMA nicht funktioniert, werde ich nur haben, um mit ihm zu leben oder verkaufen Sie es aus und kaufen Sie ein anderes Board.

Da dieser Thread schon ein wenig alt ist (Dez. 2023), frage ich mich, ob jemand anderes dieses Problem hatte und es lösen konnte.

Ich danke Ihnen.

Ich teste derzeit ein ASUS TUF GAMING B760M-PLUS WIFI D4 (12+1 DrMos) und im Leerlauf, mit dem Monitor und USB (Maus, Tastatur) suspendiert, zeigt der Leistungsmesser 6,7-8,1 W. Der Rest des Systems:

- i5 13500

- 2 x 16 GB 3600 MHz (Gang 1)

- 1 TB KC 3000

- RM550x 2021

- 2 x 120 mm Lüfter mit 450 U/min

- Audiocodec eingeschaltet

- WiFi ausgeschaltet

Arch Linux + RTL8125-Modul (mein Router unterstützt EEE nicht)

Bei deaktivierter Realtek-Karte zeigt der Stromzähler 6,4 - 6,7 W an

PC-Zustände mit LAN

C2 (pc2) 0,7%

C3 (pc3) 1,3%

C6 (pc6) 41,1%

C7 (pc7) 0,0%

C8 (pc8) 0,0%

C9 (pc9) 0,0%

C10 (pc10) 55,8%

PC-Zustände ohne LAN

C2 (pc2) 0,6%

C3 (pc3) 0,9%

C6 (pc6) 0,0%

C7 (pc7) 0,0%

C8 (pc8) 0,0%

C9 (pc9) 0,0%

C10 (pc10) 97,8%

Ich hatte ähnliche Ergebnisse auf einer B660 AORUS MASTER DDR4 (16+1+1).

Ich habe vor kurzem einen i3-13100 (4+0) und einen i3-13500 (6+8) gekauft, um die "E-core overhead"-Behauptungen zu testen, die ich online gesehen habe. Ich freue mich, berichten zu können, dass der Stromverbrauch im Leerlauf bei beiden Chips identisch ist! Vielleicht ist der erhöhte Stromverbrauch nur beim i5-12400 C0 der Fall, leider habe ich keinen zum Testen zur Hand.

4W Verlustleistung

Ich verwende derzeit einen nicht mehr geleasten Quanta 1u, den ich kurz vor dem Covid-Hit bei Ebay ersteigert habe, und seine Single-Core-Leistung zeigt wirklich ihr Alter. Außerdem läuft er im Leerlauf mit 80W >.<

Ich würde gerne meine Erfahrungen mit meinem neuen 12-14 W PC teilen.

Ich habe gerade lüfterlose mini-ITX PC gebaut. Gehäuse ist auch ein passiver Kühler - AKASA Maxwell Pro und im Inneren ist AMD Ryzen 5600G (Zen 3, 65W TDP), Gigabyte B550I AORUS PRO AX (Bios FB), 1x 16GB DDR4 (ich plane ein Upgrade auf 2x32GB), 1x 2TB Samsung 980Pro m.2 SSD. Es wird von einem 12V AC/DC-Netzteil von AKASA (max. 150W) und einem Inter-Tech MINI-ITX PSU 160 W versorgt.

12-14W Stromverbrauch im Leerlauf für den gesamten PC unter Windows 10 (gemessen auf der DC-Seite, Energieplan ist ausgeglichen, aber ich habe ASPM, Pstates und C-States im Bios und PCIe-Stromsparen in den erweiterten Einstellungen im Windows-Energieplan aktiviert).

Unter Last (Cinebench R23) 61-65W. Derzeit mache ich Undervolting, um den Stromverbrauch und die Temperaturen zu verbessern.

----------

mein kleines Heimlabor & NAS hat unter 2W Stromverbrauch im Leerlauf ‼️

Ich empfehle Odroid H3 (H3+) mit BIOS 1.11 und Debian 11 + DietPi + Kernel 6.0.0 (oder neuer) + angewandte Tweaks via powertop hat es einen Leerlaufstromverbrauch von nur 1.2 - 1.5W (verglichen mit 2.7W für RPi 4 - Quelle) ⚡️(mit meiner Konfiguration: 1x 16GB RAM und 1x SATA SSD).

See: https://i.ibb.co/7QD390m/H3-1-10-6-0-0-sata-idle.gif

Die maximale Speichergröße ist 64 GB RAM und er hat 1x m.2 Port, 2x SATA 3 und 2x LAN 2.5Gbps. Er ist viel schneller als der Raspberry Pi 4 mit geringerem Stromverbrauch im Leerlauf. Unter Last kann er 20W verbrauchen (+abhängig von den angeschlossenen Geräten).

Wenn Sie mehr SATA-Anschlüsse benötigen, dann kann der m.2-Anschluss auf 5x SATA erweitert werden, indem Sie dies verwenden: https://wiki.odroid.com/odroid-h3/application_note/m.2_to_sata_adapter

Ich kämpfe derzeit damit, mein neues NAS dazu zu bringen, im Leerlauf ohne Datenlaufwerke weniger als 40 W zu verbrauchen, und ich kann beim besten Willen nicht verstehen, warum es so viel verbraucht. Mein Gaming-Desktop verbraucht im Leerlauf weniger.

Es handelt sich um ein Asrock H670M-ITX/ac mit einem i3-12100, 8 GB RAM und einem 400-W-Netzteil von be quiet. Ursprünglich habe ich eine Kingston NV2 NVMe für das Betriebssystem verwendet, aber ich habe festgestellt, dass der Austausch gegen eine SATA SSD den Stromverbrauch im Leerlauf um etwa 10W (50W - > 40W) reduziert hat.

Laut powertop, Kerne erhalten in C7 kein Problem, aber Paket weigert sich, C2 zu verlassen. Ich bin mir nicht sicher, wie wichtig das ist.

Ich werde weiter daran arbeiten, mit Ihrem Artikel als Referenz :)

Matt,

Ihre Artikel haben mich inspiriert, so dass ich das gleiche Motherboard (prime h770 plus d4) und einen ähnlichen Prozessor usw. gekauft habe. Ich war in der Lage, 12-14w Minimum zu erreichen. Damit bin ich im Moment zufrieden, aber die zusätzlichen 8w, die dadurch entstehen, dass das Paket nicht mehr c8 erreicht, sind sehr frustrierend. Haben Sie etwas Ähnliches in Ihrem Build gesehen?

Mehrere Untersuchungen haben ergeben, dass es sich um ein Treiberproblem mit RealTekLAN handelt. Wenn Sie die Treiber für den 8125-Chipsatz von der Realtech-Seite herunterladen und installieren, können Sie c10 wie bisher erreichen.

du solltest ein anderes Netzteil wie das Corsair RM550x (2021) oder BeQuiet 12M 550W in Betracht ziehen. Das Corsair ist das beste Netzteil für Low-Power-Setups, aber extrem schwer zu bekommen. Es wird den Stromverbrauch noch weiter senken (2 bis 4 Watt).

Diese und andere Optimierungen werden in diesem Thema erwähnt:

https://forums.unraid.net/topic/98070-reduce-power-consumption-with-powertop/

Leider handelt es sich dabei um eine absichtliche Änderung des im Kernel enthaltenen Realtek-Treibers. Sie stellt sicher, dass L1 auf praktisch allen Realtek-Adaptern deaktiviert ist, anscheinend als Reaktion auf eine Reihe von Realtek-Adaptern, bei denen Stabilitätsprobleme auftreten, wenn diese niedrigen Energiezustände aktiviert sind. Auf meinem aktuellen Testsystem führt dies zu einer Leistungserhöhung von 4 Watt im Leerlauf, wenn der Bildschirm ausgeschaltet ist, da das System nicht mehr unter C3 abfällt.

Der Realtek-Treiber, der von Tseting verlinkt wurde, ist wahrscheinlich die einfachste Lösung für den Moment, obwohl ich keine Ahnung habe, wie er auf nicht unterstützten Kernel-Versionen funktioniert und ich persönlich kein großer Fan von Kernel-Modulen bin. Ich werde ihn der Einfachheit halber hier einfügen: https://www.realtek.com/en/component/zoo/category/network-interface-controllers-10-100-1000m-gigabit-ethernet-pci-express-software

Es gibt natürlich auch einen schwierigeren Workaround - für diejenigen, die mit der Kompilierung des Kernels vertraut sind, wird das Rückgängigmachen der Änderung im obigen diff L1/L1 wiederherstellen. 1 auf RTL8168h/8111h, RTL8107e, RTL8168ep/8111ep, RTL8168fp/RTL8117 und RTL8125A/B Geräten wiederherstellen (bei allen älteren Geräten war es bereits deaktiviert) - wenn Sie L1.2 zulassen wollen, können Sie rtl_aspm_is_safe() zwingen, true zurückzugeben, obwohl dies auf meinem Testsystem keinen Vorteil gegenüber L1.1 brachte.

Wenn die Kernel-Entwickler ihre Meinung nicht ändern, sieht es so aus, als ob Intel NICs die einzige brauchbare Option für die Zukunft sind. Intel 1G NICs haben sich im Allgemeinen als sehr solide erwiesen. Beunruhigenderweise habe ich festgestellt, dass die Deaktivierung der Realtek-NIC auf meinem MSI-Board diese nicht vollständig entfernt (sie bleibt immer noch bei C3 hängen), so dass der Kauf eines Boards mit einer Realtek-NIC mit dem Plan, diese zu deaktivieren und eine Intel-Netzwerkerweiterungskarte zu verwenden, riskant sein könnte. Es ist erwähnenswert, dass Hersteller auf einem 8125A/B-Adapter ein Flag setzen können, um anzuzeigen, dass L1.2 getestet und erlaubt ist, was der Linux-Kernel respektiert, aber ich weiß nicht, ob es in irgendwelche Motherboards oder Erweiterungskarten geschafft wurde.

danke für die ausführlichen geteilten Informationen.

Ihr Setup hat mich inspiriert und ich habe mir das "Prime h770-plus" inklusive 4800er DDR Ram zugelegt.

Leider habe auch ich Probleme mit NVME SSD's, wenn aspm im Bios aktiviert ist (und PCI express clock gating). Die Workarounds zum Blockieren bestimmter Stromsparmodi der WD's half leider nicht. Versucht wurden die SN750 (1tb) und die SN850X(2tb).

Können Sie die Crucial P3 weiterhin empfehlen oder steigt diese auch regeläßig mit Verweis auf ASPM Probleme aus?

Wer hat welche andere NVME an dem Board zuverlässig mit aktiviertem ASPM laufen?

Sie betreiben das Setup denk ich produktiv im Dauerbetrieb?

Zusätzlich habe ich festgestellt, dass eine 840pro (256gb) mindestens am SATA1 verhindert, dass das System tiefer als C3 geht. Eine Crusial Force GT (128GB) funktioniert hingegen bis C8.

Das Problem mit dem Realtek NIC habe ich durch Ausbau des Checks im Kernel umschifft.

Danke und viele Grüße

habe nun eine Samsung 990 pro ausprobiert. Leider führt das weiter zu den bereits bekannten nvme aspm Fehlern.

Hat noch jemand Ideen?

Am Netzteil kann das doch eigentlich nicht liegen (fänd ich sehr merkwürdig), weil hier voch ein Corsair cx 750 temporär verwendet wird.

Falls alles nichts hilft hätte jemand Eine gute Board Alternative?

Irgendwie trete ich was Hardware angeht leider zu oft ins Fettnäpfchen ;-(.

An sich ist es ein WIRKLICH effizientes nvme-Laufwerk für nur ein paar Dollar. Aber was es für unsere Zwecke so hervorragend macht, ist seine Fähigkeit, jede CPU mit ein paar Bios-Einstellungen auf c10 herunterlaufen zu lassen.

"Ich schätze, eine Menge Kopfschmerzen hätten vermieden werden können, wenn Sie ein Board mit mehr SATA-Anschlüssen gefunden hätten!"

Das stimmt so nicht ganz - denn es kommt darauf an, welcher SATA-Controller verwendet wird und/oder wie die Ports angeschlossen sind. Die Chancen sind hoch, dass ein Onboard-Controller verwendet wird, und speziell für das N5105 gibt es eine weithin bekannte NAS-Variante mit 6 SATA-Ports, die von Kingnovy und Topton vertrieben wird.

Die Schwarze verwendet JMS585 und die Grüne verwendet ASM1166 - die Schwarze ist auf C3 festgelegt und die Grüne kann bis zu C8 gehen (habe ich selbst überprüft, weil ich die grüne Variante habe). Wenn ich mehr als nur einen Backup-Server bräuchte, würde ich diesen Weg einschlagen - mit einem viel leistungsfähigeren Intel auf LGA1700.

Ein gutes Beispiel dafür, wie niedrig der Stromverbrauch im Leerlauf sein kann, ist das Odroid H3 - <2W im Leerlauf mit 2x HDDs über SATA in Spindown ... sobald man jedoch (die falschen) Komponenten hinzufügt, wird das schnell schneller gehen - siehe die Stromverbrauchsstatistiken hier:

https://github.com/fenio/ugly-nas

TLDR: Am Ende schluckt es mehr Strom als dein Build hier - und ich muss hinzufügen, dass ich zuvor ein Odroid H2 besaß, das die 5V-Lane durchbrannte und die (teuren) SSDs mit sich riss ... seitdem bleibe ich weg für das absolute Maximum des niedrigsten Stromverbrauchs in exotischen Kombinationen wie dem Odroid H3.

Ich würde sagen, am Ende kommt es darauf an, wie praktisch alles ist und wie hoch der Stromverbrauch ist.

Abgesehen davon bin ich von dieser Konstruktion hier beeindruckt - 7W im Leerlauf mit einem 750W-Netzteil ist schon was.

Ich bin gerade dabei, meinen Heimserver von j3455 auf 11400 zu aktualisieren.

Beim Wechsel der Hardware bin ich auf ein seltsames Problem gestoßen:

I5-11400+2x8Gb 2666 ddr4 +ASUS Prime B560M-A (letztes Bios) +asm1166.

Wenn ich von USB ohne angeschlossene SATA-Laufwerke boote, erreicht Paket C den Status c8.

Wenn ich von USB mit einem SATA-Laufwerk boote, das an den Onboard-SATA-Controller angeschlossen ist, erreicht der Status des Pakets C nur C2 (+4W).

Wenn ich von USB mit einem SATA-Laufwerk boote, das an einen pcie asm1166 angeschlossen ist, erreicht das Paket c status c8.

Mir scheint also, dass der b560 SATA-Controller Probleme mit dem Stromsparen hat. Selbst wenn ich L1 für alles aktiviert habe und powertop tune laufen lasse, geht er nicht unter c2.

Haben Sie eine Idee, woran es liegen könnte, dass der b560 SATA-Controller 4 W mehr verbraucht?

Am Ende könnte es auf lange Sicht billiger sein, einen weiteren ASM1166 anstelle des Onboard-Controllers einzubauen :D

Dies ist aktiviert, ich habe es auch mit deaktiviert versucht, aber es hat weder den Stromverbrauch noch die C-States verändert. (Ich lasse es vorerst aktiviert)

Im BIOS kann ich angeben, ob M.2_2 SATA oder PCIE verwendet. Laut BIOS und Handbuch ist SATA6G_2 nur blockiert, wenn M.2_2 auf SATA eingestellt ist.

Aber ich habe das ASM1166 in M.2_2 angeschlossen und als PCIE konfiguriert. Ich habe bestätigt, dass alle Onboard-SATA-Anschlüsse mit dieser Einstellung wie erwartet funktionieren.

Hotplug ist für alle Ports standardmäßig deaktiviert. Ich habe es aktiviert, um zu sehen, ob sich dadurch etwas ändert, aber das war nicht der Fall. Ich belasse es vorerst auf Deaktiviert.

Ich habe von USB gebootet und verschiedene Geräte ausprobiert: 2x SSDs (Emtec und ältere Samsung), 2x 3,5" HDDs (WD und Seagate) und sogar 1x LG DVD-Brenner.

Es scheint keine Rolle zu spielen, welche Art von Gerät angeschlossen ist.

Es ist immer das Gleiche, sobald ich ein Gerät über SATA anschließe, ist C2 maximal.

Um dies zu überprüfen, habe ich von einem USB-Stick mit angeschlossenen SATA-Geräten gebootet und dann alle Geräte während des Bootens abgesteckt.

Sobald das letzte SATA-Gerät physisch vom aktiven System getrennt wird, geht es sofort auf pc6 und kurz darauf auf pc8.

Wenn ich alle SATA-Geräte wieder anschließe, bleibt es in PC6/8, aber auch dmesg erkennt den Replug nicht (wahrscheinlich weil Hotplug deaktiviert ist)

Ich werde die dmesg-Bootprotokolle durchgehen, vielleicht taucht etwas Interessantes auf.

-m.2 Steckplatz des Mobos funktioniert (getestet mit m.2 ssd)

-sata controller funktioniert (getestet mit m.2-pcie adapter&x16 slot des mobo und m.2 slot eines anderen minipc)

Aber mit asm1166 an den m.2-Steckplatz angeschlossen, wird nichts im Bios oder lspci angezeigt.

Es sieht also so aus, als ob das Asrock Board ein Problem hat.

Ich weiß nicht, wie ich weiter vorgehen soll.

https://youtu.be/-DSTOUOhlc0?t=254

Eine Sache, die ich nicht verstehe: Wenn ich den Heimserver nicht nur als NAS, sondern auch als Router verwende, würde das verhindern, dass er im Leerlauf einen hohen Stromverbrauch hat, da er ja immer etwas arbeiten muss? Ich habe eine Gigabit-Verbindung und verwende derzeit openwrt auf einem pi4, aber mit aktiviertem qos erreiche ich die halbe Download-Geschwindigkeit.

Nochmals vielen Dank.

Was die Eignung als Router angeht, bin ich mir nicht sicher, obwohl ich hoffe, dass ich das in den nächsten Wochen ausprobieren kann. Momentan habe ich den alten ASRock/Intel J4005B-ITX, der OpenWRT als Router benutzt, aber das Limit des Motherboards ist C6 (obwohl er 88-92% der Zeit nach dem Powertop mit typischem Heimverkehr verbringt, einschließlich eines YouTube-Streams, den ich gerade getestet habe). Das Ding wird von einem meiner alten Antec-Netzteile mit Strom versorgt, und es liegt zuverlässig bei konstanten 10 Watt.