Commençons par un peu d’histoire :

- 2016: Construction d’un PC basse consommation sur Skylake – 10 watts en veille

- 2019: 9 watts en veille : création d’un NAS domestique à faible consommation d’énergie / serveur de fichiers avec 4 unités de stockage

- 2021: (pas d’écriture) – 11 watts avec un Intel i3-10320 sur un Gigabyte H470M DS3H

Tous mes systèmes n’ont pas connu le même succès. En 2022, j’ai mesuré quelques autres systèmes à 19 watts et 27 watts dans le cadre de l’étude Freiner les tendances au « Gas-Guzzling » de l’AMD Radeon avec le multi-moniteur . Bien que j’aie réussi à réduire la puissance de ce système AMD de 27 watts quelque temps plus tard, tous les combos CPU/carte mère ne sont pas destinés à atteindre les 10 watts.

—

Avant d’aller plus loin, le chiffre de 7 watts pour ce système était avant l’ajout de stockage. Les 7 watts (mesurés au mur) comprennent :

- Carte mère (Intel H770)

- Processeur (Intel i5-12400)

- 64 GO DE RAM

- SSD (démarrant Ubuntu Server 23.04)

- Bloc d’alimentation (Corsair)

- C-States configuré dans le BIOS pour atteindre C8

- powertop avec auto-tune (qui désactive le clavier USB lorsque le port se met en veille)

Notez que si je ne permets pas à powertop de désactiver le clavier, j’obtiens 8 watts mesurés au mur.

—

Entrons dans le détail des spécifications et des choix de composants. Cette fois-ci, j’avais les objectifs suivants:

- faible consommation au ralenti

- performances raisonnables du CPU pour la compression

- capacité à gérer 12 disques durs + au moins 1 NVMe

- capacité à convertir (éventuellement) ces 12 disques durs en 6 NVMe + 6 SSD SATA

- garder les coûts sous contrôle – puisqu’un achat de carte mère serait nécessaire, essayer de s’en tenir à la DDR4 et réutiliser un CPU que j’ai déjà.

Mettre en place un nouveau système avec l’espoir de se rapprocher des 10 watts *mesurés à partir du mur* est souvent non seulement un défi, mais aussi un peu un pari. Parfois, vous devez simplement prendre vos meilleures suppositions en termes de composants, construire votre système, régler ce que vous pouvez, et laisser les copeaux tomber où ils peuvent.

Carte mère – ASUS Prime H770-Plus D4

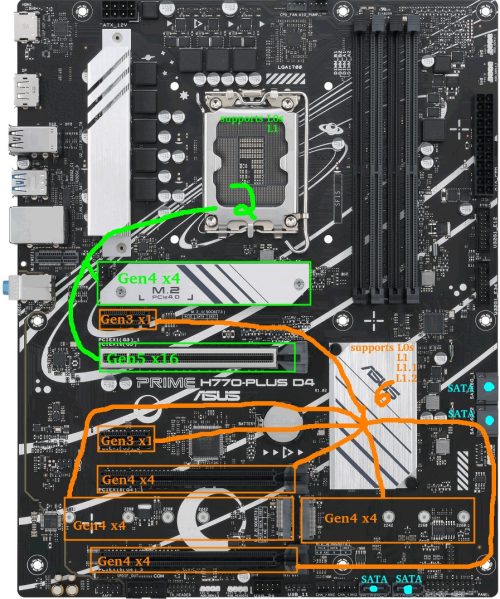

Avant de commencer, voici un aperçu de la disposition de la carte mère. Les slots VERT connectés au CPU et les slots ORANGE connectés au chipset deviendront pertinents tout au long de cet article.

Au moment de la rédaction de cet article, les options grand public largement disponibles étaient les cartes mères des séries Intel 600/700 et AMD 500/600.

L’un de mes objectifs était de pouvoir accueillir 6 disques NVMe.

Nous allons voir plus en détail pourquoi cela peut être un défi (n’hésitez pas à sauter cette section)…

Problème : Il n’existe aucune carte mère grand public dotée de 6x emplacements M.2 pouvant être utilisés simultanément en mode PCIe. Chez AMD, la MEG X570S Unify-X Max en a l’air, mais vérifiez le manuel et vous verrez que si vous essayez de remplir les 6 emplacements, le dernier doit être une variante SATA. Le Z790 PG Sonic d’ASRock dispose également de 6 slots, mais vous ne pouvez en utiliser que 5 (avec une excuse légitime : ils proposent un slot NVMe Gen5, mais il est accompagné d’une clause restrictive).

Pourquoi ce problème existe-t-il? : Il y a des limitations de voies de chipset sur les cartes grand public. En supposant que je veuille pouvoir utiliser tous les M.2 en Gen4x4 et qu’un fabricant soit réellement disposé à consacrer toutes les voies aux emplacements M.2 NVMe (ce n’est pas le cas), l’AMD X570 et l’Intel B760 ne dépasseraient pas trois emplacements M.2, l’AMD B650 et l’Intel H670/Q670/Z690/W680 en gèreraient quatre. Cinq emplacements M.2 sont possibles sur les cartes AMD X670 et Intel H770. Six sur une carte Z790. Au-delà, il faudrait prendre des mesures extraordinaires, par exemple en privant de voies l’emplacement PCIE principal. Si le nombre de M.2 était souhaité, les fabricants pourraient théoriquement utiliser des voies en Gen4x2 ou ajouter des emplacements M.2 Gen3, mais à ce stade, ils ont créé un produit *très* de niche.

La solution : Les adaptateurs PCI-E vers M.2 sont devenus nécessaires. Désormais, lors de la recherche d’une carte mère, il s’agissait d’ajouter les emplacements M.2 inclus à tous les emplacements PCI-E disponibles capables de x4 ou plus. Mes options se limitaient alors aux cartes mères AMD X570, Intel H770 et Intel Z790. Notez que bien que l’utilisation de la bifurcation soit possible sur certaines cartes mères pour obtenir plus d’un NVMe sur l’emplacement PCIe principal, j’ai décidé de ne pas m’y fier.

J’ai décidé d’opter pour Intel pour plusieurs raisons :

- TDP du chipset : les chipsets Intel des séries 600/700 ont tous un TDP de 6W, alors que le TDP du chipset AMD X670 est assez élevé (7w+7w). La consommation d’énergie des chipsets AMD me préoccupe depuis un certain temps, car les chipsets X570 précédents avaient un TDP de 11w et nécessitaient un ventilateur.

- Vitesse du chipset : Les chipsets Intel H670/Q670/W680/Z690/H770/Z790 ont un lien DMI 4.0 x8 avec le CPU. Les chipsets AMD X570/B650/X670 ont une liaison PCIe 4.0 x4 avec le processeur. Le débit théorique d’Intel devrait être deux fois plus élevé que celui d’AMD (16GB/s contre 8GB/s).

- J’avais déjà 64 Go de DDR4 que le système Intel pouvait utiliser. Les chipsets AMD de la série 600 n’utilisent que de la DDR5.

- J’avais déjà un processeur Intel 12ème génération.

- Je n’ai pas encore vu de discussion positive sur la consommation d’énergie de l’AM5. Pas du tout. Mise à jour : au moment où j’écrivais ces lignes, des informations ont été publiées sur des CPU de la série 7000 d’AMD qui brûlaient à l’endroit où les broches du socket de la carte mère rejoignaient le CPU. Oui, désolé AMD, pas cette fois.

C’est donc Intel qui a été choisi. Après avoir vérifié les cartes mères DDR4 disponibles sur le marché, j’ai rapidement réduit les options à 2 fabricants : MSI et ASUS.

Vous ne vous souciez pas des comparaisons entre les tableaux ? N’hésitez pas à passer votre chemin.

Les cartes MSI les plus intéressantes sont les PRO Z790-P WIFI DDR4 et Z790-A WIFI DDR4. Presque identiques en apparence, sauf que le « A » est un peu plus haut de gamme (audio, ports arrière, dissipateurs, phases d’alimentation, etc). Avantages/inconvénients :

- Pro : 4x M.2 (Gen4x4) + 1x PCIE Gen5x16 + 1x PCIE Gen4x4 supporte un total de 6 Gen4 NVMe

- Pro : 2x PCIE Gen3x1 supplémentaires

- Pro : 6 ports SATA

- Inconvénient : Intel 2.5G LAN (connu pour être problématique et bogué)

- Inconvénient : je ne suis pas un fan du BIOS MSI

- Inconvénient : ma carte B660 actuelle, qui consomme plus que prévu au ralenti, est une MSI.

Les options ASUS intéressantes étaient le Prime H770-Plus D4 et le Prime Z790-P D4 (édition WIFI en option). Les TUF, Strix, ou ProArt étaient tout simplement trop chers.

Je vais commencer par lister les avantages et inconvénients du H770-Plus :

- Pro : 3x M.2 (Gen4x4) + 1x PCIE Gen5x16 + 2x PCIE Gen4x4 supporte un total de 6 NVMe Gen4

- Pro : 2 PCIE Gen3x1 supplémentaires

- Inconvénient : seulement 4 ports SATA

Pro : Adaptateur réseau Realtek 2.5G (préférable au LAN Intel 2.5G de nos jours)(voir commentaires)Le Z790-P D4 est similaire sauf qu’il a plus de phases d’alimentation, un meilleur dissipateur thermique, plus de ports USB, une tête de ventilateur supplémentaire, et pour nos besoins… :

- +1 PCIE Gen4x4

- -1 PCIE Gen3x1

Finalement, le ASUS Prime H770-Plus D4 était 100$ moins cher à l’époque et c’est ce que j’ai choisi.

Un avantage que j’ai trouvé avec les cartes « moins chères » est qu’elles ont tendance à avoir moins de composants et donc moins de consommation d’énergie vampire au ralenti, bien que ce ne soit pas toujours une certitude.

CPU – Intel i5-12400 (H0 stepping) – Alder Lake

J’avais déjà ce processeur dans le cadre d’une précédente construction d’ordinateur de bureau. À l’époque, il avait été choisi pour le système de bureau pour les raisons suivantes :

- il avait le décodage matériel AV1

- il avait la plus haute performance disponible de la gamme Intel de la 12ème génération qui évite l’overhead du silicium E-core

- dans cette configuration, j’allais recevoir une nouvelle carte mère avec 2xDP de toute façon, et choisir une génération plus ancienne n’avait pas de sens pour moi.

Cet ordinateur de bureau s’est avéré être une déception, et se classe parmi mes constructions préférées.

Quelques détails…

J’ai eu des problèmes où parfois seulement 1 des 2 moniteurs DP connectés se réveillait sous Linux, ce qui signifiait que je devais soit retirer/reconnecter l’autre connecteur DP, soit suspendre/reprendre manuellement le système pour qu’il puisse réessayer.

Un autre problème était que le redémarrage entre Windows/Linux provoquait parfois des problèmes étranges qui nécessitaient une extinction/redémarrage complet.

Le décodage matériel sous Ubuntu à l’aide de Wayland est toujours problématique et lorsque des programmes essayaient de l’utiliser pour lire des vidéos, des problèmes survenaient.

Enfin, contrairement à mes systèmes Intel précédents qui pouvaient tous être ramenés à près de 10 watts, celui-ci tournait au ralenti à 19 watts, bien que je soupçonne la carte mère MSI que j’utilisais d’avoir joué un rôle.

La plupart des maux de tête que j’ai rencontrés étaient liés au GPU et à l’affichage. Comme j’étais sur le point de construire quelque chose d’orienté serveur, ce n’était plus un facteur.

MÉMOIRE – 64GB DDR4-3200

Voici ce que j’ai utilisé :

- 2x16GB Kingston HyperX dual-rank (Hynix DJR)

- 2x16GB Kingston HyperX single-rank (Hynix CJR)

C’est de la mémoire que j’avais déjà. J’ai fait fonctionner les 4 barrettes de mémoire au profil XMP du kit dual-rank, soit 16-18-18-36. Tout le reste a été laissé aux valeurs par défaut, sauf que j’ai fait fonctionner la RAM à 1,25 volt (plus élevé que le 1,20 du stock, mais plus bas que le réglage XMP de 1,35v). TestMem5 et Memtest86 ont montré une stabilité à 1,22v, bien que les tests de cette mémoire sur les cartes mères précédentes aient montré que 1,22v était instable, donc pour un peu plus de stabilité, j’ai augmenté la tension à 1,25v.

Disque de démarrage – Sandisk Ultra 3D 1TB SSD

TCe composant n’a pas été choisi délibérément. Lorsque j’ai voulu installer un serveur Ubuntu frais pour les tests, il s’est avéré que c’était le seul disque SSD que j’avais à portée de main et qui n’était pas utilisé. J’allais faire beaucoup de tests A/B sur des périphériques PCIE et NVMe, donc installer Ubuntu 23.04 sur un SSD SATA était logique pour garder les slots PCIE libres.

Notez qu’après les tests, le système d’exploitation principal devait être exécuté sur un Samsung SSD 970 EVO Plus 500GB NVMe. Il n’y a pas grand-chose à dire, si ce n’est que les produits Samsung ont tendance à se mettre en mode basse consommation de manière fiable.

Ayant utilisé les deux disques, je n’ai pu mesurer aucune différence de puissance entre eux lors de mes tests. Tom’s Hardware a testé le Samsung en mode ralenti à 0,072 watts (via ASPM/APST), et Anandtech a testé le Sandisk Ultra 3D en mode ralenti à 0,056 watts (via ALPM). Les deux sont bien en dessous de la résolution de 1W de mon compteur Kill-A-Watt.

Bloc d’alimentation – Corsair RM750

Même si ce bloc d’alimentation de 750W peut sembler excessif pour un système destiné à tourner autour de 10 watts, lorsque 12 moteurs de disques tournent en même temps, la charge instantanée est susceptible d’être assez élevée. Seagate indique des courants de pointe de 2A/3A DC/AC sur le rail 12V pour l’un de ses disques 3,5″ de 10 To. Même les lectures/écritures aléatoires de pointe peuvent atteindre plus de 2A.

Cette demande de puissance en rafale peut être problématique si le bloc d’alimentation n’est pas à la hauteur de la tâche. Si une matrice de 6 disques durs consomme collectivement 150-200 watts au moment même où le CPU atteint un pic de 120 watts, on passe d’une dizaine de watts au repos à environ 400 watts. Cela peut facilement provoquer une chute de tension instantanée – si elle est suffisante pour provoquer un plantage/redémarrage immédiat, ce n’est probablement pas grave, mais si elle est suffisante pour corrompre les données lors d’un rafraîchissement de la mémoire ou lorsqu’un autre disque est en cours d’écriture… c’est un problème plus douloureux. Surdimensionner le bloc d’alimentation dans une certaine mesure (ou ajouter des condensateurs en ligne sur les rails d’alimentation) est logique.

Heureusement, bien que fonctionnant en dehors de la plage d’efficacité maximale, la plupart des Corsair RM sont assez efficaces sur une large plage.

Mesures de puissance – Initiales

Quelques éléments importants :

- Puissance mesurée à partir du mur

- Intel PowerTOP a été utilisé pour l’auto-ajustement des paramètres

- Serveur Ubuntu 23.04

Quelques éléments du BIOS potentiellement importants :

- Les états C du CPU ont été activés dans le BIOS (C10)

- ASPM a été activé avec tout réglé sur L1

- RC6 (Render Standby) activé

- Support LPM agressif activé (ALPM)

- DISABLED : HD Audio, Connectivity Mode, LEDs, GNA Device, Serial Port

9-10 watts était la consommation lorsque l’écran était allumé.

7 watts était la consommation une fois l’écran éteint (consoleblank=600 paramètre de démarrage du noyau pour une temporisation de 600s), ce qui est le cas de ce système la majeure partie de la semaine.

8 watts était la consommation si la gestion de l’alimentation du clavier USB était désactivée. Si vous ne vous connectez pas au serveur par SSH depuis un autre endroit, il peut être nécessaire de dépenser le watt supplémentaire pour l’utilisation du clavier.

Mesures de puissance problématiques – Chargé avec de la rouille qui tourne (qui ne tourne pas)

Comme indiqué au début, j’ai commencé avec 12 disques durs. La moitié était de 2,5″ et l’autre de 3,5″. La carte mère ne disposant que de 4 ports SATA, un contrôleur SATA et un multiplicateur de port ont été utilisés pour gérer les disques restants. De plus, 4 disques NVMe ont été utilisés au début : l’un d’entre eux, un Western Digital SN770, avait tendance à chauffer même au ralenti, ce qui indique qu’il ne passait probablement pas en mode basse consommation.

Avec tout l’équipement connecté, au ralenti, avec l’écran éteint, et avec les 12 disques en veille, j’ai été choqué de voir que ma consommation d’énergie au ralenti était passée de 7 watts à 24-25 watts. C’est beaucoup trop ! Quelque chose ne tournait pas rond.

Casse-tête de la consommation d’énergie – Investigation et diagnostic de la haute puissance

J’ai déconnecté les disques durs et j’ai commencé à tester les composants un par un. Il s’agissait de tests assez rudimentaires destinés à se faire une idée approximative du coupable, de sorte que les chiffres indiqués ici ne sont pas précis.

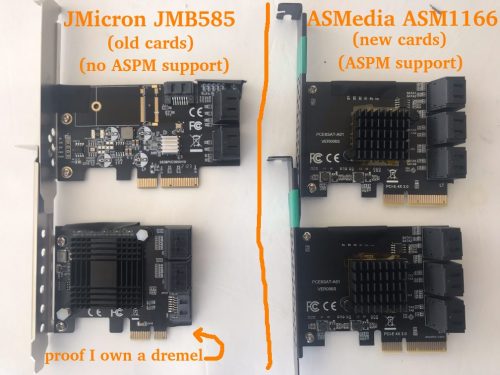

J’ai rapidement découvert que le contrôleur SATA JMB585 que j’utilisais provoquait une augmentation de la consommation d’énergie de l’ordre de 6 à 10 watts (les mesures précises sont présentées dans une section ultérieure). Le contrôleur lui-même n’est censé consommer que quelques watts, et le minuscule dissipateur thermique est resté froid, mais il est évident qu’il se passait plus de choses. Où allait la puissance ?

J’ai décidé d’observer les états C du paquet CPU. Sans le contrôleur SATA JMB585, le système a atteint C6. Lorsque le JMB585 a été reconnecté, le système a atteint au mieux C3. Ah ha ! mais pourquoi ? Il s’avère que si un périphérique connecté au PCIE ne passe pas en ASPM L1, le CPU ne passe pas en sommeil aussi profond. Les cartes contrôleur JMB585 ne semblent pas supporter l’ASPM.

Un peu plus d’expérimentation a révélé quelque chose d’autre que je ne savais pas, et cela a à voir avec C6 vs C8. Le système n’atteindra C8 que si rien n’est branché sur les voies PCIE connectées au processeur. En d’autres termes, si quoi que ce soit est branché sur l’emplacement PCIE supérieur ou sur l’emplacement NVMe supérieur, C6 est le maximum. La différence de consommation d’énergie entre C6 et C8 *a semblé* être inférieure à un watt lors d’un simple test.

Ainsi, alors que C8 serait un luxe, atteindre C6 était une nécessité. C3 consomme trop d’énergie. Si les contrôleurs SATA allaient empêcher le CPU d’atteindre les meilleurs états d’économie d’énergie, j’ai commencé à me demander si je n’aurais pas dû chercher une carte mère avec 6-8 ports SATA afin de ne pas avoir à compter sur des contrôleurs supplémentaires…

Une petite recherche sur les HBAs SATA a montré que bien qu’il n’y ait pas beaucoup d’options ici, le contrôleur SATA ASM1166 devrait supporter ASPM L1, bien que le firmware doive être flashé pour qu’il fonctionne correctement (et pour qu’il fonctionne du tout sur les cartes Intel plus récentes). C’est quelque chose que je devais commander : J’ai des pièces de rechange Marvel et JMicron, mais elles ne supportent pas l’ASPM. En fait, j’ai évité ASMedia pendant des années, mais par nécessité, ils avaient maintenant une nouvelle chance : J’ai commandé deux contrôleurs ASM1166 6 ports SATA.

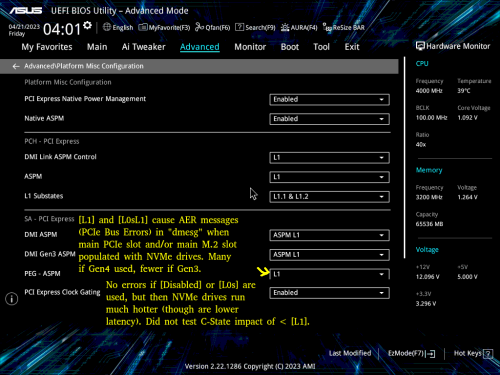

A côté : BadTLP, Bad ! Erreurs de bus AER sur le pcieport

Cela vaut la peine d’être mentionné… Lors des tests initiaux avec un WD Black SN770 (Gen4 NVMe), j’ai constaté un problème lorsque les ports PCIE et NVMe primaires (attachés au processeur supérieur) étaient utilisés. En exécutant dmesg, j’ai obtenu une sortie contenant des éléments tels que :

pcieport 0000:00:06.0: AER: Corrected error received: 0000:02:00.0

nvme 0000:02:00.0: PCIe Bus Error: severity=Corrected, type=Physical Layer, (Receiver ID)

pcieport 0000:00:06.0: PCIe Bus Error: severity=Corrected, type=Data Link Layer, (Transmitter ID)

pcieport 0000:00:06.0: AER: Error of this Agent is reported first

nvme 0000:02:00.0: [ 6] BadTLP

…après de nombreux essais et erreurs, j’ai découvert que si le paramètre « PEG – ASPM » du BIOS était réglé sur [Disabled] ou [L0s], il n’y avait pas d’erreurs.

Bien sûr, il s’agit d’une mauvaise option, car [L1] est crucial pour les économies d’énergie. Si [L1] ou [L0sL1] étaient utilisés, la seule option était de régler la vitesse de liaison de ces ports sur [Gen3], ce qui n’a pas empêché les erreurs, mais les a considérablement réduites.

Des recherches ont montré que l’origine de ces erreurs pouvait être multiple. Comme le remplacement de la carte mère ou du CPU n’était pas une idée agréable, mon meilleur espoir était de changer de marque de NVMe.

J’ai commandé des disques Crucial P3 NVMe. Cette démarche s’est avérée fructueuse : une fois les disques WD remplacés par les disques Crucial, je n’ai plus eu d’erreurs, même s’il ne faut pas oublier qu’il s’agit de disques Gen3.

Casse-tête sur la consommation d’énergie – L1.1 et L1.2 activés uniquement sur les ports connectés au chipset

Lorsque j’ai installé les 2 disques Crucial P3 NVMe dans l’emplacement PCIEx16 connecté au CPU et dans l’emplacement M2 supérieur, j’ai remarqué des températures de ralenti plus élevées que prévu. Alors que la NAND était à environ 27-29C, les contrôleurs indiquaient 49-50C – beaucoup plus élevé que ce à quoi je m’attendais pour ces disques particuliers.

J’ai déplacé celui de l’emplacement PCIEx16 vers un emplacement PCIEx4 connecté au chipset. Une différence intéressante entre ces disques est apparue via lspci -vvv :

Emplacement M2 connecté au processeur : L1SubCtl1: PCI-PM_L1.2- PCI-PM_L1.1- ASPM_L1.2- ASPM_L1.1-

Emplacement PCIE connecté au chipset : L1SubCtl1: PCI-PM_L1.2+ PCI-PM_L1.1+ ASPM_L1.2+ ASPM_L1.1+

Les sous-états L1 ne semblent être activés que sur les slots connectés au chipset. C’est regrettable, mais cela semble coïncider avec les paramètres BIOS disponibles dans la capture d’écran ci-dessus.

Reprenons l’image de la carte mère pour illustrer la situation :

J’ai placé les deux disques NVMe sur des emplacements PCIE connectés au chipset. Les deux disques affichent L1.1+/L1.2+ et la température des deux contrôleurs est passée de 49-50C à 38-41C.

Malheureusement, lorsque j’ai tenté divers tests A/B en utilisant ces deux disques NVMe Crucial avec différentes configurations d’emplacement et divers paramètres BIOS, j’ai constaté un comportement très incohérent en termes de température, bien qu’il soit intéressant de noter que le JMB585 et un disque de démarrage NVMe étaient également connectés pendant ces tests. Par exemple, les deux disques pouvaient tourner au ralenti à environ 40°C jusqu’à un redémarrage progressif, moment où l’un d’entre eux (ou les deux) pouvait maintenant tourner au ralenti à 50°C. Parfois, il semblait possible de garder un disque sur le M.2 connecté au processeur et de conserver des températures de 40°C sur les deux disques tant que l’emplacement x16 n’était pas occupé. Il est probable que j’ai rencontré une sorte de bug. Le Samsung boot NVMe semblait maintenir une température constante au repos indépendamment de ce qui se passait avec les disques Crucial NVMe, j’ai donc soupçonné les disques Crucial d’être au moins en partie responsables.

Il est intéressant de noter que la température de l’un des contrôleurs (ou des deux) descendait parfois jusqu’à 29°C sur les slots connectés au chipset. Étant donné qu’il n’était pas réaliste d’essayer de trouver un remplaçant NVMe de 4 To à faible consommation pour le Crucial P3, mon meilleur espoir à ce stade était que le JMicron JMB 585 incompatible avec l’ASPM était en quelque sorte à blâmer, puisqu’il allait bientôt être remplacé par l’ASMedia ASM 1166 compatible avec l’ASPM.

Mise à jour tardive : je n’ai malheureusement pas suivi les températures pendant le reste des tests, et les dissipateurs/flux d’air entre les disques ont été mélangés. Mais pour ce que ça vaut, dans la version finale, les températures de mon contrôleur Crucial P3 sont de 31-34C, et les températures NAND sont de 23-24C.

Puzzle sur la consommation d’énergie – Passage du JMB585 à l’ASM1166.

Après quelques semaines, l’ASM1166 est arrivé. Tout d’abord, quelques informations sur la carte qui pourraient vous être utiles si vous envisagez de l’utiliser…

J’ai commencé par un flash du firmware – les cartes ASM1166 ont souvent un vieux firmware qui ne fonctionne pas avec les cartes mères Intel de la série 600 et qui, d’après ce que j’ai compris, peut avoir des problèmes avec la gestion de l’énergie. Un firmware plus récent peut être trouvé à différents endroits, mais j’ai décidé de prendre une copie de SilverStone (« fix compatibility issue » dans la section Download de https://www.silverstonetek.com/en/product/info/expansion-cards/ECS06/) et j’ai suivi les instructions sur https://docs.phil-barker.com/posts/upgrading-ASM1166-firmware-for-unraid/ . Notez que les fichiers SilverStone avaient un MD5 identique au firmware que j’ai trouvé en suivant le fil de discussion à https://forums.unraid.net/topic/102010-recommended-controllers-for-unraid/page/8/#comment-1185707 .

Pour tous ceux qui prévoient d’acheter l’une de ces cartes ASMedia, je dois noter que, comme la plupart des contrôleurs SATA et des HBA, la qualité varie vraiment. L’une de mes cartes avait un dissipateur thermique qui était un peu de travers : le coussin thermique était suffisamment épais pour l’empêcher de court-circuiter les composants voisins, mais soyez conscient que ces produits peuvent être vraiment aléatoires. C’est l’une des situations où il peut être prudent de payer un peu plus cher pour acheter un produit auprès d’un fournisseur offrant une bonne politique de retour.

J’ai fait pas mal de tests A/B, voici donc un rapide « JMicron JMB585 vs ASMedia ASM1166 » en termes de consommation totale du système, bien qu’il ne puisse s’appliquer qu’à cette plateforme (ou peut-être même à cette carte mère spécifique).

SANS DRIVE

Tout d’abord, la consommation d’énergie sans aucun disque connecté aux cartes (le disque SSD SATA de démarrage est connecté à la carte mère) pour obtenir une base de référence. PowerTOP est utilisé sur tous les périphériques à l’exception du clavier (ajoutant +1 watt). Mesures après la mise en veille de l’écran.

- 8 watts – Pas de contrôleur SATA – état d’alimentation C8

- 9 watts – ASM1166 sur un emplacement x4 connecté au chipset – état d’alimentation C8

- 12 watts – JMB585 sur un emplacement x16 connecté au processeur – état d’alimentation C3

- 15 watts – JMB585 sur un emplacement x4 connecté au chipset – état d’alimentation C3

- 22 watts – ASM1166 sur un emplacement x16 connecté au processeur – état de puissance C2

L’ASM1166 s’en sort bien si elle est branchée sur un slot connecté au chipset (seulement +1 watt), mais elle s’en sort très mal si elle est connectée au slot PCI-E principal (+14 watts) où l’état d’alimentation du package CPU chute à C2. Chose étonnante, le JMB585 se comporte de manière opposée : sa consommation est plus faible sur le slot connecté au CPU (et il n’a pas provoqué de C2) – cependant, vous verrez bientôt que les choses changent lorsque les disques sont réellement connectés…

J’ai effectué d’autres tests avec les contrôleurs, notamment en jouant aux « chaises musicales » avec quelques disques NVMe pour voir si la présence de plusieurs périphériques pouvait perturber les choses, mais rien d’inattendu ne s’est produit, donc je ne vais pas entrer dans les détails.

LORSQUE LES DISQUES DURS SONT INSTALLÉS

Les mesures de base étant terminées, il était temps d’installer des disques sur ces contrôleurs. Le disque SSD SATA de démarrage est resté sur la carte mère, 2 disques NVMe ont été ajoutés au mélange (connectés au chipset sauf indication contraire), et 4 des disques durs SATA 2,5″ ont été placés sur le contrôleur. Je vais énumérer la consommation après que les disques durs ont été mis en veille – la consommation après la mise en veille était exactement 2 watts plus élevée dans chaque test alors que les disques étaient inactifs.

- 10 watts – ASM1166 sur un emplacement x4 connecté au chipset – état d’alimentation C8

- 11 watts – ASM1166 sur un emplacement x4 connecté au chipset avec 1 NVMe déplacé vers l’emplacement x16 connecté au CPU – état d’alimentation C6

- 11 watts – 2 ASM1166 sur des emplacements x4 connectés au chipset, avec seulement 1 lecteur NVMe – état d’alimentation C8

- 16 watts – JMB585 sur un emplacement x4 connecté à un chipset – état de puissance C3

- 24 watts – JMB585 sur un emplacement x16 connecté au CPU – état d’alimentation C2

Avec 4 disques connectés via un emplacement connecté au chipset, l’ASM1166 ajoute +2 watts à la consommation du système, tandis que le JMB585 ajoute +8 watts. Il n’y a pas photo.

Un autre avantage est que j’ai pu utiliser les deux cartes ASM1166 dans le système, alors qu’en essayant d’utiliser les deux cartes JMB575 en même temps, le système a refusé de démarrer, bien que cela puisse être un problème spécifique à la plateforme ou à la carte mère.

Il y a cependant un compromis à faire – j’ai toujours trouvé que la JMB585 était d’une fiabilité à toute épreuve, y compris lorsqu’elle était associée à un multiplicateur de port JMB575. Mon expérience passée avec les contrôleurs SATA ASMedia n’a pas été brillante : la fiabilité de l’ASM1166 reste à voir, mais c’est au moins un mauvais candidat pour un multiplicateur de port puisqu’il ne supporte pas le FBS (seulement le CBS).

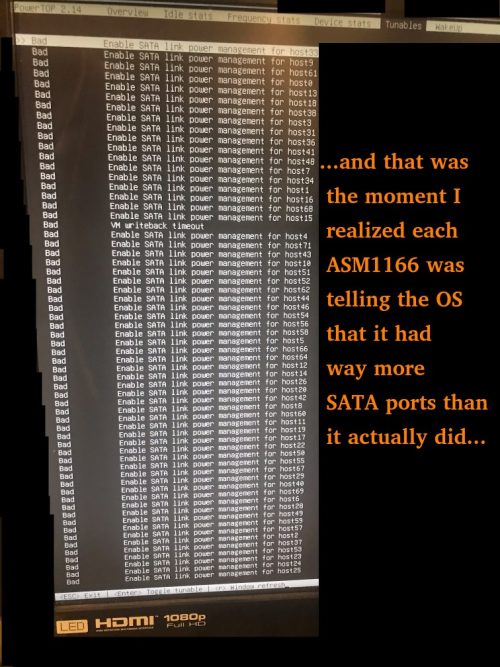

Quelques autres problèmes mineurs qui se sont présentés avec l’ASM1166 :

- Lors du retrait/réinsertion du disque de démarrage NVMe, un message BIOS est apparu indiquant qu’il ne pouvait pas démarrer en raison d’une corruption GPT. Les cartes ASM1166 ont dû être temporairement retirées pour que le BIOS « trouve » à nouveau le lecteur de démarrage NVMe (après quoi elles ont pu être réinstallées).

- Les cartes ASM1166 prétendent avoir un *nombre* de ports – cela augmente le temps de démarrage car Linux doit les parcourir tous.

Mise à jour : SATA et marques de SSD

L’un des commentaires mentionnait qu’un ancien SSD Samsung 840 PRO était limité à C3 alors qu’un SSD Crucial Force GT était autorisé à C8. Bien qu’il s’agisse de disques plus anciens, j’ai trouvé cela un peu surprenant. Cela valait la peine d’enquêter.

J’ai utilisé le H770 comme banc d’essai avec un disque de démarrage Samsung 850 EVO SATA SSD ainsi qu’un Crucial P3 NVMe et j’ai construit un noyau personnalisé pour permettre à l’adaptateur réseau Realtek d’atteindre L1.2. Pas d’ASM1166, juste l’utilisation de l’Intel onboard SATA. J’ai atteint C10 après avoir exécuté powertop avec auto-tune et permis à l’écran de se mettre en veille. J’ai essayé différents disques que j’avais sous la main, en éteignant le système à chaque fois pour échanger les disques et répéter le processus. Voici les résultats.

Les disques qui ont bloqué le système en C6 :

- 1To SSD Patriot P210 SATA

Les disques qui ont permis au système d’atteindre le niveau C10 :

- 500Go Samsung 850 EVO SATA SSD

- 4To 2.5″ Seagate SATA HDD

- 8To 3.5″ Seagate SATA HDD

- 14To de disque dur Toshiba SATA

- 1To Sandisk Ultra 3D SATA SSD

- 4To Sandisk Ultra 3D SATA SSD (note : lenteur de la découpe)

- 4To Crucial MX500

Je suggère d’être prudent dans le choix des disques SSD SATA. J’essaierai de mettre à jour cette liste avec les disques que j’ai testés, mais gardez à l’esprit que certains fabricants d’espace de stockage ont une propension à remplacer silencieusement les produits principaux par des composants de qualité inférieure, vous devriez donc toujours vérifier les performances des périphériques de stockage que vous achetez pendant la période de retour. N’hésitez pas à laisser un commentaire sur les bons et les mauvais produits que vous avez rencontrés.

Puzzles sur la consommation d’énergie – Conclusion

Quelques points importants si l’on vise une faible consommation :

1) Le support de la carte mère et la configuration du BIOS sont critiques – j’ai eu des cartes mères avec des BIOS très inflexibles. Sur celle-ci, « Native ASPM » et les états L1 appropriés doivent être activés (pour permettre un contrôle par le système d’exploitation au lieu d’un contrôle par le BIOS) pour que la faible consommation d’énergie fonctionne.

2) Les périphériques doivent tous prendre en charge l’ASPM L1. Sinon, c’est un véritable coup de dés. La partie la plus difficile est de trouver des contrôleurs SATA qui le supportent – si possible, prenez une carte mère avec suffisamment de ports SATA connectés au chipset Intel pour éviter d’avoir besoin d’une carte séparée. Je dois noter qu’il n’est pas toujours facile de trouver des disques NVMe qui ont des états d’alimentation APST à faible consommation sous ASPM et vous devrez faire quelques recherches à ce sujet également.

3) Si vous pouvez atteindre l’état d’alimentation C8, évitez d’utiliser les voies PCIe connectées au CPU (PCIe supérieur et slot M2). Sur cette carte mère spécifique, mon conseil serait de ne pas les utiliser du tout si vous le pouvez, à moins que vous n’ayez besoin d’une bande passante complète à faible latence vers le CPU ou que vos périphériques soient si actifs qu’ils ne dorment jamais de toute façon. Rappelez-vous que mes deux cartes SATA JMicron et ASMedia ont fait chuter l’état C du CPU à C2 si elles étaient branchées dans l’emplacement PCI-E x16.

4) Mesurer la puissance à partir du mur est le seul moyen de s’assurer que ce que vous *pensez* être en train de se produire est réellement en train de se produire. Un appareil Kill-A-Watt s’amortit au fil du temps si vous l’utilisez – sachez que j’ai acheté le mien en 2006 (16 $USD + 14 $USD de frais de port à l’époque sur eBay). À l’époque, j’ai constaté que notre télécopieur, rarement utilisé et toujours allumé, consommait 7 watts… le simple fait de maintenir cet appareil éteint lorsqu’il n’est pas utilisé pendant les 10 années suivantes a largement suffi à payer le Kill-A-Watt.

Consommation électrique avec plusieurs disques durs

Maintenant que diverses pièces sont entrées et sorties du système tout au long de ce processus, la configuration actuelle est la suivante :

- 1x Samsung 970 EVO Plus NVMe (disque de démarrage de 500 Go)

- 2x Crucial P3 NVMe (4TB chacun)

- 5x Seagate 2.5″ HDD (5TB chacun – 4TB utilisé)

- 6x disques durs Seagate 3.5″ (10 To chacun – 8 To utilisés)

- 2x cartes ASM1166 fournissant des ports SATA

Puissance totale mesurée à partir du mur (écran allumé, clavier activé) :

- 50 watts avec les 11 disques durs en veille active

- 38 watts avec les 6 disques durs de 3,5 pouces en Idle_B

- 34 watts avec les 6 disques durs de 3,5 pouces en Idle_C

- 21 watts avec les 6 disques durs de 3,5 pouces en Standby_Z (essorage)

- 18 watts avec le disque dur 5x 2,5″ AUSSI en veille

- 16 watts avec la sortie d’affichage AUSSI éteinte

- 15 watts lorsque PowerTOP est autorisé à désactiver le clavier USB

Seagate estime la consommation en veille de ces disques de 3,5″ à environ 0,8w chacun, et celle des disques de 2,5″ à environ 0,18w chacun. Cela correspond à ce que je vois ci-dessus. Mes chiffres de consommation en veille active correspondent en fait assez bien aux spécifications de Seagate.

L’observation qui s’impose : par rapport au reste des composants du système, les disques durs de 3,5 pouces sont des monstres gourmands en énergie.

Les disques durs seront éventuellement remplacés par des disques SSD. Avec une consommation en veille aussi faible que celle des disques durs, il n’y a pas d’urgence majeure et ce processus se fera progressivement au fur et à mesure que mes disques durs/spares mourront et que les prix des disques SSD diminueront.

Le plan pour le « jeu final » est de construire un système entièrement basé sur des SSD. A l’origine, le plan prévoyait 1 disque de démarrage, 6xNVMe (probablement Crucial P3 4TB) pour une matrice RAIDZ2, et 6xSATA (probablement Samsung 870 QVO 8TB) pour la seconde matrice RAIDZ2. Comme l’utilisation des slots M2/PCIe connectés au CPU n’apporte pas seulement de l’imprévisibilité mais aussi un léger coût en termes d’état, de puissance et de température, je pourrais modifier ce plan et abandonner quelques NVMe dans la première matrice et utiliser SATA à la place afin de ne pas avoir à toucher aux lanes connectées au CPU. L’avenir nous le dira.

Détails inutiles sur le stockage

Cette partie ne vaut la peine d’être lue que si vous êtes intéressé par des détails méticuleux sur le stockage. Dans le cas contraire, n’hésitez pas à passer à la dernière section.

Lecteur de démarrage NVMe

Comme nous l’avons déjà mentionné, il s’agit d’un Samsung 970 EVO Plus. Actuellement, moins de 4 Go des 500 Go d’espace sont utilisés (une partition d’échange de 64 Go existe mais reste toujours à 0 utilisé). Ce disque a été choisi à l’origine parce que Samsung avait acquis une réputation de fiabilité (qui s’est affaiblie ces derniers temps), et Samsung a également obtenu de bons résultats dans les revues chaque fois qu’il s’agissait de la consommation d’énergie en mode inactif. Ce disque est presque toujours en veille et les températures du contrôleur et de la NAND sont restées basses tout au long des tests (20-24C). Il pourra éventuellement être remplacé par un SSD SATA pour libérer un port NVMe.

DISQUES DURS DE 2,5 POUCES

Ces disques sont utilisés pour la matrice ZFS RAIDZ2 principale à 6 disques – celle qui est la plus utilisée. Un jour par semaine, il est occupé par une tâche qui implique la lecture de quelques To au cours de 24 heures. Le reste de la semaine, l’utilisation est sporadique et les disques passent la majeure partie de la semaine à tourner. Pour ceux qui se demandent pourquoi les disques durs de 2,5 pouces sont utilisés à la place des disques durs de 3,5 pouces, il y a *une* raison : la consommation d’énergie.

La consommation électrique des disques Seagate de 2,5 pouces est franchement impressionnante. Ils consomment 0,18 watt chacun, 0,85 watt en mode veille et environ 2 watt en moyenne pour la lecture et l’écriture. Il existe de nombreux disques SSD dont la consommation d’énergie est inférieure à celle de ce disque. Une capacité de 5 To permet de stocker beaucoup d’espace par watt.

Les principaux inconvénients de ces disques Seagate de 2,5 pouces sont les suivants :

- Ils ne sont pas très performants. 80-120MB/s en lecture/écriture. Pour être honnête, de nombreux disques SSD TLC/QLC tombent à ces niveaux d’écriture lorsque leur cache SLC est épuisé.

- SMR (enregistrement magnétique shinglé). Les lectures sont correctes, mais les performances en écriture s’effondrent lorsque des écritures aléatoires ont lieu – il se comporte comme un SSD QLC sans cache SLC qui n’a pas non plus de TRIM.

- Charge de travail nominale faible (55 To/an contre 550 To/an pour les disques Exos 3,5″).

- Pas de temps de récupération d’erreur configurable (SCT ERC), et ces disques peuvent rester bloqués pendant des minutes s’ils rencontrent une erreur alors qu’ils essaient sans relâche de relire le secteur problématique. Ubuntu doit être configuré pour attendre au lieu d’essayer de réinitialiser le lecteur après 30 secondes.

- Des taux d’erreur plus élevés s’ils chauffent (j’ai dû en remplacer quelques-uns et j’ai découvert qu’ils n’aiment pas chauffer).

- Les problèmes typiques des disques durs (lenteur de rotation, etc.).

Pour être tout à fait juste envers Seagate, ces disques sont vendus en tant que disques de sauvegarde USB externes. Sortir ces disques de 15 mm de haut de leur boîtier et les utiliser comme membres d’un RAID dans un NAS n’est pas exactement l’usage auquel ils sont destinés. La très faible consommation d’énergie est extraordinaire, mais il y a des compromis évidents.

À long terme, ces disques 2,5″ de 4/5 To seront lentement remplacés par des disques SSD de 4 To (peut-être tous NVMe). Les disques SSD d’une capacité de 4 To ont commencé à être disponibles sur le marché grand public en 2021/2022 à environ 4-5x le coût des spinners. Moins de 2 ans plus tard, ils sont tombés à environ 2 fois le coût, et je m’attends à ce que les marques décentes durent plus de 2 fois plus longtemps que les spinners Seagate.

Si le modèle Crucial P3 (Gen3) reste disponible, je le conserverai probablement, même s’il est limité aux vitesses Gen3. J’ai fortement envisagé le Crucial P3 Plus (Gen4), mais la consommation d’énergie dans les revues était plus élevée malgré quelques rares situations où les performances étaient notablement plus élevées. Ma plus grande inquiétude concernant le P3 Plus (Gen4) était que si j’avais des problèmes avec ASPM/APST, Tom’s Hardware l’a montré avec une consommation d’énergie au repos supérieure de 0,3w par rapport au P3 (Gen3) pour le modèle 2TB. Je préfère que la consommation dans le pire des cas soit aussi basse que possible.

DISQUE DUR 3,5

Utilisé dans la matrice RAIDZ2 secondaire à 6 disques – une matrice de sauvegarde qui tourne environ 2 heures par semaine et qui reçoit constamment des écritures lourdes.

La consommation d’énergie des disques Seagate de 3,5 pouces est conforme à ce que l’on peut attendre. Ces disques de 10 To consomment environ 0,8 W chacun en veille, 2 à 5 W en mode veille, et 6 à 9 W en lecture et en écriture.

Deux points à prendre en compte :

- Ces disques sont conçus pour consommer collectivement environ 45 à 50 watts en écriture. Cela représente une charge supplémentaire pour l’onduleur que je ne souhaite pas vraiment si une longue coupure de courant se produit pendant les sauvegardes (je m’en tiens à des onduleurs grand public de 1500 watts).

- Ces onduleurs sont conçus pour consommer collectivement environ 4,8 watts lorsqu’ils sont en veille. Encore une fois, je n’hésiterais pas à réduire la charge de l’onduleur.

À long terme, ces disques seront probablement remplacés par des disques Samsung 870 QVO 8TB SATA. Le 870 QVO consomme 0,041w/0,046w au ralenti avec ALPM, 0,224w/0,229w au ralenti sans ALPM, et 2,0-2,7w pendant une copie (selon Toms/Anandtech).

En termes de prix, le Samsung 8TB SATA SSD est actuellement un peu plus cher que les spinners 8TB (près de 3x le prix), donc à moins que ces disques commencent à être utilisés plus fréquemment pour une raison ou une autre, le remplacement par les SSD attendra presque certainement que je sois à court de pièces de rechange.

Lecteur de cache NVMe

Le remplacement de mes rouilles par des disques SSD est un processus qui prendra probablement un certain temps.

En attendant, ZFS dispose de quelques options pour utiliser le stockage à grande vitesse (typiquement SSD) devant le stockage plus lent :

- Classe d’allocation « spéciale » – permet de créer un vdev spécifique pour les métadonnées et pour les « petits » blocs si vous le souhaitez.

- Il s’agit d’un lecteur de cache, communément appelé L2ARC.

Si vous créez le vdev « spécial » lors de la création du pool, toutes vos métadonnées (et, en option, les petits blocs de la taille de votre choix) iront sur le vdev « spécial » au lieu de votre disque en rotation. Les listes de fichiers et la traversée des répertoires sont très rapides tout en conservant la rouille en rotation pour les fichiers eux-mêmes. Oui, vous pouvez « ls » un tas de répertoires sans réveiller vos disques durs. Le plus gros inconvénient est que, comme toutes vos métadonnées se trouvent sur ce disque virtuel, s’il meurt, l’accès à toutes vos données est pratiquement perdu. Il devrait donc être au moins mis en miroir. Peut-être même un miroir à trois voies. Dites adieu à quelques ports.

Le L2ARC est un peu différent. Il s’agit essentiellement d’un cache de niveau 2. Lorsque le cache en RAM est plein, ZFS copie certains blocs dans le L2ARC avant d’expulser ce contenu de la RAM. La prochaine fois que ces données devront être consultées, elles seront lues à partir du L2ARC au lieu du disque. L’un des avantages par rapport au vdev « spécial » est que vous pouvez vous contenter d’un seul SSD – en cas de problème avec les données dans le L2ARC (mauvaise somme de contrôle, disque mort, etc.), ZFS lira simplement le contenu à partir du disque d’origine. De plus, une fois que le L2ARC est plein, ZFS recommence au début du SSD L2ARC et écrase les données qu’il a écrites auparavant, ce qui présente des avantages (les anciennes données ne sont plus jamais consultées) et des inconvénients (les données fréquemment consultées doivent être réécrites sur le L2ARC). Vous pouvez également ajouter/supprimer des périphériques L2ARC du pool à votre guise – vous souhaitez ajouter un SSD de 64 Go, un SSD de 500 Go et un SSD de 2 To ? ZFS répartira les blocs entre eux. Vous avez besoin de retirer le disque SSD de 500 Go du pool quelques jours plus tard pour l’utiliser ailleurs ? Ne vous gênez pas. Le principal inconvénient du L2ARC est que si vous oubliez de spécifier « cache » lors de l’ajout du périphérique, vous avez probablement gâché votre pool. Il est également imparfait : même avec un réglage minutieux, il est difficile de faire en sorte que ZFS écrive TOUT ce que vous voulez sur le L2ARC avant qu’il ne soit expulsé de la mémoire. En même temps, en fonction de vos données, le L2ARC peut voir beaucoup d’écritures, et vous pouvez avoir à surveiller attentivement la santé de votre SSD.

Dans le passé, j’ai utilisé le « special », le L2ARC, et les deux en même temps (vous pouvez même dire au L2ARC de ne pas mettre en cache les données déjà contenues dans le vdev « special »).

Cette fois-ci, j’ai simplement opté pour un L2ARC sur un NVMe de 4 To : une fois que tous les autres disques 2,5″ auront été remplacés par des SSD et que les avantages en termes de vitesse d’un cache SSD ne s’appliqueront plus, je pourrai simplement supprimer ce périphérique de cache (bien qu’en théorie, le fait d’avoir un lecteur de cache L2ARC gérant la majeure partie des lectures *permettrait* aux autres lecteurs NVMe de rester plus longtemps en mode basse consommation…).

Conclusion – Des regrets ? Des remises en question ? Qu’est-ce qui aurait pu se passer différemment ?

Contrairement à la construction de l’ASRock J4005 où j’ai réalisé en cours de route que je m’étais mis des bâtons dans les roues de plusieurs façons, je n’ai pas le même sentiment ici. Cette fois-ci, je me suis retrouvé avec une faible consommation au ralenti ET un système assez performant qui devrait être flexible même s’il est réutilisé à l’avenir.

Je suis assez satisfait de mes choix de composants, même si je serais curieux de savoir comment la MSI PRO Z790-P DDR4 (l’une des autres cartes mères que j’ai envisagées) se comporterait en comparaison. Sur le plan fonctionnel, la MSI a l’avantage d’avoir 6 ports SATA, mais elle a l’inconvénient évident d’avoir la fameuse puce réseau Intel 2.5G. Le MSI dispose également d’un port PS/2 et je n’ai jamais vérifié si la consommation d’énergie d’un clavier PS/2 était inférieure à celle d’un clavier USB (je rappelle que j’économise 1 watt si j’autorise powertop à éteindre le port clavier USB). Et bien sûr, il serait intéressant de comparer les paramètres ASPM et ALPM, et de voir si les problèmes que j’ai rencontrés avec les slots PCIe/M.2 attachés au CPU existent de la même manière.

Alors que ce système tourne actuellement autour de 15-16 watts au repos avec les disques en standby, une fois que tous les disques durs seront remplacés par des SSD, je m’attends à une consommation au repos d’environ 10-11 watts, ce qui n’est pas mal pour 72TB de disques, 64GB de RAM, et un processeur plutôt décent.

Mise à jour : Les noyaux Linux récents désactivent les modes d’économie d’énergie L1 de la plupart des cartes réseau Realtek, ce qui empêche le CPU d’entrer dans des états C décents, augmentant ainsi considérablement la consommation d’énergie. Bien qu’il existe des solutions de contournement, à l’avenir je me limiterai probablement aux cartes mères contenant des adaptateurs réseau Intel 1 Gigabit (peut-être en passant à Intel 2.5 Gigabit lorsqu’il sera clair qu’ils ont résolu tous les problèmes). Vous trouverez plus de détails sur la situation des cartes réseau Realtek dans les commentaires ci-dessous. Le script que je mentionne dans les commentaires se trouve à l’adresse suivante : RTL8125-ASPM.sh.txt .

Je pense que beaucoup de maux de tête auraient pu être évités si tu avais trouvé une carte avec plus de ports sata !

De mon côté, je n'ai jamais réussi à faire passer ma puce au delà du C3. J'ai volontairement essayé de réduire le nombre de composants en trop (comme ces contrôleurs SATA, j'avais lu à quel point ils pouvaient être aléatoires).

Je vais vérifier mes paramètres BIOS pour m'assurer que j'ai activé tous les éléments pertinents que vous avez mentionnés dans votre article.

Article très intéressant, merci beaucoup.

Donc vous ne vous souciez pas de l'ECC, certains disent que c'est un must pour un serveur toujours actif, surtout avec ZFS.

De plus, les NVME semblent brûler plus de carburant que les SSD.

Je suis à la recherche d'une carte mère ECC frugale mais je n'ai encore rien trouvé, les cartes W680 sont difficiles à trouver.

En attendant, je fais tourner Unraid sur une carte Asrock J5040 avec deux SSD de 1 To en miroir et 3 WD mécaniques qui dorment la plupart du temps.

Le système consomme 19 watts au ralenti, il était de 16-17 watts (C6) avant d'ajouter un contrôleur Asmedia (4). Je vais bientôt remplacer le vieux PSU seasonic par un Corsair.

Salutations distinguées

Geert

Gardez à l'esprit que si le deuxième emplacement M.2 est occupé, seuls 5 des 6 ports SATA fonctionneront. Si je me souviens bien, le BIOS du H470M DS3H cachait aussi quelques options (comme forcer l'IGPU ou le GPU dédié) à moins de le mettre en mode CSM. De plus, il se bloquait aléatoirement sur l'écran de démarrage avec une erreur si j'avais un HBA SAS LSI installé, ce qui nécessitait une nouvelle tentative de redémarrage - les contrôleurs SATA normaux fonctionnaient bien par contre. En mettant de côté ces petites nuances bizarres, j'ai trouvé que la carte était fiable, qu'elle fonctionnait très bien et que je l'aimais bien.

Envisagez-vous de publier un article similaire mais pour un système avec support ECC et faible consommation d'énergie à vide qui serait encore compatible avec Linux (je pense que la faible consommation d'énergie à vide d'AMD n'est pas la meilleure pour Linux à titre d'exemple).

J'ai l'intention de réaliser moi-même un tel système bientôt et j'aimerais savoir si je dois commencer à le faire dans le mois ou les deux mois à venir ou si je dois attendre un peu pour lire vos publications qui fourniraient des informations utiles qui pourraient m'aider à prendre des décisions plus éclairées sur le choix des composants.

Quoi qu'il en soit, merci beaucoup pour cet article très complet. Vous avez fait un travail impressionnant en soulignant les parties importantes de la construction d'un NAS basse consommation très efficace.

Quoi qu'il en soit, bonne chance pour votre construction !

Merci pour tes articles sur les NAS, très détaillés et instructifs !

Je suis en train monter le mien avec un i3-10500T, 16Go et 4xHDD.

Pour l'alimentation, j'ai trouvé une Antec EarthWatts 380W EA-380D (80+ Bronze) en reconditionné à 25€ .Est-ce que cela vaut le coup d’après toi ? ou est-elle trop ancienne ?

Si tu as d'autre modèle à me recommandé, je suis preneur. Merci d'avance.

J'ai également utilisé un 970 Evo Plus (2TB) comme disque de démarrage et je peux confirmer qu'il doit être connecté au chipset afin d'atteindre des états C bas (C8). Ce que j'ai trouvé intéressant, c'est que la différence entre les paquets C3 et C8 était beaucoup plus importante lorsque le SSD était connecté au chipset. Je pense que cela est dû au fait que le chipset lui-même n'entre en état de sommeil profond que lorsque tous les périphériques connectés supportent l'ASPM et que le SATA Link Power Management est actif.

Connecter le SSD au CPU PCIe n'a augmenté la consommation que de ~2W (Package C3 vs C8), alors que ne pas avoir ASPM sur un périphérique connecté au chipset semble prendre 5W de plus juste pour le chipset mais a le même effet (C3) sur le package C-State.

Une chose intéressante à noter est que j'ai une carte PCIe 1.1 DVB-C Capture connectée au chipset. Même si ASPM est listé comme une capacité pour la carte par lspci et que j'ai démarré le noyau avec pcie_aspm=force, il n'a pas été activé pour cette carte. J'ai dû forcer l'activation de l'ASPM via setpci, voir https://wireless.wiki.kernel.org/en/users/documentation/aspm - cela semble fonctionner sans problème. Cela m'a permis d'atteindre les 15W de puissance au repos. Malheureusement, la carte de capture consomme encore ~5W, sinon je n'ai actuellement que 2x4TB HDD de Toshiba connectés qui tournent au ralenti quand ils sont inactifs.

A propos, le Sata Hot Plug doit être désactivé pour tous les ports, sinon le paquet n'atteindra que C6.

1) il semble qu'il soit préférable d'utiliser un CPU avec un GPU intégré à moins que la carte mère ne supporte le démarrage sans GPU. J'avais prévu de réduire la consommation d'énergie en retirant la carte GPU discrète (après l'installation du système) mais cette carte mère se bloque au démarrage si aucun GPU n'est connecté ! En cherchant sur Google, j'ai découvert que cette condition est assez typique pour les cartes mères grand public. En regardant les chiffres de xblax, il peut atteindre de meilleurs niveaux de consommation au ralenti (ok, la carte mère n'est pas exactement la même...).

2) Je peux atteindre l'état C10 pour tous les cœurs (colonnes les plus à droite dans powertop) mais l'état C du paquet atteint au ralenti dépend de l'emplacement PCIe utilisé pour le GPU discret. En utilisant le premier emplacement PCI desservi par les voies du CPU, je ne peux pas dépasser l'état C2 du paquet pendant 99% du temps : dans cette configuration, la puissance moyenne du réseau est stablement inférieure à 26W. Si je déplace le GPU vers l'un des autres emplacements desservis par les voies du chipset B760, l'état C du paquet atteint environ 7% (C2) et 91% (C3), la puissance moyenne descend en dessous de 22W mais elle est moins stable.

Y a-t-il une chance d'améliorer le résultat ou vaut-il mieux acheter le CPU 12100 (avec GPU) ?

sh -c "echo 1 > /sys/bus/pci/devices/0000:01:00.0/link/l1_aspm"

(vous devrez remplacer 0000:01:00.0 par ce qui correspond à votre carte Realtek, à partir de lspci -vv)

Si vous essayez, pouvez-vous nous dire dans quel état C et quelle utilisation de Watt vous allez ? :)

Aussi, avez-vous changé pour un iGPU et enlevé l'ancien GPU ?

J'ai vu que quelqu'un avec un MSI PRO B760M-A WIFI DDR4 (qui semble être le même que celui d'ASUS), a le même problème, ainsi qu'avec un Asrock B760M Pro RS/D4.

J'ai pu atteindre environ 13-14W avec cette carte en utilisant ASPM L1 sur le port 2.5Gbit, tous les paramètres BIOS et "powertop --auto-tune"

Pas d'USB / écran connecté, seulement CPU (12600) et 1 Samsung 980 Pro Nvme dans un slot chipset, proxmox fonctionnant au ralenti.

Cependant, j'utilise actuellement un Be quiet ! Dark Power Pro 11, qui n'est pas très économe en énergie à ces faibles charges. Je pense chercher un Corsair RM750(/x)/RM650(/x) d'occasion.

Vous pouvez consulter un bon test sur tweakpc.de

Superbe article, merci pour toutes ces informations.

Je suis en train de planifier la construction de mon nas. Comme la consommation d'énergie est le sujet principal, que pensez-vous de la construction suivante (mais je suis un peu un noob en ce qui concerne le système et ce qui est possible et/ou la limitation d'une puce à faible tdp) ?

Asrock N100M micro ATX (avec le nouveau processeur Intel® Quad-Core N100 (jusqu'à 3.4 GHz) avec un tdp de 6W. Comme il n'y a que 2 ports SATA, l'idée est d'ajouter une carte SAS HBA avec 8 ports SATA supplémentaires sur l'emplacement 1 x PCIe 3.0 x16. Pour le stockage, ce serait 1 M2 (celui de la carte mère) pour TrueNas OS, 2 SSD sata mirroring pour VM, docker, ... et 8 disques durs Seagate EXO 7200 rpm comme étape finale (2 au début et évoluant ensuite en fonction des besoins).

Pour l'alimentation, un Seasonic Focus PX 550W - Modular 80+ Platinum ATX et enfin un stick unique de 32GB de ram (non ECC).

Merci d'avance

En ce qui concerne la carte HBA SAS, je vous suggère de regarder autour de vous pour voir quelle est la consommation d'énergie à vide de la carte spécifique que vous envisagez : les cartes les plus populaires consomment souvent quelques watts alors qu'elles ne font absolument rien. Je ne suis pas sûr de la manière dont *BSD gère les cartes, mais sur les quelques cartes qui semblent avoir l'ASPM activé par défaut, Linux semble finalement le désactiver dans le noyau à un moment ou à un autre en raison de problèmes. Cela dit, c'est une situation où l'ASRock N100 pourrait s'en sortir mieux qu'un combo CPU/carte mère séparé car je m'attends à ce qu'il soit moins sensible aux implications de l'état c d'une carte d'extension, bien que ce ne soit qu'une supposition basée sur ce que j'ai vu avec mes cartes ASRock J4x05 et que cela ne s'applique peut-être pas au N100.

Le Seasonic PX 550W semble être un très bon choix.

Dans l'ensemble, ça a l'air d'être une construction solide !

Avez-vous des conseils pour identifier les cartes mères qui peuvent atteindre une faible consommation d'énergie ? Les gens recommandent parfois les cartes mères ITX, mais je n'ai pas trouvé de mesures sur le nombre de watts économisés par les cartes ITX par rapport aux cartes ATX. Maintenant, ITX n'aurait pas fonctionné pour cette construction, mais ATX ne semble pas avoir été une source significative de consommation d'énergie de toute façon. En général, il semble très difficile de déterminer quelles sont les cartes mères qui consomment peu d'énergie et celles qui n'en consomment pas ?

Que voulez-vous dire par "l'overhead du silicium du E-core" et pourquoi avez-vous essayé de l'éviter ? Je comprends que les CPU avec des E-cores sont probablement plus complexes, mais j'aurais pensé que les E-cores pourraient conduire à une consommation d'énergie plus faible lorsque le CPU effectue des tâches non intensives à faible charge.

Encore une fois, merci pour ces excellentes informations. J'espère pouvoir construire un système avec une efficacité énergétique similaire. Pour l'instant, j'ai une carte mère Gigabyte Z790 UD AX et un système i5-13500 que je n'arrive pas à faire descendre en dessous de 28W.

L'avantage de l'ITX est qu'il tend à limiter le nombre de composants, mais ce n'est pas strictement nécessaire - la semaine dernière, j'ai réutilisé le "Intel i3-10320 sur un Gigabyte H470M DS3H" dont j'ai parlé au début et je l'ai fait descendre à 6 watts au ralenti (sans tête, sans clavier, réseau Intel i219V 1GbE uniquement, c-states dans le BIOS, 3 Samsung SATA SSDs 840/860/870, alimentation Corsair RM850, Ubuntu Server avec powertop). C'est une carte mère très utilitaire. Je ne ferai pas d'article séparé car la carte n'est plus disponible, mais 6 watts sur la carte Gibabyte H470 MicroATX et 7 watts sur la carte ASUS H770 ATX dans cet article sont mes 2 meilleurs résultats jusqu'à présent et notamment aucun n'était ITX. Autre chose que je viens de remarquer : ces deux cartes n'ont que 6 phases d'alimentation.

En ce qui concerne le "E-core silicon overhead", de nombreux détails peuvent être trouvés sur https://www.hwcooling.net/en/the-same-and-yet-different-intel-core-i5-12400-duel-h0-vs-c0/ , mais je vais essayer de résumer. Le i5-12400 est livré avec 6 P-cores et 0 E-cores activés, communément appelé 6+0. Cependant, il existe 2 variantes : un stepping "C0" qui était à l'origine un 8+8 dont les cœurs ont été fusionnés pour devenir un 6+0, et un stepping "H0" qui a été fabriqué directement comme un 6+0 et qui n'a jamais eu de matériel E-core à l'intérieur pour commencer. Lors des tests (page 5 de cet article), le C0 a consommé jusqu'à 16 watts de plus que le H0 selon le benchmark, dont près de 11 watts de plus au ralenti. Il est toujours possible que l'échantillon C0 ait eu d'autres problèmes causant des fuites d'énergie, ou qu'il y ait d'autres variables en jeu, mais quoi qu'il en soit, les deux puces qui avaient du matériel E-Cores physique à l'intérieur ne se sont pas bien débrouillées dans le test au ralenti.

Comme je me concentre sur une consommation au ralenti extrêmement faible pour la plupart de mes systèmes, je ne peux pas justifier l'achat de l'une des puces combinées P/E-core tant que je n'ai pas vu de données montrant que les puces avec E-cores consomment moins de 10 watts au ralenti. Et ce n'est pas encore le cas. C'est un domaine où Intel est très menacé ces jours-ci : les mini PC AMD descendent maintenant à environ 6-7 watts de consommation en veille pour un Ryzen 9 7940HS ( https://youtu.be/l3Vaz7S3HmQ?t=610 ) et si AMD apporte ce type de conception d'APU à l'ordinateur de bureau ou si quelqu'un comme ASRock commence à emballer certaines de ces impressionnantes puces HS dans une carte mère personnalisée, Intel pourrait rapidement perdre le marché de la faible consommation en veille.

Je vois bien que la carte mère que j'ai achetée n'est sans doute pas idéale (elle annonce beaucoup de phases).

Cela dit, même si votre carte avait beaucoup de MOSFETs inefficaces, la consommation de 28 watts que vous dites obtenir semble un peu élevée, à moins que vous n'ayez de la rouille qui tourne ou une carte PCIe qui consomme beaucoup d'énergie. Avez-vous vérifié si vous atteignez des états de puissance C6 ou supérieurs ? Rappelez-vous que lorsque j'ai mis l'ASM1166 sur le slot PCIe principal, j'étais limité à C2 et je consommais 22 watts.

Vous avez en effet raison de dire que les 28 W que j'ai partagés n'étaient pas aussi bons qu'ils pouvaient l'être. J'ai fait l'erreur de penser que débrancher les câbles SATA de mes disques durs les mettrait hors tension. Avec le recul, il est évident qu'il faut aussi les débrancher du bloc d'alimentation. En outre, j'avais un tas de périphériques connectés au PC dont je n'avais pas réalisé qu'ils consommaient de l'énergie (en particulier, un moniteur branché fait une grande différence). Après avoir déconnecté tous les disques durs et tous les périphériques, j'obtiens des valeurs de l'ordre de 8-10W.

Pour que ces données soient utiles à d'autres, je vais donner quelques détails supplémentaires. Le CPU est un i5-13500 dans une carte mère Gigabyte Z790 UD AX. La seule chose connectée est un SSD SATA et un seul stick de mémoire. Le PSU est un Corsair RM850x de 850W. Le système atteint C8 et même C10. Il y a encore quelques petites choses à faire pour réduire la consommation d'énergie. J'ai pris des mesures alors que GNOME tournait au ralenti (je suppose que le fait de ne pas avoir DE en cours d'exécution permet d'économiser un tout petit peu de CPU), j'ai deux ventilateurs de CPU qui tournent lentement même à basse température, le système est en WiFi (je suppose que l'Ethernet consomme moins d'énergie), et je n'ai pas désactivé les LED de l'étui ni le HD Audio.

Je suis maintenant très satisfait du niveau de consommation d'énergie. Peut-être que l'on peut en déduire que les processeurs Intel E n'affectent pas beaucoup la consommation d'énergie au repos, du moins pour ce processeur. Le seul problème que j'ai maintenant est que le système est instable et redémarre sporadiquement 😭. Je pense avoir réduit le problème à un CPU défectueux ou à une carte mère défectueuse (j'ai essayé de remplacer le PSU et memtest86+ dit que la mémoire est bonne). La société où j'ai acheté les pièces prétend que les deux sont en bon état, mais à moins que je ne trouve une autre solution, je vais essayer de remplacer le CPU et la carte mère par des pièces bas de gamme : un i3 de 13ème génération et une carte mère Asus B760M-A. Si cela résout le problème, j'espère pouvoir renvoyer les autres pièces, dans le pire des cas, j'utiliserai les pièces économiques pour un serveur et les pièces plus haut de gamme pour une station de travail.

J'ai exactement la même configuration ( i5-13500 + Z790 UD AX), mon disque de démarrage est un Samsung 990 pro 4TB

et j'ai exactement le même problème - des redémarrages sporadiques. J'ai essayé la dernière version du BIOS, mais je n'ai pas réussi à trouver la cause.

J'ai essayé le dernier BIOS F9b ainsi que F5 et j'ai changé plusieurs paramètres du BIOS, mais jusqu'à présent rien n'y fait. Je pense que le disque de démarrage entre dans un mode de faible puissance et qu'il est incapable de s'en remettre, mais je ne sais pas comment le prouver.

Il n'y a pas d'événements avant le crash, j'ai aussi configuré netconsole - toujours rien d'enregistré.

Avec le dernier BIOS, les paramètres par défaut et la 970 evo plus comme périphérique de démarrage (aucun autre disque connecté), le système semble stable, mais malheureusement il consomme 32W en moyenne au ralenti, ce qui n'est pas acceptable.

Pour l'instant je modifie un paramètre à la fois et j'attends plus de 12h pour trouver la cause de ce problème, ce qui prend beaucoup de temps.

J'ai essayé tous les réglages, une fois que j'ai activé c8/10 le système devient instable et s'éteint à un moment donné, j'ai vérifié tous les disques et les câbles, j'ai remplacé le psu deux fois, j'attends actuellement un RMA pour le cpu de la part d'intel. J'ai aussi essayé différents firmwares BIOS sans succès, donc il semble que si un RMA CPU ne résout pas le problème, il s'agit d'un problème avec les cartes mères Gigabyte z790.

Je suis déçu car je n'ai plus de fenêtre de retour et je ne veux vraiment pas m'occuper du RMA de Gigabyte, donc si le RMA du CPU ne fonctionne pas, je vais devoir vivre avec ou le vendre et acheter une autre carte.

Étant donné que ce fil est un peu ancien (décembre 2023), je me demande si quelqu'un d'autre a eu ce problème et a pu le résoudre.

Merci.

Je teste actuellement un ASUS TUF GAMING B760M-PLUS WIFI D4 (12+1 DrMos) et au ralenti, avec l'écran et l'USB (souris, clavier) suspendus, l'indicateur de puissance affiche 6,7-8,1 W. Le reste du système :

- i5 13500

- 2 x 16 GB 3600 MHz (gear 1)

- 1 TB KC 3000

- RM550x 2021

- 2 ventilateurs de 120 mm à 450 tr/min

- codec audio activé

- WiFi désactivé

Arch Linux + module RTL8125 (mon routeur ne supporte pas EEE)

Avec la carte Realtek désactivée, l'indicateur de puissance affiche 6.4 - 6.7 W

États du PC avec LAN

C2 (pc2) 0,7%

C3 (pc3) 1,3

C6 (pc6) 41,1%

C7 (pc7) 0,0%

C8 (pc8) 0,0%

C9 (pc9) 0,0 % C10 (pc10) 55,0 % 0,0 % C10 (pc10)

C10 (pc10) 55,8%

États PC sans LAN

C2 (pc2) 0,6%

C3 (pc3) 0,9%

C6 (pc6) 0,0%

C7 (pc7) 0,0%

C8 (pc8) 0,0%

C9 (pc9) 0,0 % C10 (pc10) 97,6

C10 (pc10) 97,8%

J'ai obtenu des résultats similaires sur un B660 AORUS MASTER DDR4 (16+1+1).

J'ai récemment acheté un i3-13100 (4+0) et un i3-13500 (6+8) pour tester les affirmations de "E-core overhead" que j'ai vues en ligne. Je suis heureux d'annoncer que la consommation d'énergie au repos est identique pour ces deux puces ! Peut-être que le problème de consommation élevée est propre au i5-12400 C0, malheureusement je n'en ai pas un sous la main pour le tester.

Perte de puissance de 4W

J'utilise actuellement un quanta 1u que j'ai acheté sur ebay juste avant l'arrivée de covid et ses performances en single-core montrent vraiment qu'il a pris de l'âge. De plus, il tourne au ralenti à 80W >.<

J'aimerais partager mon expérience avec mon nouveau PC 12-14 W.

Je viens de construire un PC mini-ITX sans ventilateur. Le boîtier est également un refroidisseur passif - AKASA Maxwell Pro et à l'intérieur se trouve un AMD Ryzen 5600G (Zen 3, 65W TDP), Gigabyte B550I AORUS PRO AX (bios FB), 1x 16GB DDR4 (je prévois de passer à 2x32GB), 1x 2TB Samsung 980Pro m.2 SSD. Il est alimenté par une alimentation 12V AC/DC de AKASA (max. 150W) et une PSU Inter-Tech MINI-ITX 160 W.

12-14W de consommation en veille pour l'ensemble du PC sous Windows 10 (mesuré côté DC, le plan d'alimentation est équilibré, mais j'ai activé ASPM, Pstates et C-states dans le bios et l'économie d'énergie PCIe dans les paramètres avancés du plan d'alimentation de Windows).

En charge (Cinebench R23) 61-65W. Actuellement je fais du undervolting pour avoir une meilleure consommation d'énergie et de meilleures températures.

----------

mon petit laboratoire domestique & ; NAS a une consommation d'énergie en veille de moins de 2W ‼️

Je recommande l'Odroid H3 (H3+) avec BIOS 1.11 et Debian 11 + DietPi + kernel 6.0.0 (ou plus récent) + tweaks appliqués via powertop il a une consommation d'énergie au ralenti de seulement 1.2 - 1.5W (comparé à 2.7W pour RPi 4 - source) ⚡️(avec ma configuration : 1x 16GB RAM et 1x SATA SSD).

See: https://i.ibb.co/7QD390m/H3-1-10-6-0-0-sata-idle.gif

La taille maximale de la mémoire est de 64 GB RAM et il a 1x port m.2, 2x SATA 3, et 2x LAN 2.5Gbps. Il est beaucoup plus rapide que le Raspberry Pi 4 et consomme moins d'énergie en veille. En charge, il peut consommer 20W (+dépend des appareils connectés).

Si vous avez besoin de plus de ports SATA, le port m.2 peut être étendu à 5x SATA en utilisant ceci : https://wiki.odroid.com/odroid-h3/application_note/m.2_to_sata_adapter

Je me bats actuellement pour que mon nouveau NAS consomme moins de 40W au ralenti, sans disque de données, et je n'arrive pas à comprendre pourquoi il en consomme autant. Mon ordinateur de jeu consomme moins au ralenti.

C'est un Asrock H670M-ITX/ac avec un i3-12100, 8GB RAM, be quiet 400W PSU. A l'origine, j'utilisais un Kingston NV2 NVMe pour le système d'exploitation, mais j'ai découvert qu'en le remplaçant par un SSD SATA, la consommation au ralenti diminuait d'environ 10W (50W - > 40W).

D'après powertop, les cœurs entrent en C7 sans problème, mais le paquet refuse de quitter C2. Je ne sais pas si c'est important.

Je vais continuer à travailler dessus, avec votre article comme référence :)

Matt,

J'ai acheté la même carte mère (prime h770 plus d4) et un processeur similaire etc. J'ai pu atteindre 12-14w minimum. Je suis content de ça pour l'instant mais les 8w supplémentaires dus au fait que le package n'atteint plus le c8 sont très frustrants, avez-vous vu quelque chose de similaire dans votre construction ?

Plusieurs enquêtes ont montré qu'il s'agit d'un problème de lecteur avec RealTekLAN. Si vous téléchargez et installez les pilotes pour le chipset 8125 à partir du site de Realtech, vous pouvez atteindre c10 comme avant.

vous devriez envisager un autre PSU comme le Corsair RM550x (2021) ou le BeQuiet 12M 550W. Le Corsair est le meilleur pour les configurations à faible consommation, mais il est extrêmement difficile à obtenir. Il réduira la consommation d'énergie encore plus (2 à 4 watts).

Ce réglage et d'autres sont mentionnés dans ce sujet :

https://forums.unraid.net/topic/98070-reduce-power-consumption-with-powertop/

Malheureusement, il s'agit d'une modification intentionnelle du pilote Realtek contenu dans le noyau. Il garantit que L1 est désactivé sur pratiquement tous les adaptateurs Realtek, apparemment en réponse à un certain nombre d'adaptateurs Realtek rencontrant des problèmes de stabilité lorsque ces états de faible consommation sont activés. Sur mon système de test actuel, cela se traduit par une augmentation de la puissance de 4 watts au ralenti avec l'écran en veille, car le système ne descend plus en dessous de C3.

Essayer le pilote Realtek qui a été lié par Tseting est probablement la solution la plus facile pour l'instant, bien que je n'aie aucune idée de la façon dont il se comportera avec des versions de noyau non prises en charge et que je ne sois pas personnellement un grand fan des modules de noyau. Je vais le coller ici pour plus de commodité : https://www.realtek.com/en/component/zoo/category/network-interface-controllers-10-100-1000m-gigabit-ethernet-pci-express-software

Il y a bien sûr une solution plus difficile - pour ceux qui sont familiers avec la compilation du noyau, inverser le changement dans le diff ci-dessus restaurera L1/L1. 1 sur les dispositifs RTL8168h/8111h, RTL8107e, RTL8168ep/8111ep, RTL8168fp/RTL8117, et RTL8125A/B (tous les dispositifs plus anciens l'avaient déjà désactivé) - si vous voulez autoriser L1.2, vous pouvez forcer rtl_aspm_is_safe() à renvoyer true, bien que sur mon système de test, cela n'ait apporté aucun avantage par rapport à L1.1.

À moins que les développeurs du noyau ne changent d'avis, il semble que les cartes réseau Intel soient la seule option viable pour l'avenir. Les cartes réseau 1G d'Intel sont généralement très solides. Il est inquiétant de constater que la désactivation de la carte réseau Realtek sur ma carte MSI ne la désactive pas complètement (elle est toujours bloquée à C3). Il peut donc être risqué d'acheter une carte avec une carte réseau Realtek en prévoyant de la désactiver et d'utiliser une carte d'extension réseau Intel. Il est intéressant de noter qu'à l'avenir, il existe un drapeau que les vendeurs peuvent placer sur un adaptateur 8125A/B pour indiquer que L1.2 est testé et autorisé, ce que le noyau Linux respectera, mais je ne sais pas s'il a été intégré à des cartes mères ou à des cartes d'extension.

Merci pour les informations détaillées que vous avez partagées.

Votre configuration m'a inspiré et j'ai acheté le "Prime h770-plus" avec la Ram DDR 4800.

Malheureusement, j'ai également des problèmes avec les SSD NVME lorsque aspm est activé dans le bios (et PCI express clock gating). Les solutions de contournement pour bloquer certains modes d'économie d'énergie des WD n'ont malheureusement pas aidé. J'ai essayé le SN750 (1tb) et le SN850X(2tb).

Pouvez-vous continuer à recommander la Crucial P3 ou est-elle régulièrement mise hors service en raison de problèmes ASPM ?

Qui a d'autres NVME sur la carte qui fonctionnent de manière fiable avec l'ASPM activé ?

Je pense que vous utilisez la configuration de manière productive en continu ?

De plus, j'ai constaté qu'une 840pro (256gb) empêche le système de descendre en dessous de C3 au moins sur SATA1. Un Crusial Force GT (128GB) fonctionne en revanche jusqu'à C8.

J'ai contourné le problème de la carte réseau Realtek en retirant la vérification dans le noyau.

Merci et meilleures salutations

J'ai maintenant essayé un Samsung 990 pro. Malheureusement, cela continue à provoquer les erreurs nvme aspm déjà connues.

Quelqu'un a-t-il d'autres idées ?

Le bloc d'alimentation ne peut pas être en cause (ce serait très étrange), car un Corsair cx 750 est utilisé temporairement.

Si tout cela n'aide pas, quelqu'un aurait-il une bonne alternative de carte ?

Je mets malheureusement trop souvent les pieds dans le plat en matière de matériel informatique ;-(.

En soi, c'est un disque nvme VRAIMENT efficace pour seulement quelques dollars. Mais ce qui le rend excellent pour notre utilisation, c'est sa capacité à faire tourner n'importe quel cpu jusqu'à c10 avec quelques réglages du bios.

"Je pense que beaucoup de maux de tête auraient pu être évités si vous aviez trouvé une carte avec plus de ports SATA !"

Ce n'est pas vrai par défaut - parce que cela dépend du contrôleur SATA utilisé et/ou de la façon dont ces ports sont connectés. Il y a de fortes chances qu'il utilise un contrôleur embarqué, et spécifiquement pour le N5105, il y a une variante NAS bien connue avec 6 ports SATA qui circule, vendue par Kingnovy et Topton.

La variante noire utilise JMS585 et la variante verte utilise ASM1166 - la variante noire est bloquée en C3 et la variante verte peut aller jusqu'à C8 (vérifié par moi-même car j'ai la variante verte). Si j'avais besoin de quelque chose de plus qu'un serveur de secours, alors j'opterais pour cette solution - avec un Intel beaucoup plus puissant sur LGA1700.

Un bon exemple de ce que l'on peut faire en matière de consommation d'énergie au repos est l'Odroid H3 - <2W au repos avec 2x HDDs via SATA en Spindown ... cependant dès que l'on ajoute de (mauvais) composants, cela s'accélère rapidement - vérifiez les stats de consommation d'énergie ici :

https://github.com/fenio/ugly-nas

TLDR : En fin de compte, il consomme plus d'énergie que votre construction ici - et je dois ajouter que j'ai précédemment possédé un Odroid H2, qui a grillé leur voie 5V et a entraîné les SSD (chers) avec lui ... depuis lors, je reste à l'écart pour le maximum absolu de la consommation d'énergie la plus faible dans des combinaisons exotiques comme l'Odroid H3.

Je dirais qu'en fin de compte, tout se résume à la praticité de l'ensemble par rapport aux niveaux de consommation d'énergie.

Cela dit, je suis impressionné par cette construction - 7W au ralenti avec un PSU de 750W, c'est quelque chose.

Je suis en train de mettre à jour mon serveur domestique du j3455 au 11400.

En changeant de matériel, j'ai trouvé un problème étrange :

I5-11400+2x8Gb 2666 ddr4 +ASUS Prime B560M-A (dernier bios) +asm1166.

Si je démarre depuis l'USB sans aucun disque sata attaché, l'état du paquet C atteint c8.

Si je démarre en USB avec un disque SATA connecté au contrôleur sata embarqué, l'état du paquet C n'atteint que C2 (+4W).

Si je démarre en USB avec un disque SATA connecté à un contrôleur pcie asm1166, l'état du paquet c atteint c8.

Il me semble donc que le contrôleur SATA b560 a des problèmes d'économie d'énergie. Même si j'ai activé L1 pour tout et que j'ai lancé powertop tune, il ne descend pas en dessous de c2.

Est-ce que vous avez une idée de ce qui pourrait faire que le contrôleur SATA b560 consomme 4w de plus ?

En fin de compte, il pourrait être moins coûteux d'ajouter un autre ASM1166 à la place du contrôleur embarqué :D

C'est activé, j'ai aussi essayé avec désactivé, mais cela n'a pas changé la consommation d'énergie ou les C-States. (je le laisse activé pour l'instant)

Dans le BIOS, je peux spécifier si M.2_2 utilise SATA ou PCIE. Selon le BIOS et le manuel, SATA6G_2 n'est bloqué que si M.2_2 est réglé sur SATA.

Mais j'ai connecté l'ASM1166 dans M.2_2 et l'ai configuré en PCIE. J'ai confirmé que tous les ports SATA embarqués fonctionnent comme prévu avec ce réglage.

Le Hotplug est désactivé par défaut pour tous les ports. Je l'ai activé pour voir si cela changeait quelque chose, mais ce n'est pas le cas. Je le laisse sur Disabled pour l'instant.

J'ai démarré à partir d'un port USB et j'ai essayé différents périphériques : 2 SSD (Emtec et Samsung plus ancien), 2 disques durs 3.5" (WD et Seagate) et même 1 graveur de DVD LG.

Il semble que le type de périphérique connecté n'ait pas d'importance.

C'est toujours la même chose, dès que je connecte un périphérique via SATA, le C2 embarqué est au maximum.

Pour le vérifier, j'ai démarré à partir d'une clé USB avec des périphériques SATA connectés, puis je les ai tous débranchés pendant le démarrage.

Dès que le dernier périphérique SATA est physiquement déconnecté du système, il passe immédiatement en pc6 et en pc8 peu de temps après.

Lorsque l'on reconnecte tous les périphériques SATA, on reste en PC6/8 mais le dmesg ne reconnaît pas la reconnexion (très probablement parce que le hotplug est désactivé).

Je vais parcourir les logs de démarrage de dmesg, peut-être que quelque chose d'intéressant en ressortira.

-Je n'ai pas eu de problème avec la carte mère, mais j'ai eu un problème avec la carte mère.

-Le contrôleur sata fonctionne (testé avec l'adaptateur m.2-pcie&x16 du mobo et le slot m.2 d'un autre minipc)

Mais avec l'asm1166 connecté au slot m.2, rien ne s'affiche dans le bios ou le lspci.

Je ne sais pas comment procéder, mais je ne suis pas sûr que ce soit le cas.

Je ne sais pas comment procéder par la suite

https://youtu.be/-DSTOUOhlc0?t=254

De plus, une chose que je ne comprends pas en général, si j'utilise le serveur domestique comme NAS mais aussi comme routeur, est-ce que cela empêcherait d'atteindre des états c élevés au ralenti étant donné qu'il devrait toujours faire un peu de travail ? J'ai une connexion gigabit et j'utilise actuellement openwrt sur un pi4 mais avec qos activé je n'obtiens que la moitié de la vitesse de téléchargement.

Je vous remercie.