We beginnen met een stukje geschiedenis:

- 2016: Een pc bouwen met laag stroomverbruik op Skylake – 10 watt idle

- 2019: 9 watt inactief: een energiezuinige NAS / bestandsserver voor thuis maken met 4 opslagschijven

- 2021: (geen beschrijving) – 11 watt met een Intel i3-10320 op een Gigabyte H470M DS3H

Niet al mijn systemen waren zo succesvol. In 2022 heb ik een paar andere systemen gemeten op 19 watt en 27 watt als onderdeel van Het verminderen van de “Gas-Guzzling” neigingen van AMD Radeon met Multi-Monitor . Hoewel ik er enige tijd later in slaagde om dat AMD-systeem van 27 watt minder stroom te laten verbruiken, is niet elke combinatie van CPU en moederbord voorbestemd voor het 10 watt-balpark.

—

Voordat ik verder ga, het getal van 7 watt voor dit systeem was voordat er opslag was toegevoegd. De 7 watt (gemeten aan de muur) omvat:

- Motherboard (Intel H770)

- CPU (Intel i5-12400)

- 64 GB RAM

- SSD (opstarten Ubuntu Server 23.04)

- PSU (Corsair)

- C-States ingesteld in BIOS zodat het C8 bereikt

- powertop met auto-tune (waardoor het USB-toetsenbord werd uitgeschakeld wanneer de poort in de slaapstand ging)

Merk op dat als ik powertop niet toesta om het toetsenbord uit te schakelen, ik 8 watt krijg gemeten aan de muur.

—

Laten we eens kijken naar de gedetailleerde specificaties en componentkeuzes. Deze keer had ik de volgende doelen:

- laag stationair vermogen

- redelijke CPU prestaties voor compressie

- geschikt voor 12 harde schijven + ten minste 1 NVMe

- capaciteit om die 12 harde schijven (uiteindelijk) te converteren naar 6 NVMe + 6 SSD SATA

- kosten onder controle houden – aangezien een moederbord zou moeten worden aangeschaft, proberen het bij DDR4 te houden en een CPU te hergebruiken die ik al heb.

Een nieuw systeem samenstellen met de hoop in de buurt van de 10 watt te komen *gemeten vanaf de muur* is vaak niet alleen een uitdaging, maar ook een beetje een gok. Soms moet je gewoon je best educated guesses nemen wat betreft componenten, je systeem bouwen, afstellen wat je kunt en laten vallen waar het valt.

Motherboard – ASUS Prime H770-Plus D4

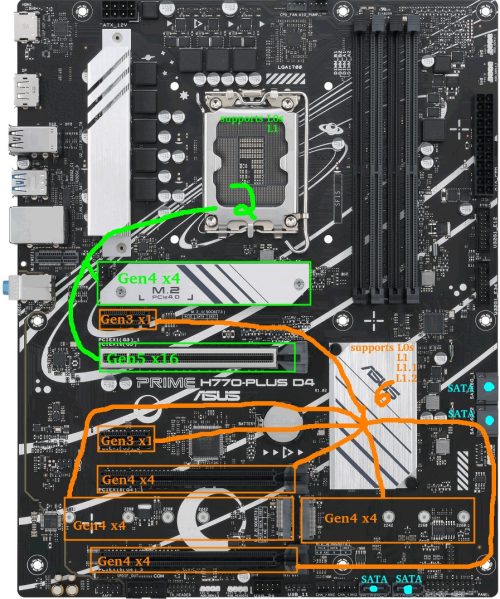

Voordat ik begin, volgt hier een korte blik op de indeling van het moederbord. De GROENE CPU-connected slots en ORANJE chipset-connected slots zullen relevant worden gedurende deze schrijfsessie.

Op het moment van schrijven waren moederborden uit de Intel 600/700-serie en AMD 500/600-serie algemeen verkrijgbaar.

Een van mijn doelen hierboven was de capaciteit voor uiteindelijk 6 NVMe-schijven.

Dieper ingaan op waarom dit een uitdaging kan zijn (sla dit gedeelte gerust over)…

Probleem: Er zijn 0 consumentenmoederborden met 6x M.2-sleuven die allemaal tegelijkertijd in PCIe-modus kunnen worden gebruikt. Bij AMD lijkt het op de MEG X570S Unify-X Max, maar in de handleiding staat dat als je ze alle 6 probeert te gebruiken, de laatste een SATA-variant moet zijn. De ASRock Z790 PG Sonic heeft ook 6 slots, maar je kunt er maar 5 van gebruiken (met een legitiem excuus: ze bieden een Gen5 NVMe slot, maar het komt met een of/of voorbehoud).

Waarom dit probleem bestaat: Er zijn chipset lane beperkingen op consumentenborden. Ervan uitgaande dat ik de mogelijkheid wil hebben om alle M.2 in Gen4x4 te gebruiken en ervan uitgaande dat een fabrikant daadwerkelijk bereid is om alle lanes aan M.2 NVMe-sleuven te besteden (dat doen ze niet), zouden de AMD X570 en Intel B760 maximaal drie M.2-sleuven hebben, terwijl de AMD B650 en Intel H670/Q670/Z690/W680 er vier zouden beheren. Vijf M.2 slots is mogelijk op AMD X670 en Intel H770 borden. Zes op een Z790-bord. Daarboven zijn buitengewone maatregelen nodig, zoals het beroven van de lanes uit het hoofd PCIE-slot. Als het aantal M.2-sleuven zo groot zou willen zijn, zouden fabrikanten theoretisch lanes in Gen4x2 kunnen uitvoeren of enkele Gen3 M.2-sleuven kunnen toevoegen, maar dan hebben ze een *zeer* nicheproduct gecreëerd.

De oplossing: PCI-E naar M.2 adapters werden noodzakelijk. Bij het zoeken naar een moederbord werd het nu een kwestie van het toevoegen van de meegeleverde M.2 slots aan alle beschikbare PCI-E slots die x4 of hoger kunnen. Mijn opties waren nu beperkt tot AMD X570, Intel H770 en Intel Z790 moederborden. Merk op dat hoewel het gebruik van bifurcatie een mogelijkheid is op sommige moederborden om meer dan 1 NVMe uit het hoofd PCIe slot te halen, ik besloot om hier niet op te vertrouwen.

Ik heb om een paar redenen voor Intel gekozen:

- Chipset TDP: Intel-chipsets uit de 600/700-serie hebben allemaal een TDP van 6 W, terwijl de TDP van de AMD X670-chipset vrij hoog is (7w+7w). Het stroomverbruik van AMD-chipsets baart me al een tijdje zorgen, aangezien de vorige X570-chipsets een TDP van 11w hadden en een ventilator nodig hadden.

- Snelheid van de chipset: Intel H670/Q670/W680/Z690/H770/Z790-chipsets hebben een DMI 4.0 x8-verbinding met de CPU. AMD X570/B650/X670 hebben een PCIe 4.0 x4 verbinding naar de CPU. Theoretisch zou de doorvoer van Intel twee keer zo groot moeten zijn als die van AMD (16GB/s vs 8GB/s).

- Ik had al 64GB DDR4 die het Intel-systeem kon gebruiken. AMD 600-serie chipsets zijn allemaal DDR5-only.

- Ik had al een Intel CPU van de 12e generatie.

- Ik heb nog geen positieve discussie gezien over AM5 stroomverbruik. Helemaal niet. Update: terwijl ik dit aan het schrijven was, kwam er nieuws naar buiten over AMD 7000-serie CPU’s die verbranden waar de pinnen van de moederbord socket de CPU raken. Ja, sorry AMD, deze keer niet.

Dus werd het Intel. Nadat ik de beschikbare DDR4 moederborden op de markt had bekeken, beperkte ik de opties snel tot 2 fabrikanten: MSI en ASUS.

Ben je niet geïnteresseerd in de bordvergelijkingen? Sla dit dan gerust over.

De verleidelijke MSI-borden waren de PRO Z790-P WIFI DDR4 en Z790-A WIFI DDR4. Bijna identiek aan de oppervlakte, behalve dat de “A” een beetje meer premium is (audio, achterpoorten, heatsinks, stroomfasen, etc). Voors/nadelen:

- Pro: 4x M.2 (Gen4x4) + 1x PCIE Gen5x16 + 1x PCIE Gen4x4 ondersteunt in totaal 6 Gen4 NVMe

- Pro: 2x PCIE Gen3x1 extra

- Pro: 6 SATA-poorten

- Con: Intel 2.5G LAN (staat bekend als problematisch en buggy)

- Con: Ik ben geen fan van het MSI BIOS

- Con: Mijn huidige B660-bord dat resulteert in een hoger inactief verbruik dan verwacht is een MSI.

Aantrekkelijke ASUS-opties waren de Prime H770-Plus D4 en Prime Z790-P D4 (optionele WIFI-editie). De TUF, Strix of ProArt waren gewoon te duur.

Ik zal beginnen met het opnoemen van de voor- en nadelen van de H770-Plus:

- Pro: 3x M.2 (Gen4x4) + 1x PCIE Gen5x16 + 2x PCIE Gen4x4 ondersteunt in totaal 6 Gen4 NVMe

- Pro: 2x PCIE Gen3x1 extra

- Con: slechts 4 SATA-poorten

Pro: 2,5G Realtek netwerkadapter (tegenwoordig te verkiezen boven Intel 2,5G LAN)(zie opmerkingen)De Z790-P D4 is vergelijkbaar, maar heeft meer voedingsfasen, betere koeling, meer USB-poorten, extra ventilator header, en voor onze doeleinden…:

- +1 PCIE Gen4x4

- -1 PCIE Gen3x1

Uiteindelijk was de ASUS Prime H770-Plus D4 ongeveer $100 goedkoper op dat moment en dat is wat ik heb gekozen.

Een voordeel van “goedkopere” borden is dat ze vaak minder componenten hebben en dus minder stroom verbruiken tijdens inactiviteit, hoewel dit niet altijd een zekerheid is.

CPU – Intel i5-12400 (H0 stepping) – Alder Lake

Ik had deze CPU al als onderdeel van een eerdere desktop build. Destijds werd deze gekozen voor het desktop systeem omdat:

- het AV1 hardware decodering had

- het had de hoogste prestaties die beschikbaar zijn uit de Intel line-up van de 12e generatie die de E-core silicium overhead vermijdt

- in die build kreeg ik sowieso een nieuw moederbord met 2xDP, en het had voor mij geen zin om voor een oudere generatie te kiezen.

Die desktop build bleek een teleurstelling te zijn en behoort tot mijn minst favoriete builds.

Een paar details…

Ik had problemen waarbij soms slechts 1 van de 2 DP-monitoren wakker werd in Linux, wat betekende dat ik de andere DP connector moest loskoppelen, of het systeem handmatig moest opschorten/hervatten zodat het opnieuw kon proberen.

Een ander probleem was dat opnieuw opstarten tussen Windows/Linux soms vreemde problemen veroorzaakte waardoor het systeem volledig uitgeschakeld/opnieuw opgestart moest worden.

Hardware decodering op Ubuntu met Wayland is nog steeds problematisch en wanneer programma’s het probeerden te gebruiken om video af te spelen, ontstonden er problemen.

Tot slot, in tegenstelling tot mijn vorige Intel systemen die allemaal naar beneden konden worden gebracht in de buurt van de 10 watt mark, liep deze stationair op 19 watt, hoewel ik vermoedde dat het MSI moederbord dat ik gebruikte een factor kan zijn geweest.

De meeste problemen die ik ondervond hadden te maken met de GPU en het beeldscherm. Aangezien ik op het punt stond om iets server-gerichts te bouwen, was dat niet langer een factor.

MEMORY – 64GB DDR4-3200

Dit is wat ik gebruikte:

- 2x16GB Kingston HyperX dual-rank (Hynix DJR)

- 2×16 GB Kingston HyperX single-rank (Hynix CJR)

Dit was geheugen dat ik al had. Ik draaide de 4 sticks geheugen op het XMP-profiel van de dual-rank kit die 16-18-18-36 was. Al het andere werd in wezen op de standaardwaarden gelaten behalve dat ik het RAM op 1,25 volt liet draaien (hoger dan de standaard 1,20 volt, maar lager dan de XMP 1,35 volt instelling). TestMem5 en Memtest86 toonden stabiliteit op 1.22v, maar testen van dit geheugen op vorige moederborden hadden aangetoond dat 1.22v onstabiel was, dus voor een beetje extra buffer wat betreft stabiliteit heb ik het voltage verhoogd naar 1.25v.

Bootstation – Sandisk Ultra 3D 1TB SSD

Dit onderdeel is niet bewust gekozen. Toen ik een verse Ubuntu Server installatie wilde doen om te testen, was dit toevallig de enige SSD die ik nog had rondslingeren die op dat moment niet werd gebruikt. Ik ging veel A/B testen doen op PCIE en NVMe apparaten, dus Ubuntu 23.04 installeren op een SATA SSD was zinvol om PCIE slots vrij te houden.

Merk op dat na het testen het hoofd OS op een Samsung SSD 970 EVO Plus 500GB NVMe zou draaien. Er valt niet veel over te zeggen, behalve dat de spullen van Samsung de neiging hebben om betrouwbaar in de spaarstand te gaan.

Omdat ik beide schijven heb gebruikt, kan ik geen verschil meten tussen de schijven in mijn tests. Tom’s Hardware testte de Samsung idle op 0,072 watt (via ASPM/APST) en Anandtech testte de Sandisk Ultra 3D idle op 0,056 watt (via ALPM). Beide zijn ruim onder de 1W resolutie van mijn Kill-A-Watt meter.

PSU – Corsair RM750

Deze 750W PSU lijkt misschien overkill voor een systeem dat bedoeld is om rond de 10 watt te zitten, maar wanneer 12 schijfmotoren tegelijkertijd draaien, is de momentane belasting waarschijnlijk vrij hoog. Seagate vermeldt 2A/3A DC/AC piekstromen op de 12V rail voor een van hun 10TB 3,5″ schijven. Zelfs bij willekeurig lezen/schrijven kan de piekstroom oplopen tot meer dan 2A.

Deze uitbarstende stroomvraag kan problemen opleveren als de PSU niet opgewassen is tegen de taak. Als een array van 6 schijven gezamenlijk 150-200 watt trekt op hetzelfde moment dat de CPU een piek van 120 watt trekt, is dat een sprong van ongeveer 10 watt in ruststand naar ongeveer 400 watt. Dit kan gemakkelijk een onmiddellijke spanningsdip veroorzaken – als het genoeg dipt om een onmiddellijke crash/reboot te veroorzaken is het waarschijnlijk niet erg, maar als het net genoeg dipt dat gegevens beschadigd raken tijdens een geheugenverversing of wanneer een andere schijf midden in het schrijven is… dat is een pijnlijker probleem. Het is zinvol om de PSU tot op zekere hoogte te overbelasten (of in-line condensatoren toe te voegen aan de stroomrails).

Gelukkig is een groot deel van de Corsair RM-serie, ondanks het feit dat deze buiten het piekrendementbereik valt, behoorlijk efficiënt over een groot bereik.

Vermogensmetingen – Initieel

Een paar belangrijke dingen:

- Vermogen gemeten vanaf de muur

- Intel PowerTOP werd gebruikt om instellingen automatisch af te stellen

- Ubuntu Server 23.04

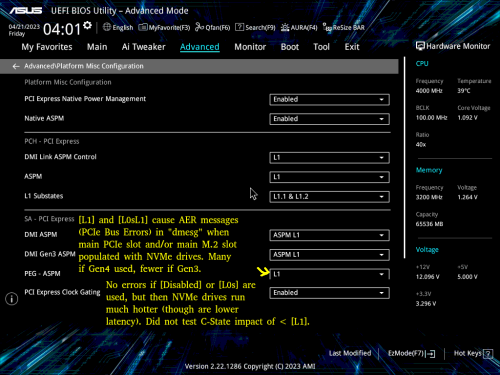

Een paar potentieel belangrijke BIOS bits:

- CPU C-states waren ingeschakeld in het BIOS (C10)

- ASPM was ingeschakeld met alles ingesteld op L1

- RC6 (Render Standby) ingeschakeld

- Aggressieve LPM-ondersteuning ingeschakeld (ALPM)

- GESCHAKELD: HD Audio, verbindingsmodus, LED’s, GNA-apparaat, seriële poort

9-10 watt was het verbruik als de display-uitvoer aan stond.

7 watt was het verbruik als het beeldscherm uit stond (consoleblank=600 kernel boot parameter voor een 600s timer), wat de meeste tijd van de week is.

8 watt was het verbruik als het energiebeheer van het USB-toetsenbord was uitgeschakeld. Als je niet van een andere plek naar de server SSH’t, kan het nodig zijn om extra watt uit te geven voor het gebruik van het toetsenbord.

Problematische vermogensmetingen – Geladen met draaiende roest (spun-down)

Zoals in het begin vermeld, begon ik met 12 harde schijven. De helft was 2,5″ en de andere helft was 3,5″. Omdat het moederbord slechts 4 SATA-poorten heeft, werden een SATA-controller en een poortvermenigvuldiger gebruikt om de resterende schijven aan te kunnen. Daarnaast werden er al vroeg 4 NVMe-schijven gebruikt: één daarvan, een Western Digital SN770, had de neiging om behoorlijk heet te worden, zelfs in ruststand, wat aangeeft dat deze waarschijnlijk niet in een spaarstand stond.

Met alle apparatuur aangesloten, in ruststand, met het beeldscherm uit en de 12 schijven gedraaid naar stand-by, was ik geschokt toen ik zag dat mijn stroomverbruik in ruststand was gestegen van 7 watt naar maar liefst 24-25 watt. Veel te veel! Er was iets mis.

Vermogensverbruikraadsels – Onderzoek en diagnose van hoog energieverbruik

Ik koppelde de harde schijven los en begon componenten één voor één te testen. Dit waren vrij ruwe tests die bedoeld waren om een ruw idee te krijgen van de boosdoener, dus de getallen hier zijn niet precies.

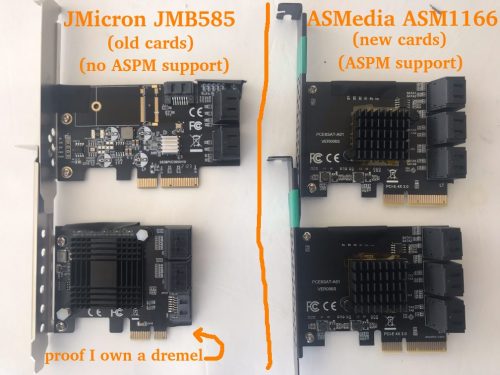

Ik ontdekte al snel dat de JMB585 SATA-controller die ik gebruikte het stroomverbruik deed toenemen met iets in de orde van 6-10 watt (precieze metingen in een later gedeelte). De controller zelf zou maar een paar watt moeten verbruiken en het kleine koellichaam bleef koel, dus er was duidelijk meer aan de hand. Waar ging het vermogen naartoe?

Ik besloot de C-states van het CPU-pakket te bekijken. Zonder de JMB585 SATA-controller bereikte het systeem C6. Toen de JMB585 weer was aangesloten, haalde het systeem maximaal C3. Maar waarom? Het blijkt dat als een PCIE-apparaat niet in ASPM L1 gaat, de CPU niet zo diep in slaap valt. De JMB585 controllerkaarten lijken geen ASPM ondersteuning te hebben.

Een beetje verder experimenteren onthulde iets anders dat ik nog niet wist, en het heeft te maken met C6 vs C8. Het systeem zal alleen op C8 drukken als er niets is aangesloten op de CPU-gekoppelde PCIE lanes. Met andere woorden, als er iets is aangesloten op het bovenste PCIE-slot of het bovenste NVMe-slot, is C6 het maximum. Het verschil in stroomverbruik tussen C6 en C8 *leek* minder dan een watt te zijn in een eenvoudige test.

Dus terwijl C8 een luxe zou zijn, was C6 een must. C3 gebruikt te veel stroom. Als SATA controllers zouden voorkomen dat de CPU de beste energiebesparende stand zou bereiken, begon ik me af te vragen of ik niet beter op zoek had moeten gaan naar een moederbord met 6-8 SATA poorten, zodat ik niet afhankelijk zou zijn van extra controllers…

Een beetje zoeken naar SATA HBA’s toonde aan dat, hoewel er hier niet veel opties zijn, de ASM1166 SATA controller ASPM L1 zou moeten ondersteunen, hoewel de firmware moet worden geflasht om het goed te laten werken (en om überhaupt te werken op nieuwere Intel borden). Dit was iets dat ik zou moeten bestellen: Ik heb Marvel en JMicron onderdelen, maar die ondersteunen geen ASPM. Ik had ASMedia eigenlijk al jaren vermeden, maar uit noodzaak kregen ze nu een nieuwe kans: Ik heb een paar ASM1166 6-poorts SATA-controllers besteld.

Afgezien: BadTLP, Bad! AER Busfouten van de pcieport

Het vermelden waard… Tijdens initiële tests met een WD Black SN770 (Gen4 NVMe), vond ik een probleem wanneer de primaire (bovenste CPU-attached) PCIE en NVMe poorten werden gebruikt. Het uitvoeren van dmesg resulteerde in uitvoer vol met dingen zoals:

pcieport 0000:00:06.0: AER: Gecorrigeerde fout ontvangen: 0000:02:00.0

nvme 0000:02:00.0: PCIe-busfout: severity=Corrected, type=Physical Layer, (ontvanger-ID)

pcieport 0000:00:06.0: PCIe-busfout: severity=Gecorrigeerd, type=Data Link Layer, (Zender-ID)

pcieport 0000:00:06.0: AER: Fout van deze agent wordt als eerste gemeld

nvme 0000:02:00.0: [ 6] BadTLP

…na veel trial-and-error ontdekte ik dat als de “PEG – ASPM” BIOS instelling op [Disabled] of [L0s] stond, er geen fouten optraden.

Dit was natuurlijk een slechte optie, aangezien [L1] cruciaal is voor energiebesparing. Als [L1] of [L0sL1] werden gebruikt, was de enige optie om de Link Speed van die poorten in te stellen op [Gen3], wat de fouten niet stopte, maar wel aanzienlijk verminderde.

Enig onderzoek wees uit dat de hoofdoorzaak een aantal dingen kan zijn. Omdat het vervangen van het moederbord of de CPU geen prettige gedachte was, was mijn beste hoop om over te stappen op een ander merk NVMe.

Ik bestelde een aantal Crucial P3 NVMe drives. Dit bleek een succesvolle poging te zijn: met de WD schijven vervangen door de Crucial schijven, kreeg ik geen fouten meer, maar vergeet niet dat dit Gen3 schijven zijn.

Power Consumption Puzzles – L1.1 en L1.2 alleen ingeschakeld op chipset-verbonden poorten

Toen ik de 2 Crucial P3 NVMe drives geïnstalleerd had in de CPU-connected PCIEx16 slot en de bovenste M2 slot, merkte ik hogere idle temps dan verwacht. Terwijl de NAND op ongeveer 27-29C zat, rapporteerden de controllers 49-50C – veel hoger dan ik had verwacht voor deze specifieke schijven.

Ik verplaatste de schijf van de PCIEx16-sleuf naar een chipset-verbonden PCIEx4-sleuf. Een interessant verschil tussen deze schijven werd zichtbaar via lspci -vvv:

CPU-connected M2 slot: L1SubCtl1: PCI-PM_L1.2- PCI-PM_L1.1- ASPM_L1.2- ASPM_L1.1-

Chipset-verbonden PCIE-sleuf: L1SubCtl1: PCI-PM_L1.2+ PCI-PM_L1.1+ ASPM_L1.2+ ASPM_L1.1+

L1 sub-states lijken alleen ingeschakeld te worden op de chipset-verbonden slots. Jammer, maar het lijkt overeen te komen met de beschikbare BIOS-instellingen in de schermafbeelding hierboven.

Laten we nog eens naar die afbeelding van het moederbord verwijzen om de situatie te laten zien:

Ik heb beide NVMe drives op chipset-verbonden PCIE slots gezet. Nu toonden beide L1.1+/L1.2+ en beide controller-temperaturen daalden van 49-50C naar 38-41C.

Helaas zag ik bij het uitvoeren van verschillende A/B-tests met deze 2 Crucial NVMe-schijven met verschillende slotconfiguraties en verschillende BIOS-instellingen zeer inconsistent gedrag op het gebied van temperatuur, hoewel het de moeite waard is om op te merken dat de JMB585 en een NVMe-opstartschijf ook waren aangesloten tijdens deze tests. Beide schijven konden bijvoorbeeld stationair rond de 40C draaien tot een zachte herstart, waarna 1 (of beide) nu stationair rond de 50C kon draaien. Soms leek het mogelijk om 1 schijf op de CPU-gekoppelde M.2 te houden en de temperatuur van 40C op beide schijven te behouden zolang het x16-slot niet bezet was. Vermoedelijk liep ik tegen een of andere bug aan. De Samsung boot NVMe leek een consistente idle temperatuur te behouden ongeacht wat er gebeurde met de Crucial NVMe schijven, dus ik vermoedde dat de Crucial schijven zelf tenminste gedeeltelijk schuldig waren.

Interessant genoeg daalde de temperatuur van één (of beide) controllers soms helemaal tot 29C op de chipset-verbonden slots. Aangezien het geen realistisch doel was om een energiezuinige 4TB NVMe vervanger voor de Crucial P3 te vinden, was mijn beste hoop op dit moment dat de ASPM-incompatibele JMicron JMB 585 op de een of andere manier de schuldige was, aangezien deze binnenkort zou worden vervangen door de ASPM-compatibele ASMedia ASM 1166.

Late update: Helaas heb ik de temperaturen niet bijgehouden tijdens de rest van het testen, en de koellichamen/luchtstroom tussen de schijven zijn allemaal door elkaar gegooid. Maar voor wat het waard is, in de uiteindelijke build zijn de temperaturen van mijn Crucial P3-controller 31-34C en de NAND-temperaturen 23-24C.

Power Consumption Puzzles – Overstappen van de JMB585 naar de ASM1166.

Na een paar weken arriveerde de ASM1166. Eerst een paar dingen over de kaart die je misschien handig vindt als je het overweegt…

Ik begon met een firmware flash – ASM1166 kaarten hebben vaak oude firmware die niet werkt met Intel 600-serie moederborden en van wat ik heb begrepen problemen kan hebben met energiebeheer. Nieuwere firmware kan op verschillende plaatsen gevonden worden, maar ik besloot een kopie van SilverStone te halen (“fix compatibility issue” in de Download sectie van https://www.silverstonetek.com/en/product/info/expansion-cards/ECS06/) en volgde de instructies op https://docs.phil-barker.com/posts/upgrading-ASM1166-firmware-for-unraid/ . Merk op dat de SilverStone bestanden een identieke MD5 hadden als de firmware die ik vond door de thread te volgen op https://forums.unraid.net/topic/102010-recommended-controllers-for-unraid/page/8/#comment-1185707 .

Voor iedereen die van plan is een van deze ASMedia-kaarten te kopen, moet ik opmerken dat net als bij de meeste SATA-controllers en HBA’s de kwaliteit erg varieert. Een van mijn kaarten had een heatsink die er een beetje scheef op zat: het thermische pad was dik genoeg om te voorkomen dat het kortsluiting zou maken met nabijgelegen componenten, maar wees je ervan bewust dat deze producten echt hit-and-miss kunnen zijn. Dit is een van de situaties waarin iets meer betalen om ergens te kopen met een goed retourbeleid verstandig kan zijn.

Ik heb nogal wat A/B-testen gedaan, dus hier is een snelle “JMicron JMB585 vs ASMedia ASM1166” in termen van totaal energieverbruik van het systeem, hoewel het misschien alleen van toepassing is op dit platform (of misschien zelfs dit specifieke moederbord).

DRIVELESS

Eerst het stroomverbruik zonder drives aangesloten op de kaarten (de SATA SSD boot drive is aangesloten op het moederbord) om een basislijn te krijgen. PowerTOP gebruikt op alle apparaten behalve het toetsenbord (+1 watt toegevoegd). Metingen nadat de schermuitvoer in de slaapstand was gezet.

- 8 watt – Geen SATA-controller – C8 voedingstoestand

- 9 watt – ASM1166 op een chipset-verbonden x4 slot – C8 voedingstoestand

- 12 watt – JMB585 op de CPU-connected x16-sleuf – C3 voedingstoestand

- 15 watt – JMB585 op een chipset-verbonden x4-sleuf – C3 voedingstoestand

- 22 watt – ASM1166 op de CPU-connected x16-sleuf – C2 voedingstoestand

De ASM1166 doet het hier goed als hij is aangesloten op een chipset-verbonden slot (slechts +1 watt), maar doet het verschrikkelijk als hij is aangesloten op het hoofd PCI-E slot (+14 watt) waar de vermogenstoestand van het CPU-pakket keldert naar C2. Schokkend genoeg gedraagt de JMB585 zich op een tegenovergestelde manier waar het verbruik lager is op de CPU-connected slot (en het veroorzaakte geen C2) – je zult echter snel zien dat de dingen veranderen wanneer drives daadwerkelijk worden aangesloten…

Ik heb aanvullende tests gedaan met de controllers, waaronder het spelen van “stoelendans” met een paar NVMe schijven om te zien of meerdere apparaten roet in het eten zouden gooien, maar er gebeurde niets onverwachts dus ik zal die details overslaan.

DRIVES TOEVOEGEN

Na de nulmetingen was het tijd om schijven op deze controllers te plaatsen. De SATA SSD boot drive bleef op het moederbord, 2 NVMe drives werden toegevoegd aan de mix (chipset-gekoppeld tenzij anders vermeld), en 4 van de 2,5″ SATA harde schijven werden op de controller geplaatst. Ik zal het “gedraaide” verbruik weergeven nadat de harde schijven in stand-by gingen – “gedraaid” was precies 2 watt hoger in elke test terwijl de schijven inactief waren.

- 10 watt – ASM1166 op een chipset-verbonden x4 slot – C8 voedingstoestand

- 11 watt – ASM1166 op een chipset-verbonden x4-sleuf met 1 NVMe verplaatst naar de CPU-verbonden x16-sleuf – C6 vermogenstoestand

- 11 watt – 2x ASM1166 op chipset-verbonden x4-slots, met slechts 1 NVMe-schijf – C8 vermogenstoestand

- 16 watt – JMB585 op een chipset aangesloten x4 slot – C3 vermogenstoestand

- 24 watt – JMB585 op een CPU-verbonden x16-sleuf – C2 voedingstoestand

Met 4 schijven aangesloten via een chipset-sleuf voegt de ASM1166 +2 watt toe aan het systeemverbruik, terwijl de JMB585 +8 watt toevoegt. Geen wedstrijd.

Een bijkomend voordeel is dat ik beide ASM1166 kaarten in het systeem kon gebruiken, terwijl een poging om mijn JMB575 kaarten tegelijkertijd te gebruiken resulteerde in een systeem dat weigerde op te starten, hoewel dat een platform- of moederbord-specifiek probleem kan zijn.

Er is echter wel een afweging – ik heb de JMB585 altijd rotsvast betrouwbaar gevonden, ook in combinatie met een JMB575 poortvermenigvuldiger. Mijn eerdere ervaringen met ASMedia SATA controllers waren minder dan geweldig: betrouwbaarheid met de ASM1166 valt nog te bezien, maar het is op zijn minst een slechte kandidaat voor een poortvermenigvuldiger omdat het geen FBS ondersteunt (alleen CBS).

Een paar andere kleine problemen met de ASM1166:

- Bij het verwijderen/terugplaatsen van de NVMe-opstartschijf verscheen er een BIOS-bericht dat beweerde dat er niet kon worden opgestart vanwege GPT-corruptie. De ASM1166-kaarten moesten tijdelijk worden verwijderd zodat het BIOS de NVMe-opstartschijf opnieuw kon “vinden” (waarna ze opnieuw konden worden geïnstalleerd).

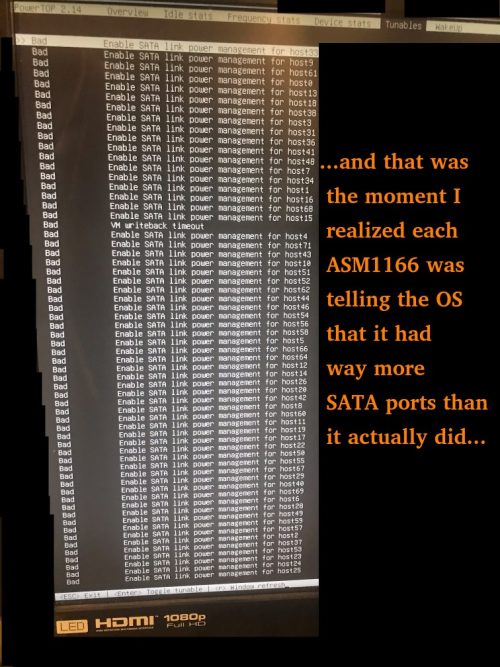

- De ASM1166-kaarten beweren een *veel* poorten te hebben – dit veroorzaakt extra opstarttijd omdat Linux ze allemaal moet doorlopen.

Update: SATA en SSD merken

Een van de opmerkingen noemde een oudere Samsung 840 PRO SSD die beperkt was tot C3, terwijl een Crucial Force GT SSD C8 toestond. Hoewel dit oudere schijven zijn, vond ik dit toch een beetje verrassend. Het was het onderzoeken waard.

Ik gebruikte de H770 als testbed met een Samsung 850 EVO SATA SSD boot drive samen met een Crucial P3 NVMe en bouwde een aangepaste kernel om de Realtek netwerkadapter L1.2 te laten bereiken. Geen ASM1166, alleen de Intel onboard SATA. Ik bereikte C10 nadat ik powertop met auto-tune had uitgevoerd en het beeldscherm had laten slapen. Ik heb verschillende schijven geprobeerd die ik bij me heb, waarbij ik het systeem telkens uitschakelde om de schijven te verwisselen en het proces te herhalen. Dit waren de resultaten.

Schijven waarbij het systeem vastliep op C6:

- 1TB Patriot P210 SATA SSD

Schijven die C10 toestonden:

- 500GB Samsung 850 EVO SATA SSD

- 4TB 2,5″ Seagate SATA HDD

- 8TB 3,5″ Seagate SATA HDD

- 14TB Toshiba SATA HDD

- 1TB Sandisk Ultra 3D SATA SSD

- 4TB Sandisk Ultra 3D SATA SSD (let op: langzame trim)

- 4TB Crucial MX500

Ik raad aan voorzichtig te zijn met het kiezen van SATA SSD merken en modellen. Ik zal proberen deze lijst bij te werken met schijven die ik heb getest, maar houd in gedachten dat bepaalde fabrikanten in de opslagruimte de neiging hebben om stilletjes over te stappen op inferieure onderdelen in sommige van hun hoofdproducten, dus je moet altijd de geclaimde prestatiegegevens controleren van opslagapparaten die je koopt terwijl je binnen je retourtermijn blijft. Laat gerust een reactie achter met goede/slechte schijven die je tegenkomt.

Vermogensverbruikpuzzels – Conclusie

Een paar belangrijke punten als je een laag verbruik nastreeft:

1) Moederbordondersteuning en BIOS-configuratie zijn cruciaal – ik heb moederborden gehad met zeer inflexibele BIOS’en. Op deze moeten “Native ASPM” en de juiste L1 toestanden ingeschakeld zijn (om OS-gestuurd in plaats van BIOS-gestuurd mogelijk te maken) om laag stroomverbruik te laten werken.

2) Alle apparaten moeten ASPM L1 ondersteunen. Anders gooi je echt met de dobbelsteen. Het moeilijkste deel hier is, zoals je misschien al geraden had, het vinden van SATA-controllers die het ondersteunen – als het mogelijk is, neem dan een moederbord met voldoende SATA-poorten die met Intel-chipsets verbonden zijn, zodat je geen aparte kaart nodig hebt. Ik moet hierbij opmerken dat het niet altijd vanzelfsprekend is om NVMe-schijven te vinden met werkende energiezuinige APST-status onder ASPM.

3) Als je de C8 energiestatus kunt bereiken, vermijd dan het gebruik van CPU-attached PCIe lanes (top PCIe en M2 slot). Op dit specifieke moederbord zou mijn advies zijn om ze helemaal te vermijden als je kunt, tenzij je ofwel het low-latency pad met volledige bandbreedte naar de CPU nodig hebt of je apparaten zo actief zijn dat ze toch nooit slapen. Onthoud dat zowel mijn JMicron als ASMedia SATA kaarten ervoor zorgden dat het CPU pakket C-status kelderde naar C2 als ze in het x16 PCI-E slot werden gestoken.

4) Stroom meten uit de muur is de enige manier om er zeker van te zijn dat wat je *denkt* dat er gebeurt ook echt gebeurt. Een Kill-A-Watt apparaat betaalt zichzelf na verloop van tijd terug als je het gebruikt – bedenk dat ik de mijne in 2006 kocht ($16USD + $14USD verzendkosten destijds via eBay). Op dat moment ontdekte ik dat ons zelden gebruikte faxapparaat, dat altijd aan stond, 7 watt verbruikte… Door dat ene apparaat uit te schakelen wanneer het niet werd gebruikt in de volgende 10 jaar, was de Kill-A-Watt meer dan terugverdiend.

Vermogensverbruik bij gebruik van een heleboel HDD’s

Nu er tijdens dit proces verschillende onderdelen in en uit het systeem zijn gegaan, ziet de huidige opstelling er als volgt uit:

- 1x Samsung 970 EVO Plus NVMe (500GB opstartschijf)

- 2x Crucial P3 NVMe (4TB elk)

- 5x Seagate 2,5″ HDD (elk 5TB – 4TB gebruikt)

- 6x Seagate 3,5″ HDD (elk 10 TB – 8 TB gebruikt)

- 2x ASM1166-kaarten met SATA-poorten

Totaal vermogen gemeten vanaf de muur (beeldscherm aan, toetsenbord ingeschakeld):

- 50 watt met alle 11 HDD’s in actieve ruststand

- 38 watt met de 6x 3,5″ HDD in Idle B

- 34 watt met de 6x 3,5″ HDD in Idle C

- 21 watt met de 6x 3,5″ HDD in stand-by_Z (uitgeschakeld)

- 18 watt met de 5x 2,5″ HDD ALS in stand-by

- 16 watt met de schermuitvoer ALSO uit

- 15 watt als PowerTOP het USB-toetsenbord mag uitschakelen

Seagate schat het stand-byverbruik van deze 3,5″ schijven op ongeveer 0,8 W per stuk, en de 2,5″ schijven op ongeveer 0,18 W per stuk. Dit komt overeen met wat ik hierboven zie. Mijn cijfers voor actief stationair gebruik komen ook vrij goed overeen met de specificaties van Seagate.

De voor de hand liggende constatering: vergeleken met de rest van de systeemcomponenten zijn de 3,5″ schijven energievretende monsters.

De HDD’s zullen uiteindelijk worden vervangen door SSD’s. Met een stationair verbruik dat zo laag is als tijdens HDD-standby, is er geen grote haast en dit proces zal geleidelijk plaatsvinden naarmate mijn HDD-schijven/spares vervallen en de SSD-prijzen zakken.

Het plan voor het “eindspel” is een volledig SSD-opbouw. Oorspronkelijk was het plan voor 1 opstartschijf, 6xNVMe (waarschijnlijk Crucial P3 4TB) voor een RAIDZ2 array, en 6xSATA (waarschijnlijk Samsung 870 QVO 8TB) voor de 2e RAIDZ2 array. Aangezien het gebruik van de CPU-verbonden M2/PCIe-slots niet alleen onvoorspelbaarheid met zich meebrengt, maar ook een lichte C-state/vermogen/temperatuur kost, zou ik dat plan kunnen wijzigen en een paar NVMe in de eerste array opgeven en in plaats daarvan SATA gebruiken zodat ik geen CPU-verbonden lanes hoef aan te raken. De tijd zal het leren.

Onnodige opslagdetails

Dit gedeelte is alleen de moeite waard om te lezen als je geïnteresseerd bent in gedetailleerde details over de opslag. Sla anders gerust over naar de laatste sectie.

NVMe opstartschijf

Zoals eerder vermeld, is dit een Samsung 970 EVO Plus. Momenteel wordt minder dan 4GB van de 500GB ruimte gebruikt (een swappartitie van 64GB bestaat, maar staat altijd op 0 gebruikt). Deze schijf werd oorspronkelijk gekozen omdat Samsung een reputatie had opgebouwd op het gebied van betrouwbaarheid (die de laatste tijd aan het afnemen is), en Samsung scoorde ook goed in reviews als het ging om stroomverbruik in ruststand. Deze schijf is bijna altijd inactief en zowel de controller als de NAND-temperaturen bleven laag tijdens alle tests (20-24C). Mogelijk wordt deze schijf uiteindelijk vervangen door een SATA SSD om een NVMe-poort vrij te maken.

2,5″ HDD

Deze schijven worden gebruikt voor de primaire ZFS RAIDZ2-array met 6 schijven – degene die het meest wordt gebruikt. Eén dag per week is deze bezig met een taak waarbij een paar TB gelezen moet worden in de loop van 24 uur. De rest van de week is het gebruik sporadisch en de schijven staan het grootste deel van de week stil. Voor iedereen die zich afvraagt waarom er kleine 2,5″ schijven worden gebruikt in plaats van 3,5″ schijven, er *is* een reden: stroomverbruik.

Het energieverbruik van de 2,5″ Seagate-schijven is eerlijk gezegd prettig indrukwekkend. Uitgeschakeld zijn ze elk goed voor 0,18 W, in inactieve toestand met laag stroomverbruik zijn ze goed voor 0,85 W en de lees/schrijfgemiddelden zijn goed voor ongeveer 2 W. Er zijn genoeg SSD’s met slechtere energieverbruikscijfers dan deze draaiende roest. De capaciteit van 5 TB geeft veel opslag per watt.

De belangrijkste nadelen van deze 2,5″ Seagate schijven zijn:

- Geen geweldige prestaties. 80-120 MB/s piek bij lezen/schrijven. Maar om eerlijk te zijn, veel TLC/QLC SSD’s vallen terug naar deze schrijfniveaus wanneer hun SLC-cache is uitgeput.

- SMR (Shingled Magnetic Recording). Leest prima, maar de schrijfprestaties storten absoluut in wanneer er willekeurig wordt geschreven – het gedraagt zich als een QLC SSD zonder SLC-cache die ook geen TRIM heeft.

- Lage nominale werkbelasting (55TB/jaar vs 550TB/jaar voor 3,5″ Exos-schijven).

- Geen configureerbare fouthersteltijd (SCT ERC), en deze schijven kunnen minutenlang hangen als ze een foutmelding krijgen terwijl ze meedogenloos proberen de problematische sector opnieuw te lezen. Ubuntu moet worden geconfigureerd om te wachten in plaats van te proberen de schijf na 30 seconden te resetten.

- Hogere foutpercentages als ze warm worden (ik heb er een paar moeten vervangen en heb ontdekt dat ze er niet van houden om warm te worden).

- Typische HDD-pijnpunten (langzaam opstarten, enz.).

Om helemaal eerlijk te zijn tegen Seagate, deze worden verkocht als externe USB-back-upschijven. Deze 15 mm grote schijven uit de behuizingen halen en ze gebruiken als RAID-leden in een NAS is niet echt gebruiken waarvoor ze bedoeld zijn. Het ultralage energieverbruik is geweldig, maar er zijn duidelijke nadelen.

Op de lange termijn zullen deze 2,5″ 4/5TB schijven langzaam worden vervangen door 4TB SSD schijven (mogelijk allemaal NVMe). SSD’s met een capaciteit van 4 TB begonnen in 2021/2022 beschikbaar te komen voor consumenten tegen ongeveer 4-5x de kosten van de spinners. Minder dan 2 jaar later zijn ze gedaald tot ongeveer 2x de kosten, en ik verwacht dat fatsoenlijke merken meer dan 2x zo lang meegaan als de Seagate spinners.

Als het Crucial P3-model (Gen3) beschikbaar blijft, zal ik waarschijnlijk voor dit model kiezen, ondanks de beperking tot Gen3-snelheden. Ik heb de Crucial P3 Plus (Gen4) sterk overwogen, maar het stroomverbruik in de reviews was hoger ondanks het feit dat er maar weinig situaties waren waarin de prestaties ook merkbaar hoger waren. Mijn grootste zorg met de P3 Plus (Gen4) was dat als ik problemen had met ASPM/APST, Tom’s Hardware liet zien dat de P3 (Gen3) voor het 2TB model 0,3w meer stroom verbruikt in rust dan de P3 (Gen3). Ik geef de voorkeur aan een zo laag mogelijk “in het ergste geval”.

3,5″ HDD

Gebruikt in de secundaire RAIDZ2-array met 6 schijven – een back-uparray die ongeveer 2 uur per week wordt opgestart en constant zware schrijfbewerkingen krijgt.

Het stroomverbruik van de 3,5″ Seagate-schijven is ongeveer wat je zou verwachten. Deze 10TB schijven verbruiken elk ongeveer 0,8 W in stand-by, 2-5 W inactief en 6-9 W lezen en schrijven.

Twee punten van zorg hier:

- Deze schijven verbruiken samen ongeveer 45-50 watt tijdens het schrijven. Dat is een beetje extra UPS-belasting die ik niet echt wil als er een langdurige stroomstoring optreedt tijdens de back-ups (ik houd het bij consumenten-UPS’en van 1500 watt).

- Deze mogen samen ongeveer 4,8 watt trekken in stand-by. Nogmaals, wat UPS-belasting die ik er graag af zou willen halen.

Op de lange termijn zullen deze schijven waarschijnlijk worden vervangen door Samsung 870 QVO 8TB SATA-schijven. De 870 QVO heeft 0,041w/0,046w idle met ALPM, 0,224w/0,229w idle zonder, en 2,0-2,7w tijdens een kopie (volgens Toms/Anandtech).

Qua prijs is de Samsung 8TB SATA SSD momenteel een stuk duurder dan 8TB spinners (bijna 3x zo duur), dus tenzij deze schijven om de een of andere reden vaker gebruikt gaan worden, zal vervanging door de SSD’s vrijwel zeker wachten tot ik geen reserve meer heb.

NVMe cachestation

Het vervangen van mijn draaiende roest door SSD’s is een proces dat waarschijnlijk een tijdje zal duren.

In de tussentijd heeft ZFS een paar opties om gebruik te maken van snelle opslag (meestal SSD) voor langzamere opslag:

- “Speciale” Toewijzingsklasse – hiermee kun je een vdev maken speciaal voor metadata en voor “kleine” blokken indien gewenst.

- Een cache schijf, algemeen bekend als een L2ARC.

Als je de “speciale” vdev aanmaakt bij het aanmaken van een pool, gaan al je metadata (en optioneel kleine blokken van een grootte die je zelf kiest) naar de “speciale” vdev in plaats van je draaiende roest. Zeer snelle bestandsoverzichten en directory traversal terwijl je de draaiende rust behoudt voor de bestanden zelf. Ja, je kunt een heleboel mappen “ls-en” zonder je HDD’s uit de slaapstand te halen. Het grootste nadeel is dat, omdat al je metadata op deze vdev staat, als deze ooit sterft, je in wezen geen toegang meer hebt tot al je gegevens. Dus het zou op zijn minst gespiegeld moeten zijn. Misschien zelfs een 3-weg mirror. Zeg maar dag tegen een paar poorten.

De L2ARC is een beetje anders. Het is in wezen een niveau 2 cache. Wanneer de cache in RAM vol raakt, zal ZFS enkele blokken naar de L2ARC kopiëren voordat het die inhoud uit het RAM verwijdert. De volgende keer dat die gegevens moeten worden opgeroepen, worden ze gelezen van de L2ARC in plaats van de schijf. Een voordeel ten opzichte van de “speciale” vdev is dat je goed zit met slechts 1 SSD – als er een probleem is met de gegevens in de L2ARC (slechte checksum, schijf sterft, enz.), zal ZFS gewoon de inhoud van de originele schijf lezen. Ook, zodra de L2ARC vol is, zal ZFS gewoon opnieuw beginnen bij het begin van de L2ARC SSD en dingen overschrijven die het eerder schreef, wat een aantal voordelen heeft (oude gegevens worden nooit meer benaderd) en nadelen (gegevens die vaak werden benaderd en opnieuw naar de L2ARC moeten worden geschreven). Je kunt ook naar believen L2ARC-apparaten toevoegen aan of verwijderen uit de pool – wil je een SSD van 64 GB, een SSD van 500 GB en een SSD van 2 TB toevoegen? Ga je gang – ZFS verdeelt de blokken onder hen. Wil je de 500GB SSD een paar dagen later uit de pool halen en ergens anders gebruiken? Ga je gang. Het grootste nadeel van de L2ARC is dat als je vergeet om “cache” te specificeren bij het toevoegen van het apparaat, je waarschijnlijk je pool verknoeid hebt. Het is ook niet perfect: zelfs met zorgvuldige tuning is het moeilijk om ZFS ALLES wat je wilt naar de L2ARC te laten schrijven voordat het uit het geheugen wordt verwijderd. Tegelijkertijd kan de L2ARC, afhankelijk van je gegevens, veel schrijfbewerkingen te zien krijgen en moet je de gezondheid van je SSD goed in de gaten houden.

In het verleden heb ik de “special” gebruikt, L2ARC gebruikt en beide tegelijkertijd gebruikt (je kunt de L2ARC zelfs vertellen om dingen die al in de “special” vdev zitten niet te cachen).

Deze keer heb ik gewoon gekozen voor een L2ARC op een 4TB NVMe: zodra alle andere 2,5″ schijven zijn vervangen door SSD en de snelheidsvoordelen van een SSD cache niet langer van toepassing zijn, kan ik dit cache-apparaat gewoon verwijderen (hoewel theoretisch gezien het feit dat 1 L2ARC cache-schijf het grootste deel van de leestaken afhandelt *zou* toestaan dat de andere NVMe schijven meer in de spaarstand blijven…).

Conclusie – Spijt? Second-guessing? Wat had anders gekund?

In tegenstelling tot de ASRock J4005 build waar ik me halverwege realiseerde dat ik mezelf op een aantal manieren in de knieën had gewerkt, krijg ik hier niet hetzelfde gevoel. Deze keer eindigde ik met een laag stationair vermogen EN een behoorlijk capabel systeem dat flexibel zou moeten zijn, zelfs als het in de toekomst hergebruikt wordt.

Ik ben best tevreden met mijn componentkeuzes, hoewel ik benieuwd ben hoe de MSI PRO Z790-P DDR4 (een van de andere moederborden die ik heb overwogen) het in vergelijking zou doen. Functioneel gezien heeft de MSI het voordeel van 6xSATA poorten, maar het komt met het duidelijke nadeel van de beruchte Intel 2.5G netwerkchip. De MSI heeft ook een PS/2 poort en ik heb nog nooit gecontroleerd of het stroomverbruik van een PS/2 toetsenbord lager is dan USB (onthoud dat ik 1 watt bespaar als ik powertop de USB toetsenbordpoort laat afsluiten). En natuurlijk zou het interessant zijn om de ASPM en ALPM instellingen te vergelijken en om te zien of de problemen die ik had met CPU-attached PCIe/M.2 slots op dezelfde manier voorkomen.

Terwijl dit systeem momenteel in het 15-16 watt bereik zit wanneer het niet gebruikt wordt met schijven in standby, verwacht ik, zodra alle HDD’s vervangen zijn door SSD’s, een stationair verbruik van ongeveer 10-11 watt, wat niet slecht is voor 72TB aan schijven, 64GB RAM en een behoorlijk goede processor.

Update: Recente Linux kernels schakelen de L1 energiebesparende modi van de meeste Realtek NIC’s uit, waardoor de CPU niet in fatsoenlijke C-states kan komen, waardoor het stroomverbruik behoorlijk toeneemt. Hoewel er workarounds zijn, zal ik me in de toekomst waarschijnlijk beperken tot moederborden met Intel 1 Gigabit netwerkadapters (misschien overgaan op Intel 2,5 Gigabit als het duidelijk wordt dat ze alle problemen hebben opgelost). Meer details over de Realtek NIC situatie vind je in de commentaren hieronder. Het script dat ik diep in de commentaren noem, is te vinden op: RTL8125-ASPM.sh.txt .

Ik denk dat je een hoop hoofdpijn had kunnen voorkomen als je een bord had gevonden met meer sata-poorten!

Bij mij is het nooit gelukt om mijn chip verder dan C3 te krijgen. Ik heb met opzet geprobeerd om de hoeveelheid overtollige componenten te beperken (zoals die SATA-controllers, ik had gelezen over hoe hit and miss ze konden zijn).

Ik zal mijn BIOS-instellingen dubbel controleren om er zeker van te zijn dat ik alle relevante dingen heb ingeschakeld die je in je stuk noemt.

Zeer interessant artikel, bedankt.

Dus je geeft niets om ECC, sommigen zeggen dat het een must is voor een always on server, vooral met ZFS.

NVME's lijken ook meer brandstof te verbruiken dan SSD's.

Ik ben op zoek naar een zuinig ECC moederbord maar heb nog niets gevonden, W680 moederborden zijn moeilijk te krijgen.

Ondertussen draai ik Unraid op een J5040 Asrock bord met twee 1TB SSD's in mirror en 3 mechanische WD's die het grootste deel van de tijd slapen.

Het systeem verbruikt 19 watt in ruststand, het was 16-17 watt (C6) voordat ik een Asmedia Controller (4) toevoegde. Ik zal de oude seasonic PSU binnenkort vervangen door een Corsair.

Groeten

Geert

Houd er rekening mee dat als het 2e M.2 slot is gevuld, slechts 5 van de 6 SATA poorten zullen werken. Als ik het me goed herinner verborg het BIOS van de H470M DS3H ook een paar opties (zoals het forceren van IGPU of dedicated GPU) tenzij het in CSM-modus werd gezet. Bovendien bleef hij willekeurig hangen op het opstartscherm met een foutmelding als ik een LSI SAS HBA had geïnstalleerd, waardoor ik opnieuw moest proberen op te starten - gewone SATA controllers werkten echter prima. Afgezien van deze rare kleine nuances, vond ik het betrouwbaar en het werkte geweldig en ik hou van het bord.

Ben je van plan om een soortgelijk artikel te publiceren, maar dan voor een systeem met ECC ondersteuning en een laag idle stroomverbruik dat nog steeds compatibel zou zijn met Linux (ik denk dat een laag idle stroomverbruik van AMD niet het beste is voor Linux als voorbeeld).

Ik ben van plan om binnenkort zelf zo'n systeem te bouwen en ik zou graag willen weten of ik daar de komende maand of twee mee moet beginnen, of dat ik misschien nog even moet wachten met het lezen van uw publicaties, die een aantal nuttige informatieve sites zouden bevatten die me kunnen helpen om een beter onderbouwde beslissing te nemen over de keuze van de componenten.

Desalniettemin hartelijk dank voor het grondig geschreven artikel. Je hebt indrukwekkend werk geleverd door de belangrijke onderdelen van het bouwen van een zeer efficiënte NAS met laag stroomverbruik te belichten.

In ieder geval veel succes met je bouw!

Bedankt voor je zeer gedetailleerde en informatieve artikelen over NAS!

Ik bouw de mijne met een i3-10500T, 16GB en 4xHDD.

Wat betreft de voeding, ik vond een Antec EarthWatts 380W EA-380D (80+ Bronze) gereviseerd voor 25€. Is het het waard volgens jou? Of is het te oud?

Als je een ander model kunt aanbevelen, ben ik geïnteresseerd. Alvast bedankt.

Ik heb ook een 970 Evo Plus (2TB) als opstartschijf en kan bevestigen dat deze op de chipset moet worden aangesloten om C-states met een laag pakket (C8) te bereiken. Wat ik interessant vond is dat het verschil tussen pakket C3 en C8 veel groter was wanneer de SSD was aangesloten op de chipset. Ik denk dat dit komt omdat de chipset zelf alleen in diepe slaaptoestanden gaat als alle aangesloten apparaten ASPM ondersteunen en SATA Link Power Management actief is.

Het aansluiten van de SSD op de CPU PCIe verhoogde het stroomverbruik met slechts ~2W (pakket C3 vs C8), terwijl het niet hebben van ASPM op een apparaat dat is aangesloten op de chipset alleen al voor de chipset 5W extra lijkt te kosten, maar hetzelfde effect heeft (C3) op het pakket C-state.

Interessant om op te merken is dat ik een PCIe 1.1 DVB-C Capture kaart op de chipset heb aangesloten. Hoewel ASPM door lspci wordt vermeld als een mogelijkheid voor de kaart en ik de kernel opstartte met pcie_aspm=force werd het niet ingeschakeld voor die kaart. Ik moest ASPM forceren via setpci, zie https://wireless.wiki.kernel.org/en/users/documentation/aspm - lijkt zonder problemen te werken. Dat hielp me om die 15W idle power te bereiken. Helaas neemt de capture kaart nog steeds ~5W, anders heb ik op dit moment alleen 2x4TB HDD's van Toshiba aangesloten die in ruststand terugspoelen.

Btw. Sata Hot Plug moet worden uitgeschakeld voor alle poorten, anders zal het pakket alleen C6 bereiken.

1) het lijkt erop dat het beter is om een CPU te gebruiken met een geïntegreerde GPU, tenzij het moederbord opstarten zonder GPU ondersteunt. Ik was van plan om het stroomverbruik te verminderen door de discrete GPU kaart te verwijderen (na installatie van het systeem), maar dit moederbord hangt bij het opstarten als er geen GPU is aangesloten! Door wat rond te googelen ontdekte ik dat deze toestand vrij typisch is voor consumenten moederborden. Als ik naar de cijfers van xblax kijk, kan hij betere stroomniveaus in rust bereiken (ok, het moederbord is niet precies hetzelfde...).

2) Ik kan een C10-status bereiken voor alle cores (meest rechtse kolommen in powertop), maar het pakket C-status dat wordt bereikt in idle hangt af van welk PCIe-slot wordt gebruikt voor de discrete GPU. Door het eerste PCI-slot te gebruiken dat wordt bediend door de CPU-lanes kom ik 99% van de tijd niet verder dan pakket C2-status: in deze configuratie is het gemiddelde stroomverbruik stabiel onder de 26W. Als ik de GPU verplaats naar een van de andere slots die bediend worden door de B760 chipset lanes, bereikt de pakket C-state ongeveer 7% (C2) en 91% (C3), het gemiddelde vermogen daalt tot onder de 22W maar is minder stabiel.

Is er een kans om het resultaat te verbeteren of is het beter om de 12100 CPU (met GPU) te kopen?

sh -c "echo 1 > /sys/bus/pci/devices/0000:01:00.0/link/l1_aspm"

(je moet 0000:01:00.0 vervangen door de corespondentie van jouw Realtek-kaart, uit lspci -vv)

Als je het probeert, kun je ons dan laten weten naar welke C State en Watt usage je gaat? :)

Ben je ook overgestapt op een iGPU en heb je de oude GPU verwijderd?

Ik zag dat ook iemand met een MSI PRO B760M-A WIFI DDR4 (die hetzelfde lijkt te zijn als de ASUS), hetzelfde probleem heeft, ook hetzelfde met de Asrock B760M Pro RS/D4.

Ik kon ongeveer 13-14W bereiken met dat bord door ASPM L1 te gebruiken op de 2,5Gbit poort, alle BIOS-instellingen en "powertop --auto-tune".

Geen USB / scherm aangesloten, alleen CPU (12600) en 1 Samsung 980 Pro Nvme in een chipset slot, proxmox draait in idle.

Ik gebruik momenteel echter een Be quiet! Dark Power Pro 11, die volgens mij niet erg energiezuinig is bij die lagere belastingen. Ik denk erover om op zoek te gaan naar een gebruikte Corsair RM750(/x)/RM650(/x).

Je kunt een goede test opzoeken op tweakpc.de

Super goed artikel, bedankt voor al deze informatie.

Ik ben van plan mijn nas te bouwen. Aangezien het stroomverbruik het belangrijkste onderwerp is, wat denk je van de volgende bouw (maar ik ben een beetje een noob over het systeem en wat er mogelijk is en/of de beperkingen van zo'n lage tdp chip)?

Asrock N100M micro ATX (met de nieuwe Intel® Quad-Core Processor N100 (tot 3,4 GHz) met een 6W tdp. Aangezien er slechts 2 sata-poorten zijn, is het idee om een SAS HBA-kaart met 8 extra SATA-poorten toe te voegen op de 1 x PCIe 3.0 x16-sleuf. Voor de opslag zou het gaan om 1 M2 (die van het moederbord) voor TrueNas OS, 2 SSD mirroring sata voor VM, docker, ... en 8 HDD Seagate EXO 7200 rpm schijven als laatste stap (2 in het begin en dan evoluerend op basis van de behoefte).

Voor de voeding, een Seasonic Focus PX 550W - Modular 80+ Platinum ATX en tot slot een unieke stick van 32GB ram (niet ECC).

Alvast bedankt

Wat betreft de SAS HBA kaart, zou ik aanraden om eens rond te kijken om te zien wat voor idle stroomverbruik anderen zien op de specifieke kaart die je overweegt: de populaire kaarten trekken vaak een paar watt terwijl ze absoluut niets doen. Ik weet niet zeker hoe *BSD met de kaarten omgaat, maar van de weinige die ASPM standaard ingeschakeld lijken te hebben, lijkt Linux het op een gegeven moment in de kernel uit te schakelen vanwege problemen. Dat gezegd hebbende, dit is een situatie waarin de ASRock N100 het misschien beter doet dan een aparte CPU/moederbord combo, omdat ik verwacht dat het minder gevoelig is voor c-state implicaties van een uitbreidingskaart, hoewel dit slechts een gok is gebaseerd op wat ik zag met mijn ASRock J4x05 borden en misschien niet van toepassing is op de N100.

De Seasonic PX 550W lijkt een goede keuze.

Over het geheel genomen ziet het er solide uit!

Heb je nog tips voor het identificeren van moederborden met een laag energieverbruik? Mensen raden soms ITX moederborden aan, maar ik heb geen metingen gevonden over hoeveel watt ITX vs ATX meestal bespaart. Nu zou ITX niet hebben gewerkt voor deze build, maar ATX lijkt toch geen significante bron van stroomverbruik te zijn geweest. In het algemeen lijkt het erg moeilijk om uit te zoeken welke moederborden energiezuinig zijn en welke niet?

Wat bedoel je met "de E-core silicium overhead" en waarom heb je die proberen te vermijden? Ik begrijp dat de CPU's met E-cores waarschijnlijk complexer zijn, maar ik had gedacht dat de E-cores tot een lager energieverbruik zouden kunnen leiden wanneer de CPU niet-intensieve taken uitvoert bij lage belasting.

Nogmaals, bedankt voor de geweldige informatie. Ik hoop een systeem te kunnen bouwen met een vergelijkbare energie-efficiëntie. Op dit moment heb ik een Gigabyte Z790 UD AX moederbord en een i5-13500 systeem dat ik niet onder de 28W krijg.

Het voordeel van ITX is dat het de neiging heeft om het aantal componenten te beperken, maar het is niet strikt noodzakelijk - vorige week heb ik de "Intel i3-10320 op een Gigabyte H470M DS3H" die ik in het begin noemde opnieuw gebruikt en ik kreeg het terug naar 6 watt idle (headless, geen toetsenbord, onboard Intel i219V 1GbE netwerk alleen, c-states in BIOS, 3 Samsung SATA SSD's 840/860/870, Corsair RM850 voeding, Ubuntu Server met powertop). Het is een zeer utilitair moederbord. Ik zal geen aparte write-up doen omdat het bord niet langer beschikbaar is, maar 6 watt op dat MicroATX Gibabyte H470 bord en 7 watt op het ATX ASUS H770 bord in deze write-up zijn mijn beste 2 resultaten tot nu toe en opvallend genoeg waren geen van beide ITX. Iets anders wat me net opviel: beide borden hebben slechts 6 voedingsfasen.

Over de "E-core silicon overhead" zijn veel details te vinden op https://www.hwcooling.net/en/the-same-and-yet-different-intel-core-i5-12400-duel-h0-vs-c0/ , maar ik zal proberen een samenvatting te geven. De i5-12400 wordt geleverd met 6 P-cores en 0 E-cores ingeschakeld, meestal aangeduid als 6+0. Hij is er echter in 2 varianten: een "C0" stepping die oorspronkelijk een 8+8 was die cores had afgesmolten om een 6+0 te worden, en een "H0" stepping die direct als een 6+0 werd gefabriceerd en nooit E-core hardware had. In de tests (pagina 5 van dat artikel) gebruikte de C0 tot 16 watt meer stroom dan de H0, afhankelijk van de benchmark, waaronder bijna 11 watt meer in ruststand. Het is altijd mogelijk dat hun C0 sample andere problemen had die stroomlekkage veroorzaakten, of dat er een andere variabele in het spel is, maar hoe dan ook deden de 2 chips met fysieke E-Cores hardware het niet goed in de idle test.

Omdat ik me voor de meeste van mijn systemen richt op extreem laag stationair verbruik, kan ik het niet rechtvaardigen om een van de gecombineerde P/E-core chips te kopen totdat ik gegevens zie die laten zien dat chips met E-cores minder dan 10 watt stationair verbruiken. En dat heb ik nog niet. Dit is een gebied waar Intel tegenwoordig erg bedreigd wordt: de AMD Mini PC's komen nu tot ongeveer 6-7 watt stationair stroomverbruik voor een Ryzen 9 7940HS ( https://youtu.be/l3Vaz7S3HmQ?t=610 ) en als AMD dit soort APU-ontwerpen naar de desktopkant brengt of iemand als ASRock begint een aantal van deze indrukwekkende HS-chips te verpakken in een aangepast moederbord, zou Intel de markt voor laag stationair stroomverbruik snel kunnen verliezen.

Ik zie dat het moederbord dat ik heb gekocht waarschijnlijk niet ideaal is (het adverteert veel fasen).

Dat gezegd hebbende, zelfs als je bord veel inefficiënte MOSFET's zou hebben, lijkt het stroomverbruik van 28 watt dat je zegt te krijgen een beetje hoog, tenzij je last hebt van draaiende roest of een PCIe-kaart die veel stroom verbruikt. Heb je gecontroleerd of je C6 of betere vermogenstoestanden hebt? Herinner je dat toen ik de ASM1166 op de belangrijkste PCIe-sleuf plaatste, ik beperkt was tot C2 en 22 watt verbruikte.

Je hebt inderdaad gelijk dat de 28 W die ik deelde niet zo goed was als het maar kon. Ik maakte de fout te denken dat het loskoppelen van de SATA-kabels van mijn HDD's ervoor zou zorgen dat ze uitgeschakeld zouden blijven. Zoals achteraf duidelijk is, moet je ze ook loskoppelen van de PSU. Bovendien had ik een heleboel randapparatuur op de pc aangesloten waarvan ik me niet realiseerde dat die stroom zou verbruiken (met name een ingeplugde monitor maakt een groot verschil). Na het loskoppelen van alle HDD's en alle randapparatuur krijg ik waarden tussen de 8-10W.

Om dit hopelijk een nuttig gegeven te laten zijn voor anderen zal ik wat meer details geven. De CPU is een i5-13500 in een Gigabyte Z790 UD AX moederbord. Het enige dat is aangesloten is een SATA SSD en een enkele stick geheugen. De PSU is een 850W Corsair RM850x. Het systeem haalt C8 en zelfs C10. Er zouden nog een paar dingen gedaan kunnen worden om het stroomverbruik te verminderen. Ik heb gemeten terwijl Gnome stationair draaide (ik neem aan dat als er geen DE actief is, dit een klein beetje CPU bespaart), ik heb twee CPU ventilatoren die langzaam draaien, zelfs bij lage temperaturen, het systeem staat op WiFi (ik neem aan dat ethernet minder stroom verbruikt), en ik heb case LED's en HD Audio niet uitgeschakeld.

Ik ben nu erg blij met het niveau van stroomverbruik. Misschien is een van de conclusies dat Intel E-cores niet veel invloed hebben op het stroomverbruik in rust, in ieder geval niet bij deze CPU. Het enige probleem dat ik nu heb is dat het systeem instabiel is en sporadisch opnieuw opstart 😭. Ik denk dat ik het probleem heb teruggebracht tot een defecte CPU of een defect moederbord (ik heb geprobeerd de PSU te vervangen en memtest86+ zegt dat het geheugen in orde is). Het bedrijf waar ik de onderdelen heb gekocht beweert dat beide in orde zijn, maar tenzij ik een andere oplossing vind zal ik proberen de CPU en het moederbord te vervangen door wat low-end onderdelen: een 13e gen i3 en een Asus B760M-A moederbord. Als dat het probleem verhelpt, kan ik hopelijk de andere onderdelen retourneren, in het ergste geval gebruik ik de budgetonderdelen voor een server en de duurdere onderdelen voor een werkstation.

Ik heb precies dezelfde opstelling (i5-13500 + Z790 UD AX), mijn opstartschijf is Samsung 990 pro 4TB

en ik heb precies hetzelfde probleem - sporadisch opnieuw opstarten. Heb je kunnen vinden wat de oorzaak is?

Ik heb de nieuwste BIOS F9b geprobeerd, evenals F5 en het wijzigen van meerdere BIOS-instellingen, maar tot nu toe helpt niets. Mijn vermoeden is dat de opstartschijf in een spaarstand gaat en niet in staat is om daarvan te herstellen, maar ik weet niet hoe ik dat moet bewijzen.

Er zijn geen gebeurtenissen voor de crash, ik heb ook netconsole geconfigureerd - nog steeds niets gelogd.

Met de nieuwste BIOS, standaardinstellingen en de 970 evo plus als opstartapparaat (geen andere schijf aangesloten) lijkt het systeem stabiel, maar helaas trekt het gemiddeld 32W tijdens stationair draaien, wat niet acceptabel is.

Op dit moment verander ik één instelling per keer en wacht ik meer dan 12 uur om erachter te komen wat de echte oorzaak is en dat kost veel tijd.

Ik heb alle instellingen geprobeerd, zodra ik c8/10 inschakel, wordt het systeem onstabiel en valt het op een gegeven moment uit. Ik heb alle schijven en kabels gecontroleerd, de processor twee keer vervangen en wacht momenteel op een cpu RMA van Intel. Afgaande op deze thread hier lijkt het erop dat dit een gigabyte probleem is, ik heb ook verschillende BIOS firmwares geprobeerd zonder enig geluk, dus het lijkt erop dat als een CPU RMA het niet oplost, het een probleem is met Gigabyte z790 moederborden.

Teleurstellend, want ik heb geen retourneringssysteem meer en wil echt geen RMA van Gigabyte, dus als CPU RMA niet werkt, moet ik er maar mee leven of het bord verkopen en een ander bord kopen.

Aangezien deze thread een beetje oud is (dec 2023), vraag ik me af of iemand anders dit probleem heeft gehad en het heeft kunnen oplossen.

Hartelijk dank.

Ik test momenteel een ASUS TUF GAMING B760M-PLUS WIFI D4 (12+1 DrMos) en in idle, met de monitor en USB (muis, toetsenbord) aangesloten, toont de stroommeter 6,7-8,1 W. De rest van het systeem:

- i5 13500

- 2 x 16 GB 3600 MHz (versnelling 1)

- 1 TB KC 3000

- RM550x 2021

- 2 x 120 mm ventilatoren @ 450 rpm

- audio codec aan

- WiFi uit

Arch Linux + RTL8125 module (mijn router ondersteunt geen EEE)

Met de Realtek-kaart uitgeschakeld geeft de stroommeter 6,4 - 6,7 W aan

PC-toestanden met LAN

C2 (pc2) 0,7%

C3 (pc3) 1,3%

C6 (pc6) 41,1%

C7 (pc7) 0,0%

C8 (pc8) 0,0%

C9 (pc9) 0,0%

C10 (pc10) 55,8%

PC-staten zonder LAN

C2 (pc2) 0,6%

C3 (pc3) 0,9%

C6 (pc6) 0,0%

C7 (pc7) 0,0%

C8 (pc8) 0,0%

C9 (pc9) 0,0%

C10 (pc10) 97,8%

Ik had vergelijkbare resultaten op een B660 AORUS MASTER DDR4 (16+1+1).

Ik heb onlangs een i3-13100 (4+0) en een i3-13500 (6+8) gekocht om de "E-core overhead" claims die ik online heb gezien te testen. Ik ben blij te kunnen melden dat het stroomverbruik in ruststand voor beide chips identiek is! Misschien is het probleem van het verhoogde stroomverbruik uniek voor de i5-12400 C0, helaas heb ik er geen bij de hand om te testen.

4W vermogensverlies

Ik gebruik momenteel een off-lease quanta 1u die ik van ebay heb geplukt net voordat covid opkwam en zijn single-core prestaties tonen echt zijn leeftijd. Hij draait ook stationair op 80W >.

Ik wil graag mijn ervaring delen met mijn nieuwe 12-14 W pc.

Ik heb net een ventilatorloze mini-ITX pc gebouwd. De behuizing is ook een passieve koeler - AKASA Maxwell Pro en binnenin zit AMD Ryzen 5600G (Zen 3, 65W TDP), Gigabyte B550I AORUS PRO AX (bios FB), 1x 16GB DDR4 (ik ben van plan om te upgraden naar 2x32GB), 1x 2TB Samsung 980Pro m.2 SSD. De voeding is 12V AC/DC van AKASA (max. 150W) en Inter-Tech MINI-ITX PSU 160 W.

12-14W stationair stroomverbruik voor de hele pc onder Windows 10 (gemeten aan de DC-kant, energieplan is gebalanceerd, maar ik heb ASPM, Pstates en C-states ingeschakeld in de bios en PCIe-energiebesparing in de geavanceerde instelling van Windows Power Plan).

Onder belasting (Cinebench R23) 61-65W. Momenteel ben ik bezig met undervolting om een beter stroomverbruik en betere temperaturen te krijgen.

----------

Mijn kleine thuislab en NAS verbruiken minder dan 2W inactief vermogen ‼️

Ik raad Odroid H3 (H3+) aan met BIOS 1.11 en Debian 11 + DietPi + kernel 6.0.0 (of nieuwer) + toegepaste tweaks via powertop. Het heeft een idle stroomverbruik van slechts 1,2 - 1,5W (vergeleken met 2,7W voor RPi 4 - source) ⚡️ (met mijn configuratie: 1x 16GB RAM en 1x SATA SSD).

See: https://i.ibb.co/7QD390m/H3-1-10-6-0-0-sata-idle.gif

Het maximale geheugen is 64 GB RAM en het heeft 1x m.2 poort, 2x SATA 3 en 2x LAN 2.5Gbps. Hij is veel sneller dan Raspberry Pi 4 met een lager stroomverbruik in ruststand. Bij belasting kan hij 20 W verbruiken (afhankelijk van aangesloten apparaten).

Als je meer SATA-poorten nodig hebt, kun je de m.2-poort uitbreiden tot 5x SATA met dit: https://wiki.odroid.com/odroid-h3/application_note/m.2_to_sata_adapter

Ik ben momenteel aan het worstelen om mijn nieuwe NAS minder dan 40W te laten verbruiken in ruststand zonder gegevensschijven, en ik kan maar niet begrijpen waarom hij zoveel verbruikt. Mijn gaming desktop verbruikt minder stationair.

Het is een Asrock H670M-ITX/ac met een i3-12100, 8GB RAM, een stille 400W PSU. Oorspronkelijk gebruikte ik een Kingston NV2 NVMe voor het besturingssysteem, maar toen ik die verving door een SATA SSD bleek het stationaire vermogen met ongeveer 10 W te zijn afgenomen (50 W - > 40 W).

Volgens powertop komen de kernen zonder problemen in C7, maar het pakket weigert C2 te verlaten. Ik weet niet zeker hoe belangrijk dat is.

Ik zal eraan blijven werken, met jouw artikel als referentie :)

Matt,

Je artikelen inspireerden me, dus kocht ik hetzelfde moederbord (prime h770 plus d4) en vergelijkbare processor enz. Ik kon minimaal 12-14w bereiken. Voorlopig ben ik daar blij mee, maar de extra 8w als gevolg van het pakket dat c8 niet meer haalt, is erg frustrerend. Heb jij iets soortgelijks gezien in jouw bouw?

Verschillende onderzoeken hebben uitgewezen dat het een aandrijvingsprobleem is met RealTekLAN. Als je drivers voor de 8125 chipset downloadt en installeert van de Realtech site, kun je c10 bereiken zoals voorheen.

Je zou een andere PSU moeten overwegen, zoals de Corsair RM550x (2021) of BeQuiet 12M 550W. De Corsair is de beste voor laagvermogenopstellingen, maar is erg moeilijk verkrijgbaar. Deze zal het stroomverbruik nog verder verlagen (2 tot 4 watt).

Deze en andere tweaks worden in dit topic genoemd:

https://forums.unraid.net/topic/98070-reduce-power-consumption-with-powertop/

Helaas was dit een opzettelijke wijziging van het Realtek stuurprogramma in de kernel. Het zorgt ervoor dat L1 is uitgeschakeld op vrijwel elke Realtek adapter, schijnbaar als reactie op een aantal Realtek adapters die stabiliteitsproblemen ervaren wanneer deze lage energie staten zijn ingeschakeld. Op mijn huidige testsysteem resulteert dit in een vermogenstoename van 4 watt in idle met het scherm in de sluimerstand omdat het systeem niet verder gaat dan C3.

Het proberen van het Realtek stuurprogramma dat werd gelinkt door Tseting is waarschijnlijk de eenvoudigste oplossing voor nu, hoewel ik geen idee heb hoe het zal gaan met niet-ondersteunde kernelversies en ik persoonlijk geen grote fan ben van kernelmodules. Voor het gemak plak ik het hier: https://www.realtek.com/en/component/zoo/category/network-interface-controllers-10-100-1000m-gigabit-ethernet-pci-express-software

Er is natuurlijk een moeilijkere workaround - voor degenen die bekend zijn met het compileren van de kernel, zal het terugdraaien van de verandering in de diff hierboven L1/L1 herstellen. 1 herstellen op RTL8168h/8111h, RTL8107e, RTL8168ep/8111ep, RTL8168fp/RTL8117, en RTL8125A/B apparaten (alles wat ouder is had het al uitgeschakeld) - als je L1.2 wilt toestaan kun je rtl_aspm_is_safe() dwingen om true terug te geven, hoewel dit op mijn testsysteem geen voordeel bood ten opzichte van L1.1.

Tenzij de kernelontwikkelaars van gedachten veranderen, lijkt het erop dat Intel NIC's de enige haalbare optie zijn. Intel 1G NIC's zijn over het algemeen erg solide. Verontrustend genoeg ontdekte ik dat het uitschakelen van de Realtek NIC op mijn MSI bord het niet volledig loskoppelde (het bleef hangen op C3) dus het kopen van een bord met een Realtek NIC met plannen om het uit te schakelen en een Intel netwerkuitbreidingskaart te gebruiken kan riskant zijn. Het is de moeite waard om op te merken dat in de toekomst leveranciers een vlag kunnen instellen op een 8125A/B adapter om aan te geven dat L1.2 getest en toegestaan is, wat de Linux kernel zal respecteren, maar ik weet niet of dit al op moederborden of uitbreidingskaarten is toegepast.

bedankt voor de gedetailleerde informatie die je hebt gedeeld.

Je setup heeft me geïnspireerd en ik heb de "Prime h770-plus" gekocht, inclusief 4800 DDR Ram.

Helaas heb ik ook problemen met NVME SSD's wanneer aspm is ingeschakeld in de bios (en PCI express clock gating). De workarounds om bepaalde energiebesparende modi van de WD's te blokkeren hielpen niet. Ik heb de SN750 (1tb) en de SN850X (2tb) geprobeerd.

Kun je nog steeds de Crucial P3 aanraden of faalt deze ook regelmatig met betrekking tot ASPM problemen?

Wie heeft welke andere NVME op het bord betrouwbaar draaien met ASPM ingeschakeld?

Draai je de setup productief in continue werking?

Daarnaast heb ik gemerkt dat een 840pro (256gb) op zijn minst op SATA1 voorkomt dat het systeem lager gaat dan C3. Een Crusial Force GT (128 GB) daarentegen werkt tot C8.

Ik heb het probleem met de Realtek NIC opgelost door de controle in de kernel te verwijderen.

Bedankt en met vriendelijke groeten

Ik heb nu een Samsung 990 pro geprobeerd. Helaas leidt dit nog steeds tot de al bekende nvme aspm fouten.

Heeft iemand anders nog ideeën?

Aan de voeding kan het niet echt liggen (dat zou ik erg vreemd vinden), want hier wordt tijdelijk een Corsair cx 750 gebruikt.

Als niets helpt, heeft iemand dan een goed alternatief bord?

Op de een of andere manier steek ik te vaak mijn voet in mijn mond als het om hardware gaat ;-(.

Op zich is het een ECHT efficiënte nvme-schijf voor maar een paar dollar. Maar wat hem uitstekend maakt voor ons gebruik is de mogelijkheid om elke cpu tot c10 te laten draaien met een paar bios-instellingen.

"Ik denk dat je een hoop hoofdpijn had kunnen voorkomen als je een bord had gevonden met meer sata-poorten!"

Dat is niet standaard waar - want het ligt eraan welke SATA-controller wordt gebruikt en/of hoe deze poorten zijn aangesloten. De kans is groot dat er een onboard controller wordt gebruikt, en specifiek voor de N5105 is er een bekende NAS-variant met 6 SATA-poorten die wordt verkocht door Kingnovy en Topton.

De zwarte gebruikt JMS585 en de groene print gebruikt ASM1166 - de zwarte zit vast aan C3 en de groene kan tot C8 gaan (zelf geverifieerd omdat ik de groene variant heb). Als ik iets meer nodig zou hebben dan een backupserver, dan zou ik deze route kiezen - met een veel krachtiger Intel op LGA1700.

Een goed voorbeeld van hoe laag je kunt gaan met idle stroomverbruik is de Odroid H3 - <2W idle met 2x HDD's via SATA in Spindown ... maar zodra je (de verkeerde) componenten toevoegt zal dat snel versnellen - bekijk de stroomverbruik statistieken hier:

https://github.com/fenio/ugly-nas

TLDR: Uiteindelijk verbruikt het meer stroom dan jouw build hier - en ik moet er aan toevoegen dat ik eerder een Odroid H2 had, die hun 5V lane verbrandde en de (dure) SSD's meesleurde ... sindsdien blijf ik weg voor het absolute maximum van het laagste stroomverbruik in exotische combinaties zoals de Odroid H3.

Ik zou zeggen dat het uiteindelijk allemaal neerkomt op - hoe praktisch alles is versus de niveaus van stroomverbruik.

Dat gezegd hebbende ben ik onder de indruk van deze bouw - 7W idle met een 750W PSU is heel wat.

Ik ben momenteel mijn homeserver aan het upgraden van j3455 naar 11400.

Tijdens het overschakelen van hardware vond ik een vreemd probleem:

I5-11400+2x8Gb 2666 ddr4 +ASUS Prime B560M-A (laatste bios) +asm1166.

Als ik opstart vanaf USB zonder dat er sata drives zijn aangesloten bereikt pakket C status c8.

Als ik opstart vanaf USB met een SATA drive aangesloten op de onboard sata controller bereikt pakket C status alleen C2 (+4W).

Als ik opstart vanaf USB met een SATA-schijf aangesloten op een pcie asm1166 bereikt pakket C status c8.

Voor mij lijkt het er dus op dat de b560 SATA-controller problemen heeft met energiebesparing. Zelfs als ik L1 voor alles heb ingeschakeld en powertop tune heb uitgevoerd, komt hij niet onder c2.

Heb je een idee wat de oorzaak zou kunnen zijn dat de b560 SATA-controller 4w meer verbruikt?

Uiteindelijk kan het goedkoper zijn om nog een ASM1166 toe te voegen in plaats van de onboard controller :D

- Controleer of SATA Link State Power Management is ingeschakeld (op mijn H770 onder Advanced/PCHStorageConfiguration/AggressiveLPMSupport).

Dit is ingeschakeld, ik heb het ook geprobeerd met uitgeschakeld, maar het veranderde het stroomverbruik of de C-states niet. (Ik laat het voorlopig ingeschakeld)

- Op de pagina van het ASUS Prime B560M-A moederbord staat dat de SATA_2 poort bandbreedte deelt met het M.2_2 slot. Ik weet niet hoe dit intern wordt afgehandeld, maar als u bent aangesloten op SATA_2, probeer dan een van de andere SATA-poorten op het moederbord.

In het BIOS kan ik aangeven of M.2_2 SATA of PCIE gebruikt. Volgens het BIOS en de handleiding wordt SATA6G_2 alleen geblokkeerd als M.2_2 is ingesteld op SATA.

Maar ik heb de ASM1166 aangesloten in M.2_2 en geconfigureerd als PCIE. Ik heb bevestigd dat alle onboard SATA-poorten werken zoals verwacht met deze instelling.

- SATA Hotplug uitschakelen (xblax noemde dit hierboven)

Hotplug is standaard uitgeschakeld voor alle poorten. Ik heb het ingeschakeld om te zien of het iets verandert, maar dat deed het niet. Ik laat het voorlopig op Uitgeschakeld staan.

- Probeer een andere SSD als je er een hebt om te zien of er een verschil is (SaveEnergy noemde dit hierboven)

Ik heb opgestart vanaf USB en verschillende apparaten geprobeerd: 2x SSD's (Emtec en oudere Samsung), 2x 3,5" HDD's (WD en Seagate) en zelfs 1x LG DVD brander.

Het lijkt erop dat het niet uitmaakt wat voor apparaat is aangesloten.

Het is altijd hetzelfde, zodra ik een apparaat aansluit via SATA is onboard C2 maximaal.

Om dit te verifiëren heb ik opgestart vanaf een USB-stick met aangesloten SATA-apparaten, en ze vervolgens allemaal losgekoppeld tijdens het opstarten.

Zodra het laatste SATA-apparaat fysiek wordt losgekoppeld van het live systeem, gaat het onmiddellijk naar pc6 en kort daarna naar pc8.

Bij het opnieuw aansluiten van alle SATA apparaten blijft het in PC6/8 maar ook dmesg herkent de replug niet (waarschijnlijk omdat hotplug is uitgeschakeld).

Ik zal door dmesg boot logs kruipen, misschien komt er iets interessants tevoorschijn.

-m.2 slot van het mobo werkt (getest met m.2 ssd)

-sata controller werkt (getest met m.2-pcie adapter&x16 slot van het mobo en m.2 slot van een andere minipc)

Maar met asm1166 aangesloten op m.2-sleuf, verschijnt er niets in bios of lspci.

Het lijkt er dus op dat het Asrock-bord een probleem heeft.

Ik weet niet hoe ik verder moet gaan

Ik begrijp ook één ding niet in het algemeen: als ik de thuisserver gebruik als NAS, maar ook als mijn router, zou dat dan voorkomen dat ik hoge c-toestanden bereik in ruststand, gezien het feit dat hij altijd wat werk moet doen? Ik heb een gigabit verbinding en ik gebruik momenteel openwrt op een pi4 maar met qos ingeschakeld kan ik de helft van de downloadsnelheid halen.

Nogmaals bedankt.

Wat betreft het feit dat het een router is, weet ik het niet zeker, hoewel het iets is dat ik in de komende weken hoop uit te testen. Momenteel heb ik de oude ASRock/Intel J4005B-ITX die OpenWRT draait als router, maar de moederbordlimiet is C6 (hoewel hij daar 88-92% van de tijd doorbrengt na powertop met typisch thuisverkeer, inclusief een YouTube stream die ik zojuist heb getest). Het ding wordt gevoed door een van mijn oude Antec PSU's en deze staat betrouwbaar op een constante 10 watt.

EDIT/UPDATE 13 dec: Om op te volgen, ik heb wat tests gedaan met de Asus H770 + i3-12100 + Intel i350-4T met OpenWRT in een systemd-nspawn container met privileged met SYSTEMD_SECCOMP=0. De resultaten zijn een beetje rommelig.

Als je niets doet, staat het 90-95% van de tijd in C10.

TEST A: Met slechts 1 apparaat dat YouTube bekijkt, 90% C10. Verbonden met zeer licht huishoudelijk verkeer (piekerig met minder dan 3Mbit/s gemiddeld) zat het 80-90% van de tijd in C10. Bij het downloaden van een van mijn webservers, waarbij de snelheid is begrensd op 4MB/s (ruwweg 32Mbit/s), zakte het naar ongeveer 50-60% in C10.

TEST B: iperf-tests uitvoeren vanaf een externe VPS naar een lokale machine (poort doorsturen):

- 0Mbps = ongeveer 82% C10 (alleen huishoudelijk verkeer)

- 1Mbps = ongeveer 73% C10

- 5Mbps = ongeveer 61% C10

- 10Mbps = ca. 58% C10

- 20Mbps = ca. 30% C10

- 30Mbps = ongeveer 12% C10

...het bereikte 0 bij iets meer dan 40Mbps.

TEST C: Interessant genoeg bood het passeren van de router tussen 2 lokale netwerken (geen NAT, alleen doorsturen) andere resultaten:

- 0Mbps = ongeveer 82% C10 (alleen huishoudelijk verkeer)

- 1Mbps = ongeveer 82% C10

- 5Mbps = ongeveer 80% C10

- 10Mbps = ca. 74% C10

- 20Mbps = ca. 70% C10

- 30Mbps = ongeveer 64% C10

...het bereikte 0 bij iets meer dan 70Mbps.

Aangezien ik in een nspawn container zit, was ik niet in staat om software flow offloading in de firewall sectie van OpenWRT te proberen om te zien of het de impact in test A en B zou verzachten - het is heel goed mogelijk dat de "flow offloading" die het doet de resultaten dichter bij test C zou brengen. Het is ook mogelijk dat IPv6 het beter zou doen in test A en B door NAT over te slaan, hoewel de impact van kleinere-maar-meer pakketten altijd een spaak in het wiel zou kunnen steken.

Voor zover ik kan zien, is de conclusie hier dat er een bepaalde mate van verkeer is dat de computer als firewall aankan en toch mogelijkheden vindt om te slapen. Maar als hij wakker wordt gehouden... worden andere opties ook aantrekkelijk. Ik heb net de Intel J4005 opnieuw getest (aangesloten op niets anders dan een monitor) en hij zit op 9-10W in OpenWRT zelfs als C-States uitgeschakeld zijn, en ik vermoed dat de J5xxx series vergelijkbaar zouden zijn (geen idee over N100). Als er wat meer pit nodig is, mijn Ryzen 5600G doet 22-23W op een Ubuntu LiveDVD met C-states uitgeschakeld. Beide modellen beginnen er even aantrekkelijk uit te zien zodra Alder Lake zijn C-state voordeel verliest.

EDIT/UPDATE 15 dec: Bare metal, Debian geconfigureerd als router. TEST B was bijna identiek behalve dat de tijd in C10 +6% was voor elk item - raakte nog steeds de harde muur net boven de 40Mbps. Flowtabellen hielpen niet.

Test C deed het iets beter, met de uiteindelijke cijfers als volgt:

- 70Mbps = ongeveer 70% C10

- 75Mbps = ongeveer 60% C10

- 80Mbps = 0% C10 (hier een harde muur geraakt)

Toen ik flowtabellen inschakelde voor Test C, kon ik er nog iets meer uithalen:

- 80Mbps = ongeveer 60% C10

- 85Mbps = ongeveer 45% C10

- 90Mbps = 0% C10 (hier een harde muur geraakt)

TEST D: Om het effect van een toenemend aantal verbindingen te testen, startte ik een torrentclient en voegde ik een aantal torrents toe met een begrensde globale downloadsnelheid van 1 MB/s.

- 0 verbindingen = ongeveer 80% C10 (alleen huishoudelijk verkeer)

- 16 verbindingen = gevarieerd 36-39% C10

- 32 verbindingen = gevarieerd 33-35% C10

- 64 verbindingen = gevarieerd 26-29% C10

- 128 verbindingen = gevarieerd 21-29% C10

- 256 aansluitingen = ongeveer 20% C10

- 512 aansluitingen = ongeveer 15% C10

- 1024 verbindingen = ongeveer 5% C10

...Ik heb flowtabellen geprobeerd op verschillende punten. Geen positief verschil.

Tijdens deze reis kwam ik een paar interessante ontdekkingen tegen.

Ten eerste hielpen flowtabellen helemaal niet. Het leek er zelfs op dat online snelheidstests iets minder piekten. Misschien is het iets specifieks voor de Intel i350-T4 die ik gebruikte (in een Debian bare metal H770 en een OpenWRT bare metal J4005).

Ten tweede was OpenWRT in een container geen prettige ervaring. Ik had vreemde problemen waarbij sommige verbindingen goed waren en andere problemen opleverden. Misschien kan het met genoeg tweaken en overhalen soepel werken. Ik ontdekte dat een VM 2-2,5% CPU full-time at op een kale installatie en niet gemakkelijk was voor de C-states, dus daar ben ik niet verder op ingegaan.